一、KITTI数据集(车端-机械)

KITTI官网

The KITTI Vision Benchmark Suite

KITTI论文

https://www.cs.toronto.edu/~urtasun/publications/geiger_et_al_cvpr12.pdf

- 简介

KITTI数据集是由德国卡尔斯鲁厄理工学院 Karlsruhe Institute of Technology (KIT) 和美国芝加哥丰田技术研究院 Toyota Technological Institute at Chicago (TTI-C) 于2012年联合创办,是目前国际上最为常用的自动驾驶场景下的计算机视觉算法评测数据集之一。该数据集用于评测立体图像(stereo),光流(optical flow),视觉测距(visual odometry),3D物体检测(object detection)和3D跟踪(tracking)等计算机视觉技术在车载环境下的性能。KITTI数据集包含市区、乡村和高速公路等场景采集的真实图像数据,每张图像中最多达15辆车和30个行人,还有各种程度的遮挡与截断。 KITTI数据集针对3D目标检测任务提供了14999张图像以及对应的点云,其中7481组用于训练,7518组用于测试,针对场景中的汽车、行人、自行车三类物体进行标注,共计80256个标记对象。

KITTI数据集采集车的传感器布置平面如上图所示,车辆装配有2个灰度摄像机,2个彩色摄像机,一个Velodyne 64线3D激光雷达,4个光学镜头,以及1个GPS导航系统,在上图中使用了红色标记。

2个一百四十万像素的PointGray Flea2灰度相机

2个一百四十万像素的PointGray Flea2彩色相机

1个64线的Velodyne激光雷达,10Hz,角分辨率为0.09度,每秒约一百三十万个点,水平视场360°,垂直视场26.8°,至多120米的距离范围

4个Edmund的光学镜片,水平视角约为90°,垂直视角约为35°

1个OXTS RT 3003的惯性导航系统(GPS/IMU),6轴,100Hz,分别率为0.02米,0.1°

SLAM方向一般对比00---10 11个序列

二、NTU VIRAL数据集(无人机-机械)

项目地址:GitHub - ntu-aris/ntu_viral_dataset

论文地址:https://arxiv.org/abs/2202.00379

- 简介

NTU VIRAL 数据集由新加坡南洋理工大学的研究团队精心打造,它针对自动驾驶飞行器的复杂需求,整合了多样化的传感器配置,包括两套3D激光雷达、双时间同步相机、多个惯性测量单元(IMUs)以及四套超宽带(UWB)节点,形成了一个全方位的感知系统。通过在多种室内及室外环境下进行飞行测试,NTU VIRAL捕获了一系列高质量的多模态数据。

三、NCLT数据集(移动机器人-机械)

项目网址:

The University of Michigan North Campus Long-Term Dataset

论文地址:

http://robots.engin.umich.edu/nclt/nclt.pdf

- 简介

这篇论文记录了一个大型长期自主性数据集,用于机器人研究,该数据集是在密歇根大学北校区收集的。数据集包括全向影像、3D 激光雷达、平面激光雷达、GPS 和用于里程计的本体感知传感器数据,这些数据由一台 Segway 机器人收集。该数据集的收集旨在促进针对在变化环境中长期自主操作的研究。数据集包含 27 次采集,间隔约两周,历时 15 个月。这些采集会多次探索校区,涵盖室内和室外,沿着不同的轨迹,且在不同的时间段跨越四个季节进行。这使得数据集能够捕捉到许多具有挑战性的因素,包括:运动障碍物(例如行人、自行车骑行者和汽车)、变化的光照、不同的视角、季节性和天气变化(例如落叶和积雪),以及由建设工程引起的长期结构性变化。为了进一步促进研究,我们还为所有采集提供了一个统一参考框架中的真实位姿数据。

四、MulRan数据集(移动机器人-机械)

项目地址

mulran-dataset · GitHub Topics · GitHub

论文地址

https://rpm.snu.ac.kr/publications/gskim-2020-icra.pdf

下载链接

- KAIST01

https://mail.google.com/mail/u/0/#inbox/FMfcgzQXKDZpCnwrbzWZfFXtDxTJwLSL

- KAIST02

https://drive.google.com/drive/folders/1Zp-nY-hPvSAAFG58Rz3kdVsUgVuthdqx

- KAIST03

https://drive.google.com/drive/folders/1o7Os9i0bnilLx2E2jh_RLRmJ6fgqqCas

https://drive.google.com/drive/folders/1i5tVknPwKqqRfOevAdc5qbuKhJx2uYVp

- DCC03

https://drive.google.com/drive/folders/168124V5x1tP90T-ZMFAZh4gB07ZBEZPj

- Riverside01

https://drive.google.com/drive/folders/1SizJz9RoYKyY0HRiUh2xxhEG_V4jV2GZ

- Riverside02

https://drive.google.com/drive/folders/1eW3-Z4_8VifUGE0BrCwNINzmiypkXu_a

- Riverside03

https://drive.google.com/drive/folders/1SBzsepyjYeV3OkzxzzMBdU2iokKqKMRJ

- Sejong01

https://drive.google.com/drive/folders/1xK6YS6ca4rtIEghoM8rTWf0H7cKXxqSf

- Sejong02

https://drive.google.com/drive/folders/14ff1a76NlPJZz-DGviaHkdDD6ElWdgIm

Sejong03

https://drive.google.com/drive/folders/1adTGCzPMNtGBdiDZrC8grztdlIZTAYxP

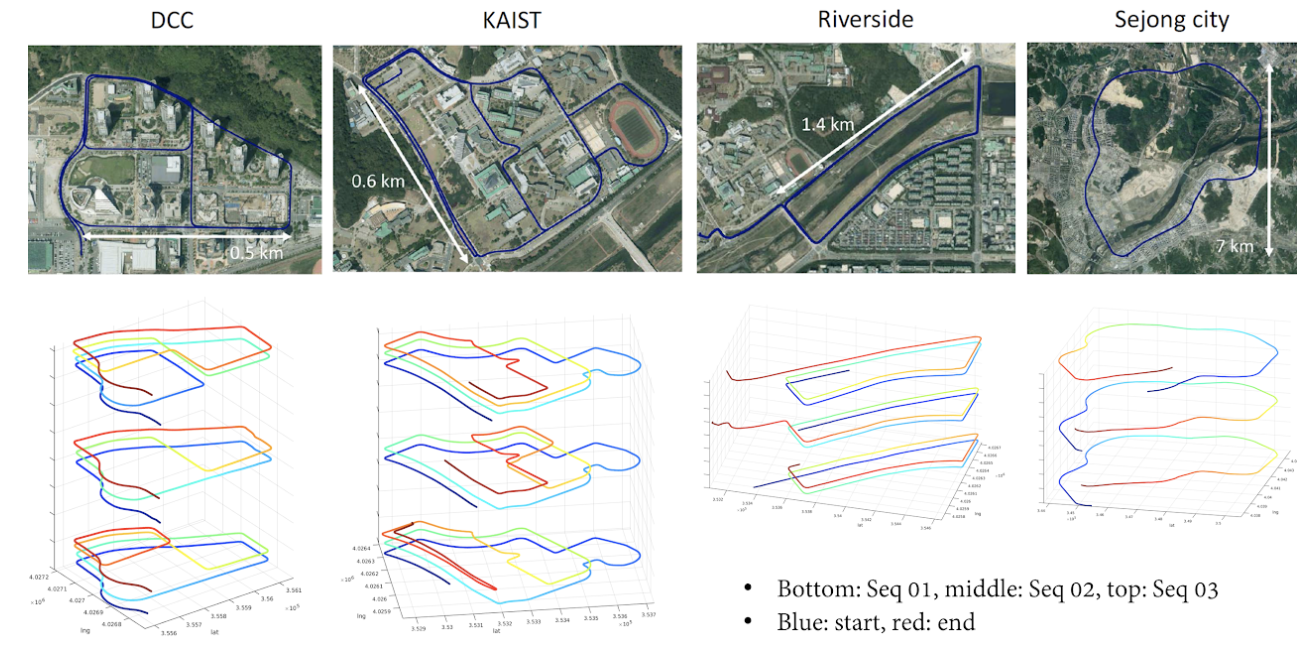

这篇论文介绍了一个多模态的范围数据集,专门针对城市环境中的无线电探测与测距(雷达)和激光雷达(LiDAR)。通过扩展我们之前的工作坊论文[1],这个数据集侧重于基于范围传感器的场所识别,并提供了用于场所识别基准真值的6D基准轨迹数据。提供的雷达数据包括原始级别数据和图像格式数据,其中包括一组时间戳标记的1D强度数组和360°极坐标图像。因此,根据研究目的,研究人员可以选择使用原始数据或图像数据。与现有数据集不同,我们的重点是捕捉范围基于的场所识别研究中的时间和结构多样性。为了评估,我们应用并验证了我们之前的定位描述符及其搜索算法[2],证明它们在雷达场所识别方法中非常有效。进一步的结果表明,雷达基于的场所识别方法由于其较长的测距能力,优于激光雷达基于的识别方法。

五、HILTI数据集(手持-机器人-机械-固态)

项目网址:

Hilti SLAM Challenge 2023 - Dataset

Hilti SLAM Challenge - Hilti AG

Hilti SLAM Challenge 2023 - Dataset

我们提出了Hitli SLAM挑战数据集。该数据集的目的是促进传感器融合的研究,以开发SLAM算法。该算法可以部署在需要高精度,毫米级和鲁棒性的任务中,例如在建筑环境中。我们的数据集包含建筑工地、办公室和实验室的室内序列以及建筑环境和停车场的室外序列。为了记录数据,我们创建了一套传感器,包括许多视觉、激光雷达和惯性传感器,使用商用传感技术的最新产品,特别关注时间同步和空间校准。该数据集用于Hitli SLAM挑战赛,许多学术和工业团体提交了他们的SLAM系统。挑战的结果表明,所提出的数据集可以成为开发准备在现实世界中部署的新SLAM算法的重要资产。

六、MARS-LVIG Dataset:数据集(无人机测绘-固态-视觉)

项目地址:

https://mars.hku.hk/dataset.html

近年来,激光雷达(LiDAR)技术的进展使得3D激光雷达传感器变得更加紧凑、轻便且价格更为实惠。这一进展激发了将激光雷达与惯性测量单元(IMU)和相机集成用于同时定位与地图构建(SLAM)研究的兴趣。公共数据集涵盖不同的场景、平台和视角,对于多传感器融合SLAM研究至关重要,但大多数数据集仅关注手持设备或车辆安装设备,且视角通常为前向或360度视角。从空中飞行器俯视的数据显示较为稀缺,现有相关数据集通常涉及低空飞行,并且多集中在小型校园环境中。为填补这一空白,我们引入了多传感器空中机器人SLAM数据集(MARS-LVIG数据集),该数据集提供了独特的空中俯视激光雷达-视觉-惯性-全球导航卫星系统(LiDAR-Visual-Inertial-GNSS)数据,飞行高度介于80米到130米之间。该数据集不仅提供了测试和评估现有SLAM算法的新视角,还带来了新的挑战,能够推动更先进SLAM算法的研究与发展。MARS-LVIG数据集包含21个序列,覆盖了多样的大型环境,包括航空模型飞行场、岛屿、乡村城镇和山谷。在这些序列中,UAV的飞行速度从3米/秒到12米/秒不等,扫描面积最大可达到577,000平方米,最大路径长度为7.148公里,并提供了完整的地面真实轨迹、传感器标定和时间戳数据,使得该数据集能够精确地进行基准测试和与其他SLAM系统的对比。

其实验室还有一些测试数据集但没有提供真值如下

- point-lio数据集(固态-剧烈运动)

- R3live数据集(固态-相机-退化)

七、Newer College Dataset (NCD数据集)(手持-机械-视觉)

- 项目地址

Thanks for your interest in the dataset! You can download the dataset from this location:

https://drive.google.com/drive/folders/15lTH5osZzZlDpcW7oXfR_2t8TNssNARS?usp=sharing

or

https://tinyurl.com/newer-college-dataset-2023

我们使用三脚架安装的测量级BLK360 LiDAR扫描仪,捕获了测试地点的详细毫米级3D地图(包含2.9亿个点)。通过这些地图,我们推导出每次LiDAR扫描时设备位置的厘米级6自由度(DoF)真实值。这使得我们能够更好地评估LiDAR和视觉定位、地图构建、重建系统。

这一真实值数据是该数据集的一个独特贡献,我们认为它将有助于系统性评估,解决许多类似数据集所缺乏的这一问题。该数据集结合了建筑环境、开放空间和植被区域,可用于测试定位和地图构建系统,如基于视觉的导航、视觉与LiDAR SLAM、3D LiDAR重建以及基于外观的地点识别。

八、SubT-MRS(机械-视觉-复杂场景)

网站地址

下载地址

https://drive.google.com/drive/folders/1hHCsnc-gANmK6Oox-Im3hqRwsGGaJIuJ

论文地址

https://arxiv.org/pdf/2307.07607

- 简介

SubT-MRS 数据集

多模态:我们的数据集包括来自4个RGB摄像头、1个LiDAR、1个IMU和1个热成像摄像头的硬件时间同步数据,提供多样且精准的传感器输入。

多样化场景:数据集收集自多个地点,展示了不同的环境设置,包括室内、室外、混合室内外、地下、越野和建筑等。

多重退化:通过结合多种传感器模态和挑战性条件(如雾、雪、烟雾和光照变化),数据集引入了不同级别的传感器退化。

异构运动学特征:SubT-MRS 数据集独特之处在于,包含来自不同车辆(如遥控车、四足机器人、无人机和手持设备)的时间同步传感器数据,且每种设备的运动速度范围各异。

2848

2848

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?