点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

作者丨larrydong

来源丨事件相机

本文介绍ICRA 2022中关于事件相机的几篇工作,由于是关键字查找,可能有遗漏,且能力有限文章难免出现疏漏,请读者批判性阅读并指出问题。

[1] Asynchronous Optimisation for Event-based Visual Odometry

本文面向纯事件(不需要frame)和无地图(map-free),提出了在SE(3)上的单目视觉里程计VO,核心思想是采用增量式最大后验(MAP)优化。

上图清晰指出了本文的主要贡献,在SLAM框架中,针对后端的优化,采用增量式SfM和高斯过程(GP)迭代,计算出地图和轨迹。本人认为,这个图做的非常好,值得学习借鉴,非常直观的告诉了读者本文的主要工作。

围绕后端的优化问题,文章在相关工作部分总结了优化时不同的batching策略,分成了frame-based(固定时间/数量)、event-driven(逐事件)和event-driven and tracking(事件驱动和跟踪的),见下图。

核心的算法涉及了较多数学知识,感兴趣请查阅原文。但文章指出方法的缺陷是计算量较大(由于涉及了迭代等操作),在1min左右的数据上计算时间约10min。

[2] Learning Local Event-based Descriptor for Patch-based Stereo Matching

本文的主要工作是提出了两种在双目配准中event的编码和配准方法。分别是“高效表示和网络(Efficiency representation/Net)”以及“精准表示与网络(Accuracy representation/Net)”。

在表示上,高效表示采用了voxel-grid的方式进行切片,精准表示则将一段时间内的event生成6个channel的图片:两种极性的x-y,x-t,y-t图。在配准网络上,高效网络采用了全2D卷积的方式提高计算速度,精确网络则包含了Squeeze-and-Excitation层以提高特征的recalibration。

[3] Kinematic Structure Estimation of Arbitrary Articulated Rigid Objects for Event Cameras

本文解决的是rigid object的kinematic structure(KS)任务。对这个不太了解,我的理解是分析出刚体的结构并对其运动进行提取,如下图。

核心算法是叫做“增量式基于事件的运动估计”,基本原理由这两个作者在2020和21年两篇文章中提出[A1][A2]。由于不了解,本推送不做展开介绍。

[4] Fusing Event-based and RGB camera for Robust Object Detection in Adverse Conditions

提出了一种针对不同条件(主要是图像质量降低)的融合frame和event的目标检测算法。算法的核心是从RGB和event中提取特征,再经过FPN(Feature Pyramid Net)网络进行融合,以实现不同尺度上的检测。

从上图可以看出,网络结构很简单,RGB图采用了ResNet提取特征,Event通过voxel-grid的方式成图后也提取特征,之后不同尺度的特征通过FPN进行检测。

值得提一句的是,本文所提出的图像质量降低是基于[A3]给出的图像15种降质,包括噪声、模糊、天气和数字化四类。但作者实验时,将DSEC数据集的图片降质后使用,而并没有处理event对应的数据,因此我认为存在不合理之处。但作者做了event-only实验的对比,验证了融合低质图像的有效性。

另外,我最近看到了不少FPN网络在event融合中的使用,各位可以关注下。

[5] A Linear Comb Filter for Event Flicker Removal

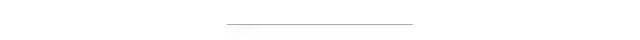

这篇文章很有趣,采用梳齿滤波器对事件的抖动进行去除,具体来说是消除了日光灯50hz频闪产生的噪声。作者是Ziwei Wang,熟悉的朋友应该知道她之前和Cedric有不少合作,基本上都是围绕滤波的。

图:日光灯频闪前后的事件热度图(下)和重建图(上)

文章的核心算法是“梳齿滤波器”,这种滤波器形似梳子,抑制特定频率整数倍的信号,而对非特定频率的信号影响不大。作者提出了前向后向反馈的梳齿滤波器,抑制50hz的周期信号。所设计的系统框图和伯德图见下。

文章很有趣,但我也指出两个问题供读者思考:1. 文章看起来需要保持相机和灯管相对静止,如果有运动怎么办,是否可以扩展?2. 从热度图上可以看出仍然没有去除全部的噪声,原因是什么,是否是由于事件的jitter或on/off的不一致造成的,是否可以优化?

[6] DEVO: Depth-Event Camera Visual Odometry in Challenging Conditions

本文提出了一种事件相机+深度相机的VO算法,基本思想是使用RGBD提供了深度,更方便地帮助event相机建立地图与位姿估计。

关于这篇文章,今年2月在arxiv上看到了作者上传的预印本,并在之前的推送中做了详细介绍,本次推送不做展开。

[7] VISTA 2.0: An Open, Data-driven Simulator for Multimodal Sensing and Policy Learning for Autonomous Vehicles

这篇文章并不算严格意义上的事件相机研究,只是做了个面向policy-learning的仿真器,涉及了event的生成。推送简单介绍:文章提出了一种基于虚拟视角的方法,对现有的实际场景数据集进行合成,合成了不同视角下的image和Lidar,并利用改进的ESIM方法生成了event数据。做无人驾驶相关的朋友如感兴趣可以进一步了解。

参考文献:

1. Asynchronous Optimisation for Event-based Visual Odometry. Liu, Daqi; Parra, Alvaro; Latif, Yasir; Chen, Bo; Chin, Tat-Jun; Reid, Ian

2. Learning Local Event-based Descriptor for Patch-based Stereo Matching. Liu, Peigen; Chen, Guang; Li, Zhijun; Tang, Huajin; Knoll, Alois

3. Kinematic Structure Estimation of Arbitrary Articulated Rigid Objects for Event Cameras. Nunes, Urbano Miguel; Demiris, Yiannis

4. Fusing Event-based and RGB camera for Robust Object Detection in Adverse Conditions. Tomy, Abhishek; Paigwar, Anshul; Mann, Khushdeep S.; Renzaglia, Alessandro; Laugier, Christian

5. A Linear Comb Filter for Event Flicker Removal. Wang, Ziwei; Yuan, Dingran; Ng, Yonhon; Mahony, Robert

6. DEVO: Depth-Event Camera Visual Odometry in Challenging Conditions. Zuo, Yi-Fan; Yang, Jiaqi; Chen, Jiaben; Wang, Xia; Wang, Yifu; Kneip, Laurent

7. VISTA 2.0: An Open, Data-driven Simulator for Multimodal Sensing and Policy Learning for Autonomous Vehicles. Amini, Alexander; Wang, Tsun-Hsuan; Gilitschenski, Igor; Schwarting, Wilko; Liu, Zhijian; Han, Song; Karaman, Sertac; Rus, Daniela

A1. U. M. Nunes and Y. Demiris, “Entropy Minimisation Framework for Event-based Vision Model Estimation,” in Computer Vision – ECCV, ser. Lecture Notes in Computer Science. Springer International Publishing, 2020, pp. 161–176

A2. U. M. Nunes and Y. Demiris, “Robust Event-based Vision Model Estimation by Dispersion Minimisation,” IEEE Transactions on Pattern Analysis and Machine Intelligence, pp. 1–1, 2021.

A3. C. Michaelis, B. Mitzkus, R. Geirhos, E. Rusak, O. Bringmann, A. S. Ecker, M. Bethge, and W. Brendel, “Benchmarking robustness in object detection: Autonomous driving when winter is coming,” ArXiv, vol. abs/1907.07484, 2019.

本文仅做学术分享,如有侵权,请联系删文。

干货下载与学习

后台回复:巴塞罗那自治大学课件,即可下载国外大学沉淀数年3D Vison精品课件

后台回复:计算机视觉书籍,即可下载3D视觉领域经典书籍pdf

后台回复:3D视觉课程,即可学习3D视觉领域精品课程

3D视觉工坊精品课程官网:3dcver.com

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

4.国内首个面向工业级实战的点云处理课程

5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿,加微信:dddvision

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~

149

149

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?