©PaperWeekly 原创 · 作者 | 姜东志

单位 | 香港中文大学MMLab

研究方向 | 多模态大语言模型

文章链接:

https://arxiv.org/pdf/2409.12959

代码链接:

https://github.com/CaraJ7/MMSearch

项目主页:

https://mmsearch.github.io/

数据集链接:

https://huggingface.co/datasets/CaraJ/MMSearch

背景

随着大型语言模型 (LLMs) 的出现,人工智能搜索引擎(如 SearchGPT)展示了人类与互联网交互的新范式。然而,当前大多数 AI 搜索引擎仅限于文本设置,忽视了用户查询的多模态性质和网站信息的文本-图像交错特性。虽然大型多模态模型 (LMMs) 最近取得了令人印象深刻的进展,但它们是否能作为 AI 搜索引擎发挥作用仍未得到充分探索。

为了填补这一研究空白,研究团队提出了 MMSEARCH-ENGINE 框架和 MMSEARCH 测试集,并进行了广泛的评估:

1. MMSEARCH-ENGINE 旨在赋予任何 LMMs 多模态搜索能力。它不仅支持包含图像的查询,还同时输入文本和视觉的网页信息,确保全面理解网页内容。该框架的工作流程包括问题重构、网页排序和答案总结三个关键步骤,充分利用了 LMMs 的多模态信息理解能力;

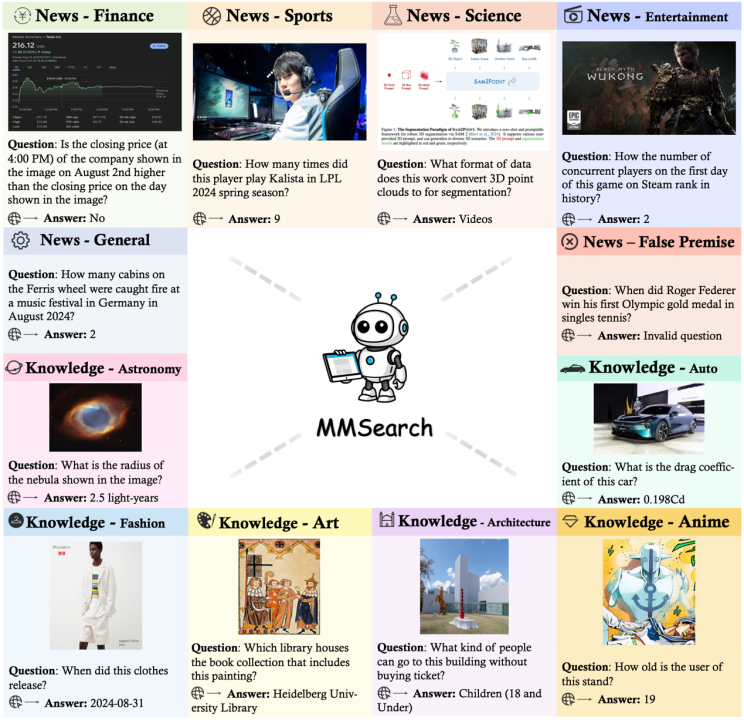

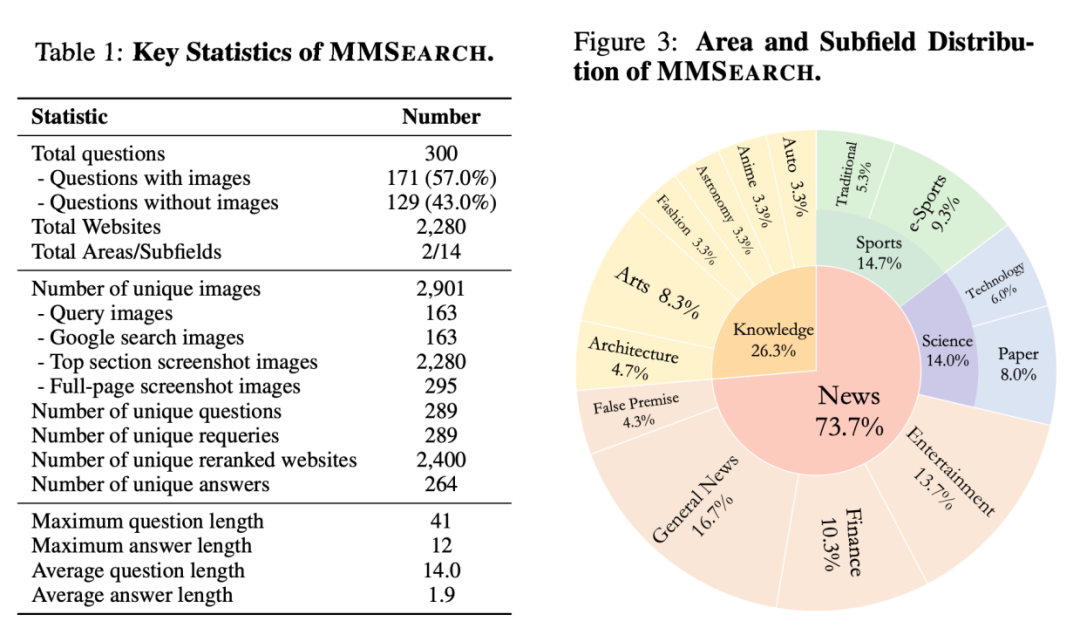

2. MMSEARCH 测试集是首个专门评估 LMMs 多模态搜索能力的综合性测试集。它包含 300 个精心收集的问题,涵盖 14 个子领域,内容分为新闻和知识两大类。新闻类别聚焦于数据收集时(2024 年 8 月)的最新信息,而知识类别则收集了需要罕见知识才能回答的查询。这种设计确保了测试内容与现有 LMMs 的训练数据不重叠,从而保证了评估的挑战性和有效性;

3. 研究团队对多个闭源和开源 LMMs 进行了广泛的实验和评估。结果显示,GPT-4o 在各项任务中表现最为出色。值得注意的是,配备了 MMSEARCH-ENGINE 的 SoTA LMMs 在端到端任务中甚至超越了知名的商业产品 Perplexity Pro。

然而,我们详尽的错误分析也揭示了当前 LMMs 在多模态搜索特定任务上的不足,特别是在问题重构和网页排序方面的能力限制了它们正确识别有用网站和提取相关答案的能力。

最后,由于多模态搜索本身是一个复杂的任务,我们进行了一个消融实验,在端到端多模态搜索任务上验证了最近由 OpenAI o1 提出的发现:相比于增大模型结构,推理时的额外计算有更好的性能。

关键设计与数据组成

2.1 MMSearch-Engine框架

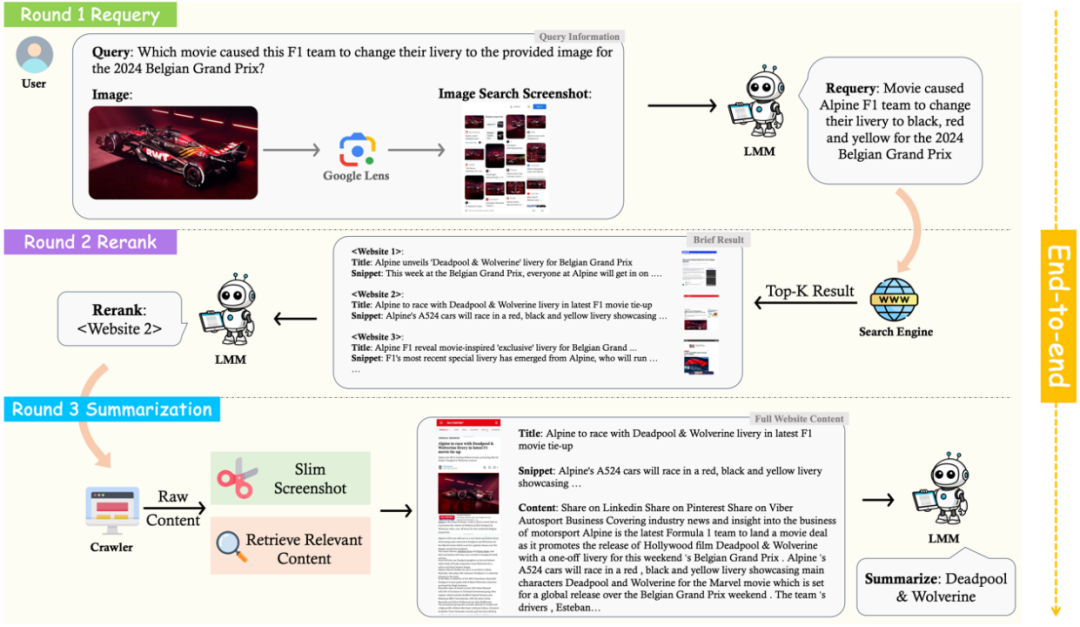

MMSEARCH-ENGINE 包含三个关键阶段:问题重构、网页排序和答案总结。

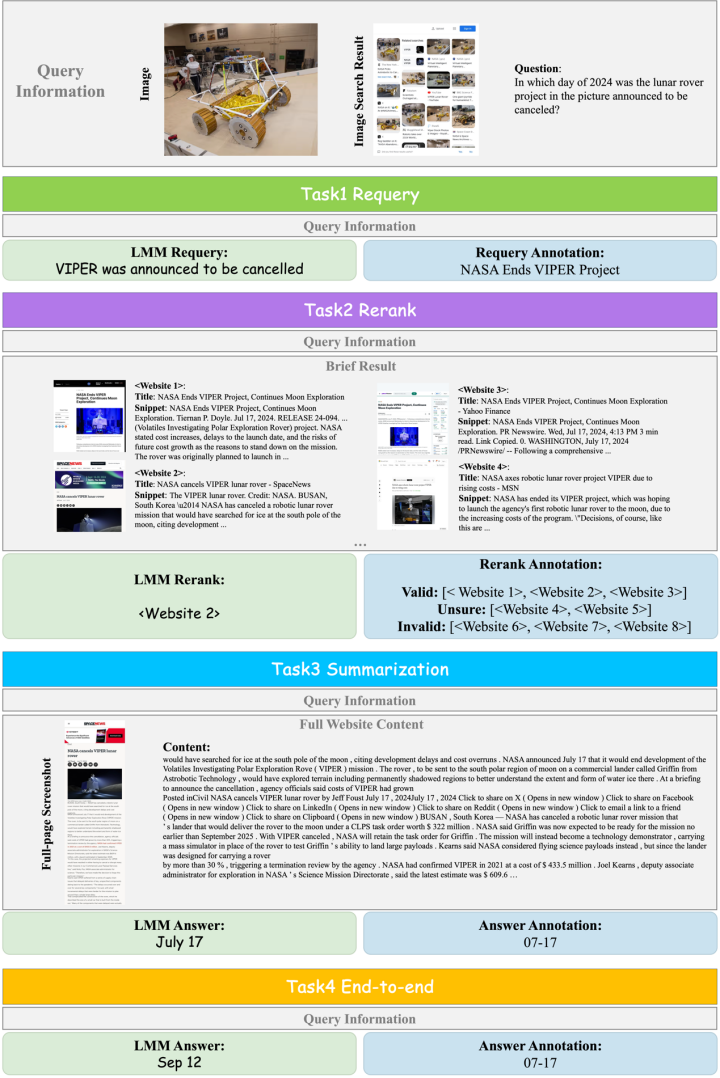

a) 在问题重构阶段,LMM 需要理解用户的原始查询(可能包含对图像的引用),并将其转化为适合传统搜索引擎的文本查询。为了增强视觉理解能力,使得 LMM 能充分捕捉到输入的图片中的关键背景信息和人物,系统还集成了 Google Lens 的图像搜索结果。

b) 在网页排序阶段,系统从搜索引擎 API(如 DuckDuckGo)获取前 K 个相关网站,然后让 LMM 从中选择最具信息量的网站。为了克服 LMM 的上下文长度限制,系统只提供每个网站的关键信息,包括标题、摘要和网页顶部的截图。

c) 在答案总结阶段,系统对选定的网站进行全面爬取,获取原始文本内容和完整页面截图。为了提高效率,系统会对截图进行裁剪,并使用文本嵌入模型从原始内容中检索出与查询最相关的部分(最多 2K 个输入 Token)。最后,LMM 基于这些信息生成答案摘要。

2.2 MMSearch测试集

MMSearch 测试集提供了一个全面的多模态搜索能力评估基准。测试集涵盖了广泛的新闻话题和专业知识领域,以模拟各种用户搜索场景。

测试集中的数据被分为两个领域——新闻和知识:

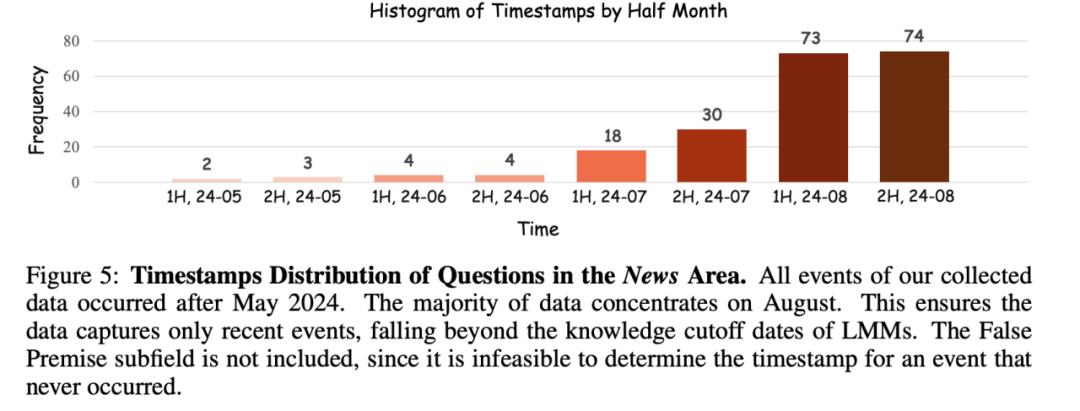

新闻领域包含从 2024 年 5 月到 2024 年 8 月的最新信息,确保与现有 LMM 的训练数据不重叠,这部分作为基准的动态部分。

知识领域则聚焦于特定领域的罕见知识,超出了现有顶级语言模型(如 GPT-4 或 Claude 3.5 Sonnet)的能力范围,构成基准的静态部分。我们的测试集总共收集了 300 个查询,分布在 14 个子领域中。

我们的数据收集过程模拟了实际搜索流程。标注者首先提出问题并提供答案,然后给出重构的问题,这个重构的问题用来提交给搜索引擎的 API。标注者对搜索结果进行分类,分为有效、不确定和无效三类,并确保至少有一个有效网站。

接着,我们从有效网站中随机选择一个获取完整内容,包括全屏的截图和全部的内容。为了保证问题可以被正确回答,另一名标注者需要验证问题的可回答性,从而确保数据质量。

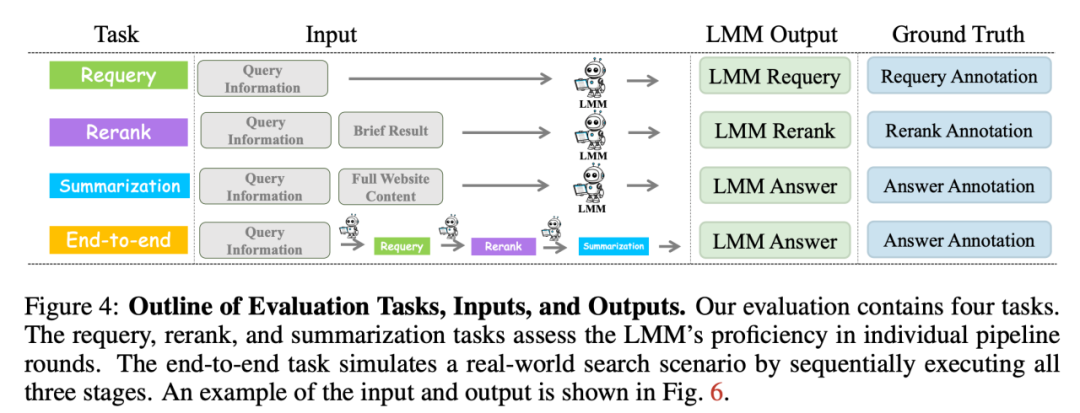

2.3 评估标准

评估任务包括四个部分:问题重构、网页排序、答案总结和端到端任务。前三个任务评估 LMM 在搜索框架中各个阶段的能力,而端到端任务则模拟真实世界的完整搜索场景,依次执行所有三个阶段。

这个基准测试的设计旨在全面评估 LMM 在多模态搜索中的各项能力,从查询生成到结果分析的整个过程都被纳入考量。通过这种方法,可以深入了解 LMM 在处理复杂、多样化搜索任务时的表现,为进一步改进和优化多模态搜索技术提供有价值的见解。

2.4 数据集更新

为确保评估的公平性和时效性,MMSEARCH 的新闻领域问题时间跨度从 2024 年 5 月 1 日到 8 月 31 日,确保所有测试数据都超出了现有 LMM 的知识截止日期。随着新模型的发布,数据集会进行动态更新,以维持评估的有效性。

实验与结论

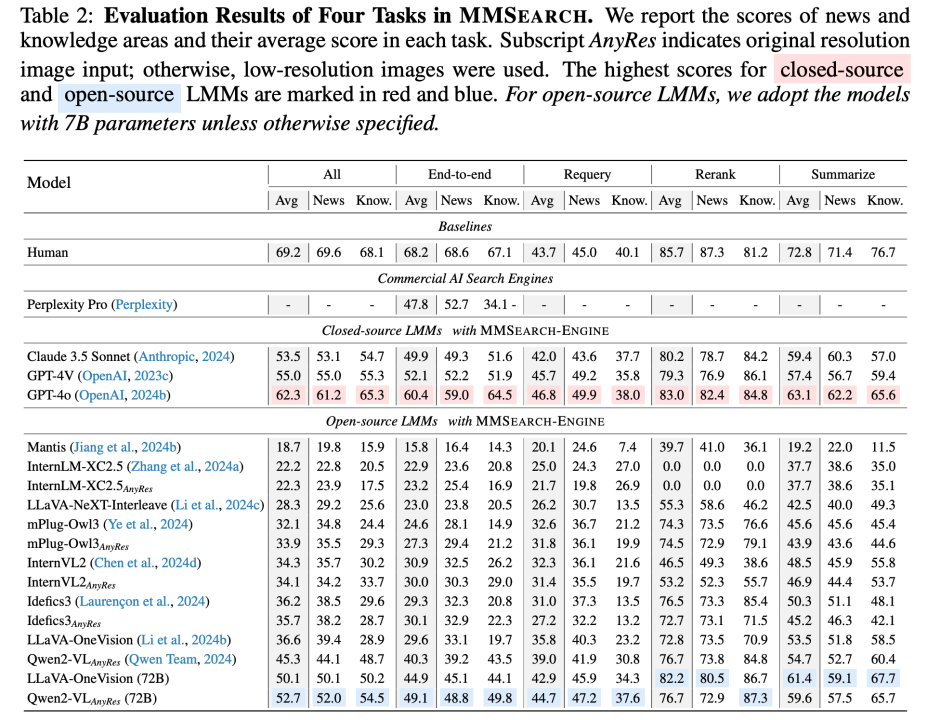

我们在 MMSearch benchmark 上测评了 11 个现有的 LMM,并且对于开源模型,测试了低分辨率以及高分辨率的输入,如下表所示。其中 AnyRes 表示使用模型提供的高分辨率技术,而 LowRes 则表示将图片 resize 到和模型的 vision encoder 规定的大小。

基于测评,我们得到了如下的发现与结论:

1. 高分辨率的输入并没有为大部分的 LMM 带来明显的性能增益。这一发现与常见的测试集的测试结果是不一致的,说明对于内容的感知并不是当前 LMM 做不好多模态搜索任务的瓶颈,而是由于在某些其他与搜索相关的能力上有明显的欠缺,比如问题重构与抽取有用的信息。

2. LMM 在问题重构与网页排序能力上有明显的欠缺。LMM 在端到端任务与答案总结任务的性能上有显著的差异,这其实揭示了它们在问题重构和网页排序能力上的普遍不足。根据结果发现,所有模型的摘要任务得分都明显高于端到端任务得分,其中开源模型的差距尤为明显。这种差异主要源于端到端任务对模型前两轮处理能力的依赖。

3. 闭源与开源 LMM 模型仍有显著的性能差距。研究表明,闭源 LMM 在各项指标上普遍优于开源模型。其中,GPT-4o 以 62.3% 的最高总分展现出卓越的零样本多模态搜索能力。虽然 Qwen2-VL-72B 在开源模型中表现最佳,但仍落后 GPT-4o 9.6 个百分点。在最具挑战性的端到端任务中,这一差距进一步扩大到11.3%,对于 7B 级开源 LMM,差距甚至达到 20.1%。

4. MMSearch-Engine 在端到端任务中超越了商业 AI 搜索引擎 Perplexity Pro。尽管 Perplexity Pro 使用了如 GPT-4 和 Claude 3.5 Sonnet 等先进的大型语言模型,但在相同模型的配置下,其性能仍然明显落后于 MMSEARCH-ENGINE。

更为显著的是,MMSEARCH-ENGINE 甚至在使用开源的 Qwen2-VL-72B 模型时也能超越 Perplexity Pro。这一发现突显了 MMSEARCH-ENGINE 作为开源多模态 AI 搜索引擎方案的潜力。研究者发现 Perplexity 表现不佳的原因可能在于其仅使用了基础的图像搜索算法,导致无法准确识别图像中的关键对象并检索相关信息。

最后,利用我们的端到端的多模态搜索的任务,我们进行了初步的扩展测试时的计算和扩大模型规模的比较的研究。实验使用了 LLaVA-OneVision-7B 模型来测试扩展测试时计算的效果,并与扩展模型规模的 LLaVA-OneVision-72B 进行对比。研究采用了类似于"best-of-N"的多模态搜索策略,其中 N 设为 25。具体步骤请见原论文。

结果显示,通过扩展测试时计算,LLaVA-OneVision-7B 的端到端任务得分从 29.6% 显著提升至 55.2%,超过了 LLaVA-OneVision-72B 的 44.9% 和 GPT-4V 的 52.1%。这一发现凸显了扩展测试时计算的巨大潜力,验证了 OpenAI o1 引入的这一技术的有效性。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

·

2100

2100

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?