之前写过一片关于Q-Learning的博文,现在看来有些不是很到位,在看完《强化学习导论》中关于这部分的介绍后,想再补充下。

前言

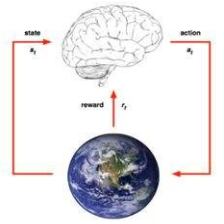

一、首先我们知道TD方法和蒙特卡罗方法的区别时,一个需要所有时间步走完才更新,完全取决于样本;一个可以走完一步就更新,融合样本法和动态规划。

二、蒙特卡洛方法中,有同策略和以策略的思想。

同策略中:

在试探性出发的方法中,策略为argmax;

在非试探性出发的方法中,策略为软性策略,采样也是根据这软性策略。

异策略中:

在非试探性出发的方法中,我们学到的策略为最优策略,采样是根据这一策略的软性策略。

TD

一、

TD中的同策略算法是sarsa。之所以是同策略,是因为他学到的是软性策略,采样也是根据这一软性策略,同时,我们知道,在TD算法中,我们是根据下一步的状态更新当前状态,类似动态规划的自举思想。因此我们还需要知道到达s’后的动作,a’。而这个动作也是从软性策略中采样的。

正是由于,这个动作是实实在在的动作,因此这个动作a’在下一步s’选取动作时,就是从这一步开始的。

这带来的好处就是,算法可以根据策略(软性)获得比较稳妥的收益。

二、

Q-Learnig是TD里的异策略算法。之所以称之为一策略。

这里我们主要用到贝尔曼最优方程的思想。也就是说我们在这里每一步迭代,带入的最优方程,也就是说,我们通过Q*(s’)估计Q*(s,)。

首先我们同样学习软性策略,采样总用到这个软性策略。但是更新的时候,我们选择到达的s’的时候的可以让Q取最大的a。因为这里用到了之前的那种类似不需要实实在在走一步就可以更新的动态规划的方法,因此,在这里我们不假定下一步s’采取的动作。

我认为原因有二:

第一,我们需要平衡收益和探索;

第二,s’的最优动作只是用来更新Q(s)的,并没有实际“走出”。

也是因为用s’处取最大的a’的Q作为更新s处Q的最优近似,所以样本少的时候方差会很大。

-------------后记-----------------

1、后来反思,两者学到的都是贪心策略会比较方便。这样就不用最后再取最大了。

2、同时补充Q-Learning的一个总结,Q-Learning到达s’时采取的是取最大,实际上如果策略学到的都是贪心的,那这里就直接根据确定性策略选择就可以。即采样用软性,更新用贪心。

692

692

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?