目录

- 1、前言

- 2、相关方案推荐

- 3、详细设计方案

- 设计原理框图

- 测试用PC端电脑

- SFP光口转RJ45电口

- AXI 1G/2.5G Ethernet Subsystem 简介

- AXI 1G/2.5G Ethernet Subsystem 配置

- 多个 AXI 1G/2.5G Ethernet Subsystem 主从级联使用

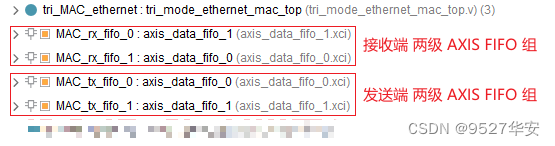

- AXI4-Stream Data FIFO 组

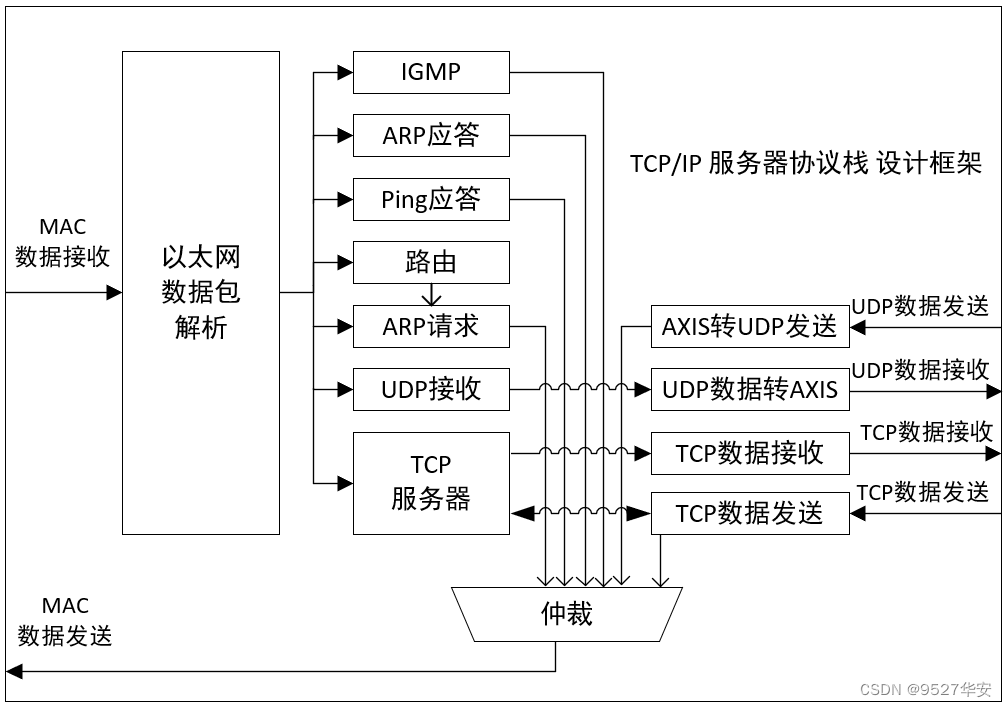

- TCP/IP协议栈服务器-->简介

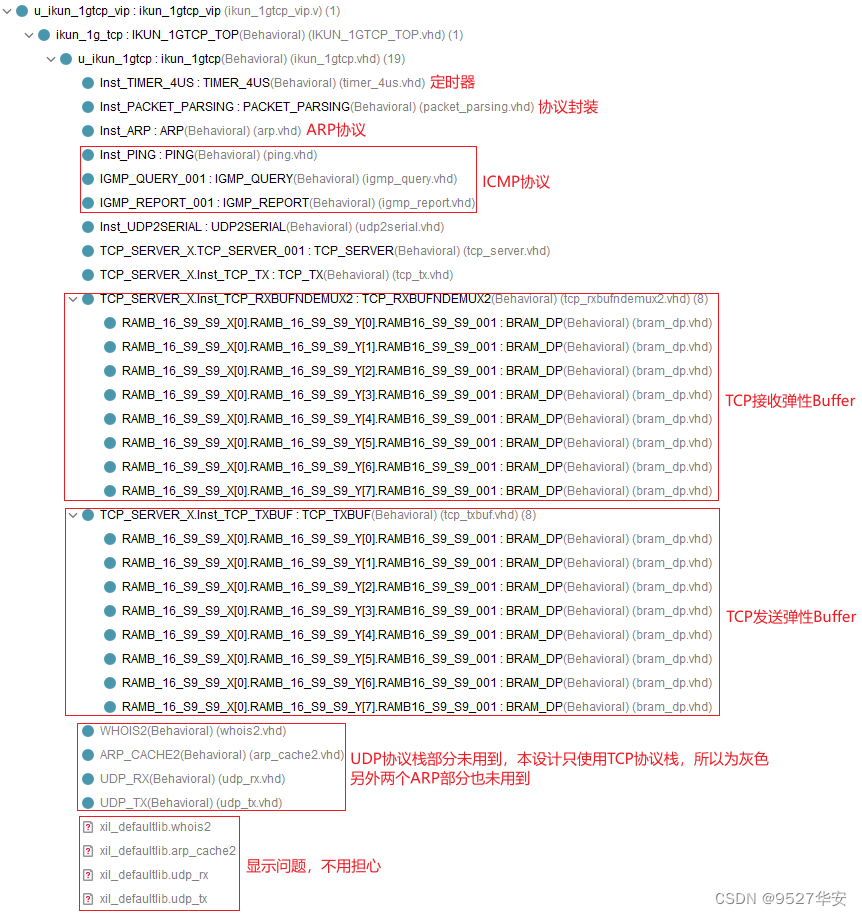

- TCP/IP协议栈服务器-->源码架构

- TCP/IP协议栈服务器-->性能简介

- TCP/IP协议栈服务器-->接口描述

- TCP/IP协议栈客户端-->简介

- TCP/IP协议栈客户端-->源码架构

- TCP/IP协议栈客户端-->性能简介

- TCP/IP协议栈客户端-->接口描述

- TCP用户数据测试模块

- IP地址修改

- 工程源码架构

- 4、vivado工程1详解:Artix7版本,单路TCP服务器版本

- 5、vivado工程2详解:Artix7版本,单路TCP客户端版本

- 6、vivado工程3详解:Artix7版本,双路TCP客户端+客户端版本

- 7、vivado工程4详解:Kintex7版本,单路TCP服务器版本

- 8、vivado工程5详解:Kintex7版本,单路TCP客户端版本

- 9、vivado工程6详解:Kintex7版本,双路TCP客户端+客户端版本

- 10、vivado工程7详解:Zynq7100版本,单路TCP服务器版本

- 11、vivado工程8详解:Zynq7100版本,单路TCP客户端版本

- 12、vivado工程9详解:Zynq7100版本,双路TCP客户端+客户端版本

- 13、vivado工程10详解:Virtx7版本,单路TCP服务器版本

- 14、vivado工程11详解:Virtx7版本,单路TCP客户端版本

- 15、vivado工程12详解:Virtx7版本,双路TCP客户端+客户端版本

- 16、vivado工程13详解:KU060版本,单路TCP服务器版本

- 17、vivado工程14详解:KU060版本,单路TCP客户端版本

- 18、vivado工程15详解:KU060版本,双路TCP客户端+客户端版本

- 19、vivado工程16详解:KU5P版本,单路TCP服务器版本

- 20、vivado工程17详解:KU5P版本,单路TCP客户端版本

- 21、vivado工程18详解:KU5P版本,双路TCP客户端+客户端版本

- 22、工程移植说明

- 23、上板调试验证并演示

- 24、福利:工程代码的获取

FPGA无网络芯片实现TCP/IP协议栈,基于AXI 1G/2.5G Ethernet Subsystem方案,提供18套工程源码和技术支持

1、前言

没玩过TCP网络通信都不好意思说自己玩儿过FPGA,这是CSDN某大佬说过的一句话,鄙人深信不疑。。。目前网上fpga实现udp协议的源码满天飞,我这里也有不少,但用FPGA纯源码实现TCP的项目却很少,能上板调试跑通的项目更是少之又少,甚至可以说是凤毛菱角,但很不巧,本人这儿就有一个;一般而言,用FPGA实现TCP并不是一个经济的方案,但对于芯片原型验证、航天可靠通信、水下通信等一些数据传输可靠性极高的领域而言,FPGA实现TCP方案依然占有一席之地;FPGA做千兆网一般会使用网络芯片,比如RTL8211、B50610等,但也可以使用FPGA内部逻辑资源实现无网络芯片方案,这也正是本博客描述的设计方案;

工程概述

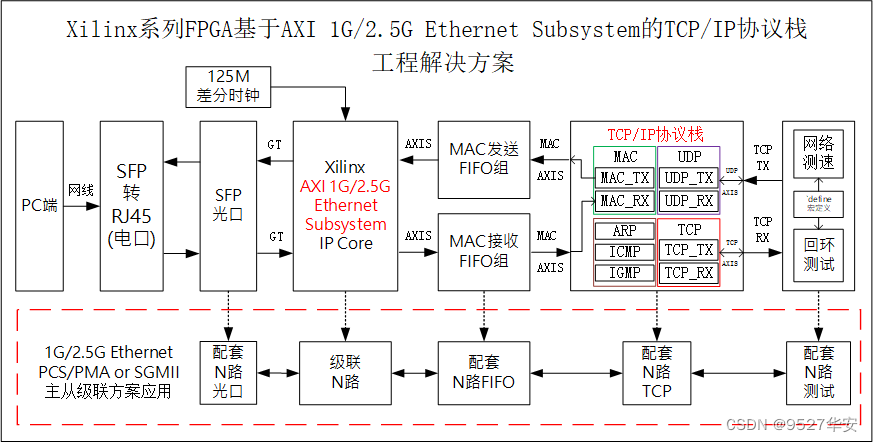

本设采用纯VHDL实现了千兆网TCP/IP协议栈,包括TCP服务器和客户端两个版本,没有用到任何一个IP核;并在Xilinx系列FPGA上做了部署并验证,并且无需诸如RTL8211、B50610等网络芯片,而是使用Xilinx官方的AXI 1G/2.5G Ethernet Subsystem方案取代了网络芯片,属于FPGA开发领域的高端项目;整个工程处理流程如下:

TCP/IP协议栈接收流程

PC端网络调试助手发送以太网数据包,或者发起ping操作,数据通过网线发送到FPGA开发板;一个SFP转RJ45电口插在FPGA开发板板载的SFP光口上,接收网线数据;调用Xilinx官方的AXI 1G/2.5G Ethernet Subsystem IP核实现以太网物理层和MAC层,输出AXI4-Stream接口的MAC数据;再调用2个AXI4-Stream Data FIFO做MAC数据跨时钟域处理和数据缓冲处理后依然以AXI4-Stream数据流输出给TCP/IP 协议栈;TCP/IP 协议栈对数据的MAC数据做以太网数据帧解析、IP报文解析等操作,去掉以太网帧头、协议层报文帧头等信息,提取出有效数据段信息和IP、MAC等地址信息,并以AXI4-Stream数据流形式输出有效数据,至此,TCP/IP协议栈接收流程完毕;

TCP/IP协议栈发送流程

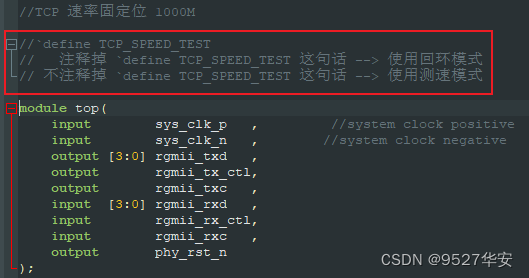

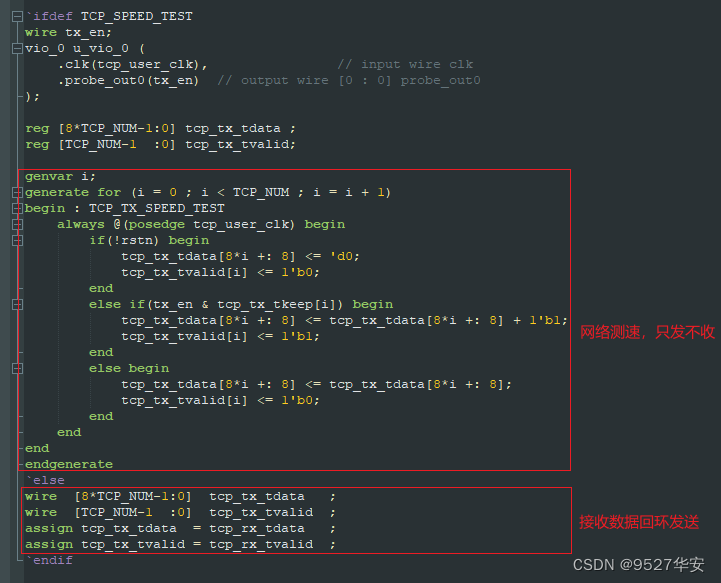

用户数据测试模块为数据发起者,可以是测速模式下的单向的给PC端发送数据,也可以是数据回环模式下的将接收数据回环发送出去,两种模式通过define宏定义选择;用户输出发送时序为AXI4-Stream数据流;用户发送数据首先进入TCP/IP协议栈,并做协议层报文封装、以太网帧格式封装等操作,然后以AXI4-Stream数据流输出;再调用2个AXI4-Stream Data FIFO做TCP数据跨时钟域处理和数据缓冲处理后依然以AXI4-Stream数据流输出给MAC层;然后调用Xilinx官方的AXI 1G/2.5G Ethernet Subsystem IP核实现MAC数据转换和以太网物理层,AXI 1G/2.5G Ethernet Subsystem可替代传统的PHY芯片,比如RTL8211、B50610等,可简化硬件电路,节省板材物料;以太网数据通过板载的SFP光口输出,经过一个SFP转RJ45电口后由网线发送给PC电脑端;至此,TCP/IP协议栈发送流程完毕;

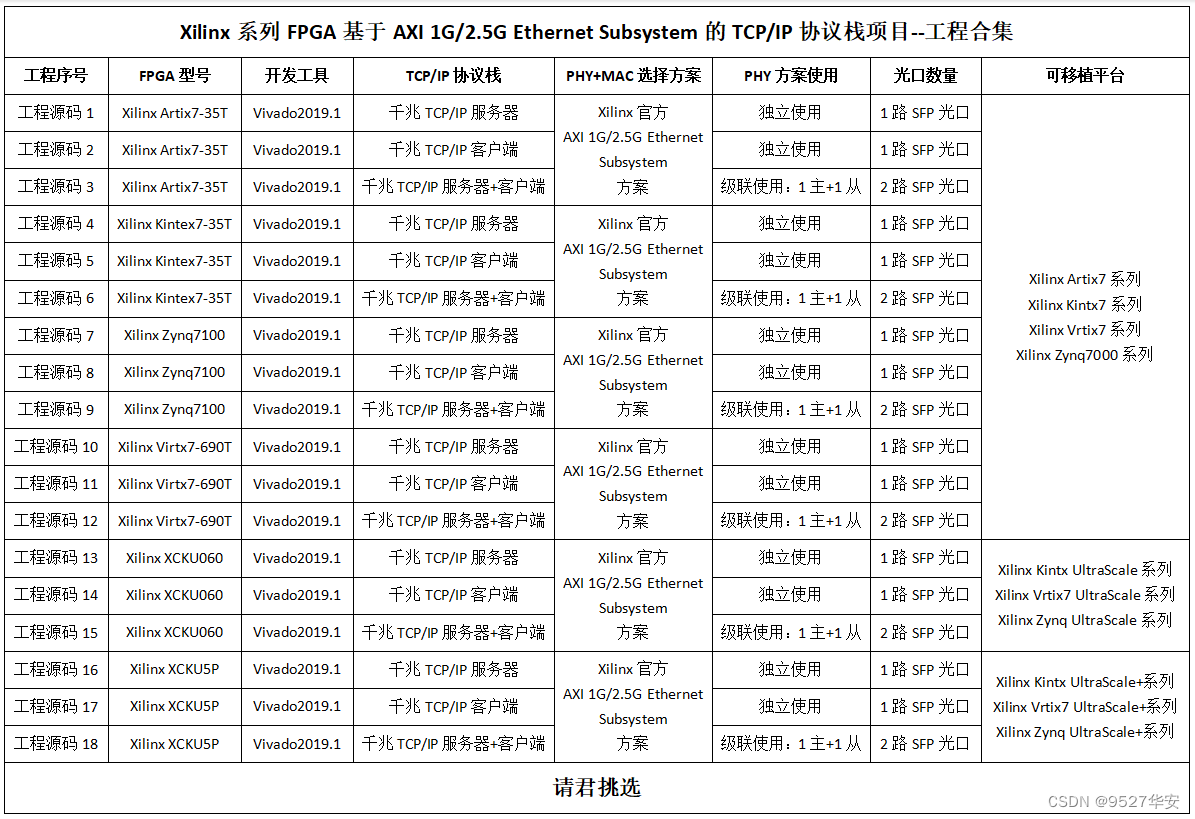

针对目前市面上主流的FPGA,共移植了18套工程源码,详情如下:

现对上述18套工程源码解释如下:

工程源码1

开发板FPGA型号为Xilinx–>Artix7–>xc7a35tfgg484-2;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTP高速接口资源;挂载1个千兆网TCP/IP协议栈服务器,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码2

开发板FPGA型号为Xilinx–>Artix7–>xc7a35tfgg484-2;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTP高速接口资源;挂载1个千兆网TCP/IP协议栈客户端,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码3

开发板FPGA型号为Xilinx–>Artix7–>xc7a35tfgg484-2;使用2个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTP高速接口资源;挂载1个千兆网TCP/IP协议栈服务器(即SFP光口1运行TCP/IP协议栈服务器)+1个千兆网TCP/IP协议栈客户端(即SFP光口2运行TCP/IP协议栈客户端),输入输出接口为2路SFP光口,功能是1G TCP网络通信;工程应用是FPGA的1G TCP多光口网卡或交换机;

工程源码4

开发板FPGA型号为Xilinx–>Kintex7–>xc7k325tffg900-2;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTX高速接口资源;挂载1个千兆网TCP/IP协议栈服务器,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码5

开发板FPGA型号为Xilinx–>Kintex7–>xc7k325tffg900-2;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTX高速接口资源;挂载1个千兆网TCP/IP协议栈客户端,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码6

开发板FPGA型号为Xilinx–>Kintex7–>xc7k325tffg900-2;使用2个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTX高速接口资源;挂载1个千兆网TCP/IP协议栈服务器(即SFP光口1运行TCP/IP协议栈服务器)+1个千兆网TCP/IP协议栈客户端(即SFP光口2运行TCP/IP协议栈客户端),输入输出接口为2路SFP光口,功能是1G TCP网络通信;工程应用是FPGA的1G TCP多光口网卡或交换机;

工程源码7

开发板FPGA型号为Xilinx–Zynq7100–xc7z100ffg900-2;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTX高速接口资源;挂载1个千兆网TCP/IP协议栈服务器,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码8

开发板FPGA型号为Xilinx–Zynq7100–xc7z100ffg900-2;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTX高速接口资源;挂载1个千兆网TCP/IP协议栈客户端,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码9

开发板FPGA型号为Xilinx–Zynq7100–xc7z100ffg900-2;使用2个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTX高速接口资源;挂载1个千兆网TCP/IP协议栈服务器(即SFP光口1运行TCP/IP协议栈服务器)+1个千兆网TCP/IP协议栈客户端(即SFP光口2运行TCP/IP协议栈客户端),输入输出接口为2路SFP光口,功能是1G TCP网络通信;工程应用是FPGA的1G TCP多光口网卡或交换机;

工程源码10

开发板FPGA型号为Xilinx–Virtx7–xc7vx690tffg1761-3;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTH高速接口资源;挂载1个千兆网TCP/IP协议栈服务器,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码11

开发板FPGA型号为Xilinx–Virtx7–xc7vx690tffg1761-3;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTH高速接口资源;挂载1个千兆网TCP/IP协议栈客户端,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码12

开发板FPGA型号为Xilinx–Virtx7–xc7vx690tffg1761-3;使用2个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTH高速接口资源;挂载1个千兆网TCP/IP协议栈服务器(即SFP光口1运行TCP/IP协议栈服务器)+1个千兆网TCP/IP协议栈客户端(即SFP光口2运行TCP/IP协议栈客户端),输入输出接口为2路SFP光口,功能是1G TCP网络通信;工程应用是FPGA的1G TCP多光口网卡或交换机;

工程源码13

开发板FPGA型号为Xilinx-- Kintex UltraScale–xcku060-ffva1156-2-i;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTH高速接口资源;挂载1个千兆网TCP/IP协议栈服务器,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码14

开发板FPGA型号为Xilinx-- Kintex UltraScale–xcku060-ffva1156-2-i;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTH高速接口资源;挂载1个千兆网TCP/IP协议栈客户端,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码15

开发板FPGA型号为Xilinx-- Kintex UltraScale–xcku060-ffva1156-2-i;使用2个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTH高速接口资源;挂载1个千兆网TCP/IP协议栈服务器(即SFP光口1运行TCP/IP协议栈服务器)+1个千兆网TCP/IP协议栈客户端(即SFP光口2运行TCP/IP协议栈客户端),输入输出接口为2路SFP光口,功能是1G TCP网络通信;工程应用是FPGA的1G TCP多光口网卡或交换机;

工程源码16

开发板FPGA型号为Xilinx-- Kintex UltraScale±-xcku5p-ffvb676-1-i;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTY高速接口资源;挂载1个千兆网TCP/IP协议栈服务器,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码17

开发板FPGA型号为Xilinx-- Kintex UltraScale±-xcku5p-ffvb676-1-i;使用1个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTY高速接口资源;挂载1个千兆网TCP/IP协议栈客户端,输入输出接口为1路SFP光口,功能是1G TCP服务器网络通信;工程应用是FPGA的1G TCP/IP网卡;

工程源码18

开发板FPGA型号为Xilinx-- Kintex UltraScale±-xcku5p-ffvb676-1-i;使用2个AXI 1G/2.5G Ethernet Subsystem IP核实现PHY物理层和MAC层,该IP使用GTY高速接口资源;挂载1个千兆网TCP/IP协议栈服务器(即SFP光口1运行TCP/IP协议栈服务器)+1个千兆网TCP/IP协议栈客户端(即SFP光口2运行TCP/IP协议栈客户端),输入输出接口为2路SFP光口,功能是1G TCP网络通信;工程应用是FPGA的1G TCP多光口网卡或交换机;

本文详细描述了FPGA基于AXI 1G/2.5G Ethernet Subsystem实现TCP/IP协议栈的设计方案,经过反复大量测试稳定可靠,可在项目中直接移植使用,工程代码可综合编译上板调试,可直接项目移植,适用于在校学生、研究生项目开发,也适用于在职工程师做项目开发,可应用于医疗、军工等行业的数字通信领域;

提供完整的、跑通的工程源码和技术支持;

工程源码和技术支持的获取方式放在了文章末尾,请耐心看到最后;

免责声明

本工程及其源码即有自己写的一部分,也有网络公开渠道获取的一部分(包括CSDN、Xilinx官网、Altera官网等等),若大佬们觉得有所冒犯,请私信批评教育;基于此,本工程及其源码仅限于读者或粉丝个人学习和研究,禁止用于商业用途,若由于读者或粉丝自身原因用于商业用途所导致的法律问题,与本博客及博主无关,请谨慎使用。。。

2、相关方案推荐

我这里已有的以太网方案

目前我这里有大量UDP协议的工程源码,包括UDP数据回环,视频传输,AD采集传输等,也有TCP协议的工程,对网络通信有需求的兄弟可以去看看:

直接点击前往

基于1G/2.5G Ethernet PCS/PMA or SGMII的千兆网TCP方案

基于1G/2.5G Ethernet PCS/PMA or SGMII的千兆网TCP方案一样无需网络芯片,之前写了一篇博客专门介绍,感兴趣的朋友可以去看看:

直接点击前往

网络芯片版本–>千兆网 TCP–>服务器 方案

TCP分为服务器和客户端,两者代码是不一样的,看具体需求,TCP服务器版本依然是16套工程源码,采用我网络芯片实现PHY,之前写了一篇博客专门介绍,感兴趣的朋友可以去看看:

直接点击前往

网络芯片版本–>千兆网 TCP–>客户端 方案

TCP分为服务器和客户端,两者代码是不一样的,看具体需求,TCP客户端版本依然是16套工程源码,采用我网络芯片实现PHY,之前写了一篇博客专门介绍,感兴趣的朋友可以去看看:

直接点击前往

10G 万兆网 TCP–>服务器+客户端 方案

我这里也有10G 万兆网 TCP 方案,该方案有服务器和客户端两套代码,在Xilinx KU和KUP等平台测试通过并很稳定,对10G 万兆网 TCP 方案感兴趣的朋友可以去看看:

直接点击前往

1G/2.5G Ethernet PCS/PMA or SGMII 方案

1G/2.5G Ethernet PCS/PMA or SGMII 方案解决的问题是替代网络芯片,之前写了一篇博客专门介绍,感兴趣的朋友可以去看看:

直接点击前往

AXI 1G/2.5G Ethernet Subsystem 方案

AXI 1G/2.5G Ethernet Subsystem 方案解决的问题也是替代网络芯片,之前写了一篇博客专门介绍,感兴趣的朋友可以去看看:

直接点击前往

3、详细设计方案

设计原理框图

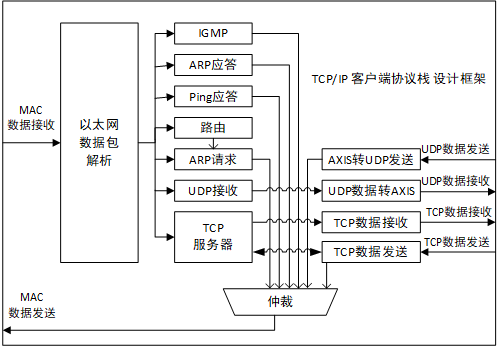

设计原理框图如下:

测试用PC端电脑

测试用PC端电脑要求如下:

有千兆网口及其驱动;

安装网络调试助手软件,软件已提供在资料包中;

普通的台式电脑或笔记本电脑均可;

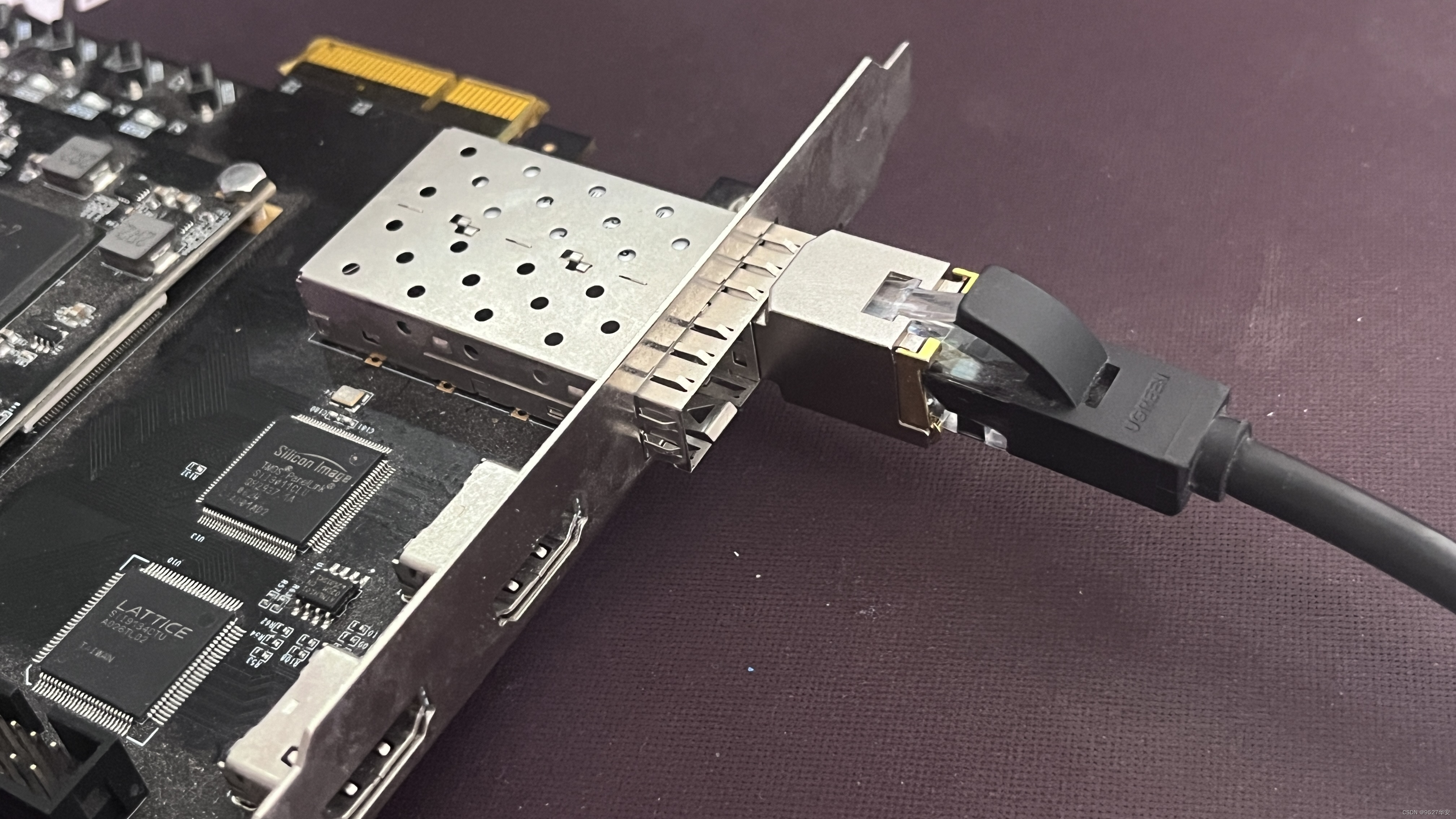

SFP光口转RJ45电口

需要准备满足千兆传输要求的SFP光口转RJ45电口,某宝二三十块钱很便宜,大概长这样:

AXI 1G/2.5G Ethernet Subsystem 简介

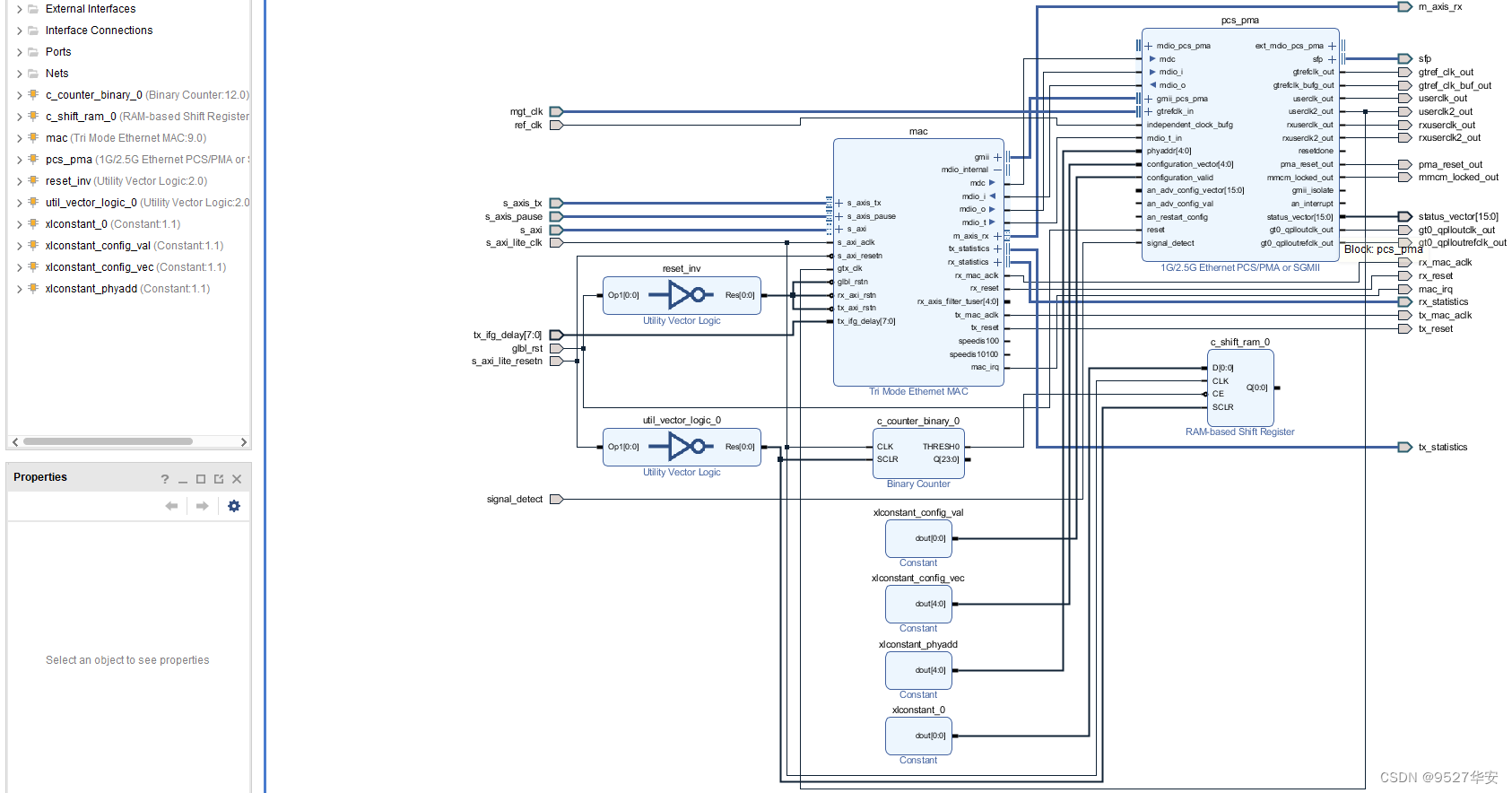

AXI 1G/2.5G Ethernet Subsystem的权威官方手册为《pg138-axi-ethernet》,请自行下载阅读,该IP是Xilinx官方将1G/2.5G Ethernet PCS/PMA or SGMII和Tri Mode Ethernet MAC封装在一起组成的全新IP,目的是简化FPGA实现以太网物理层的设计难度,直接调用这一个IP即可使用,该IP展开后如下:

接收端:

数据首先经过1G/2.5G Ethernet PCS/PMA or SGMII解串,将串行数据解为并行数据;然后经过弹性Buffer做数据缓冲处理,主要是为了去频偏,使板与板之间的数据稳定,然后进行8b/10b解码,恢复正常数据;然后经过PCS接收同步器,对数据进行跨时钟处理,同步到GMII时序下然后输出给Tri Mode Ethernet MAC进行数据合适转换,最后以AXI4-Stream输出;

发送端:

发送端则简单得多,用户侧UDP MAC数据首先给到Tri Mode Ethernet MAC进行数据合适转换,以GMII数据输出给1G/2.5G Ethernet PCS/PMA or SGMII,后者进行以太网物理层处理,以差分信号输出;

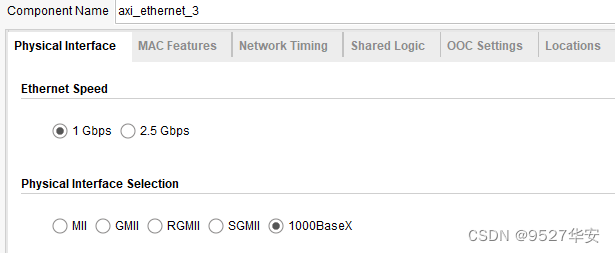

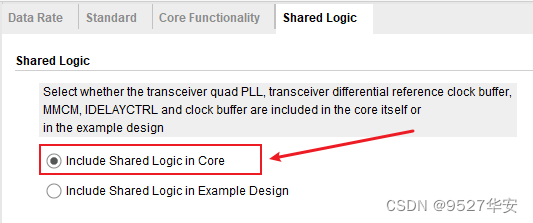

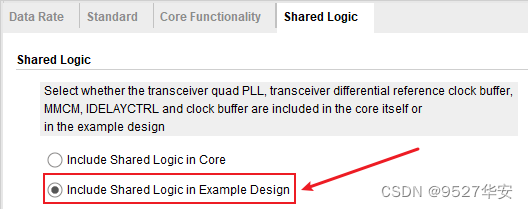

AXI 1G/2.5G Ethernet Subsystem 配置

AXI 1G/2.5G Ethernet Subsystem配置为1G,如下:

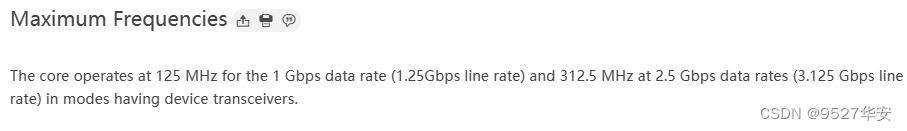

AXI 1G/2.5G Ethernet Subsystem可运行于1G和2.5G线速率,对GT时钟有严格研究,按照官方数据手册,运行1G线速率时,GT差分时钟必须为125M,运行2.5G线速率时,GT差分时钟必须为312.5M,如下:

多个 AXI 1G/2.5G Ethernet Subsystem 主从级联使用

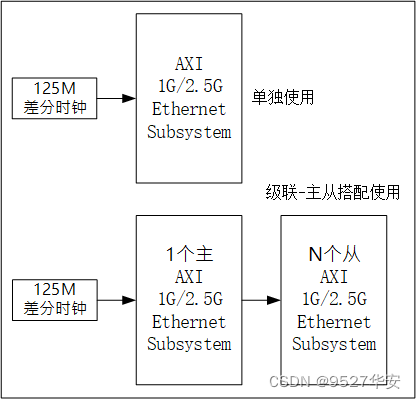

多个AXI 1G/2.5G Ethernet Subsystem 的主从搭配使用的应用场景是FPGA开发板充当多光口的网卡使用,即一个FPGA挂载多个光口,每一个光口相当于一个独立的网卡,有独立的IP地址和MAC地址,类似于交换机;主从搭配使用框架如下:

AXI 1G/2.5G Ethernet Subsystem可单独使用,当单独使用时,一个AXI 1G/2.5G Ethernet Subsystem单独占用一个GT高速接口资源,单独占用一对差分时钟资源;此时的IP配置如下:

AXI 1G/2.5G Ethernet Subsystem也可多个级联主从搭配使用,主从搭配使用时,一个AXI 1G/2.5G Ethernet Subsystem当做主IP,占用一个GT高速接口资源,单独占用一对差分时钟资源;其他AXI 1G/2.5G Ethernet Subsystem当做从IP,占用一个GT高速接口资源,但不占用差分时钟资源,而是使用主IP提供的参考时钟;此时的从IP配置如下:

AXI4-Stream Data FIFO 组

调用AXI4-Stream Data FIFO 组实现MAC数据与TCP/IP协议栈之间的数据桥接,其在工程中的代码架构如下:

以接收端为例:

第一级FIFO为异步时钟FIFO,实现MAC数据从Tri Mode Ethernet MAC到TCP/IP协议栈的跨时钟域处理;

第一级FIFO为同步时钟FIFO,实现MAC数据到TCP/IP协议栈的数据缓冲处理;

以发送端为例:

第一级FIFO为异步时钟FIFO,实现MAC数据从TCP/IP协议栈到Tri Mode Ethernet MAC的跨时钟域处理;

第一级FIFO为同步时钟FIFO,实现MAC数据到Tri Mode Ethernet MAC的数据缓冲处理;

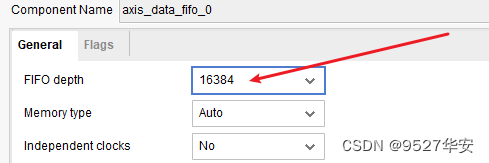

注意!!!!

注意!!!!

当工程配置为网络测速模式时,请将AXI4-Stream Data FIFO组的深度设置大一些,如下:

TCP/IP协议栈服务器–>简介

本TCP/IP协议栈为纯VHDL实现的千兆网速率服务器版本,可实现TCP协议网络通信,针对不同需求,提供两个版本的模块,一种是TCP/IP 协议栈源码,即完全看得到并可修改的纯源码;另一种是TCP/IP 协议栈网表,可以正常调用、例化并使用,但看不到TCP/IP 协议栈源码也不能修改;TCP/IP协议栈基本设计框架如下:

其中的UDP我们没有用到,只用到了TCP;

TCP/IP协议栈服务器–>源码架构

TCP/IP 协议栈源码架构如下:

TCP/IP协议栈服务器–>性能简介

此TCP/IP协议栈是TCP服务器,不是客户端;即FPGA是TCP服务器,远程节点(比如 PC 电脑)是客户端;

常规性能

1:纯VHDL实现,没有用到任何一个IP核;

2:移植性天花板,该协议栈可在Xilinx、Altera、Lattice、国产FPGA等各大FPGA型号之间任意移植,因为是没有任何IP和源语的纯VHDL代码实现;但例如Tri Mode Ethernet MAC这样的PHY侧IP核目前用的Xilinx的;

3:功能齐全,包含了服务器和客户端,客户端目前还在开发中,暂不提供;TCP/IP协议栈本身包含了动态ARP、NDP、PING、IGMP (for multicast UDP)等功能模块;

4:代码符合标准的IEEE 802.3协议,支持IPv4和IPv6;

5:对外接PHY的数据格式要求:RGMII;

6:时序收敛很到位,考虑到TCP协议的复杂性和时序的高要求,所以没有采用时序收敛不强的verilog,而是VHDL,虽然阅读性可能会低一些,但用户只需要知道用户接口即可,并不需要去看内部的复杂代码;

7:动态ARP功能;

8:带ping功能;

9:支持多播;

支持多节点

支持节点数是TCP里面最重要的性能指标之一,这里需要重点讲述:

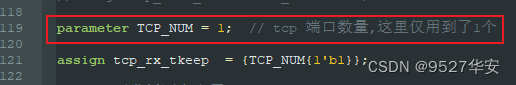

TCP节点数最大支持255个,通过parameter TCP_NUM参数设置,但前提是你的FPGA资源能满足;TCP_NUM参数可以在代码中自由修改,含义和用法,在代码里有详细的注释,为了防止不同编译器下中文注释出现乱码,注释均由英文书写,英语较差的兄弟可以直接某度翻译,位置如下:

本例程只用到了1个节点;

此外,使用TCP/IP 协议栈网表的工程不支持多节点,没有此参数配置;

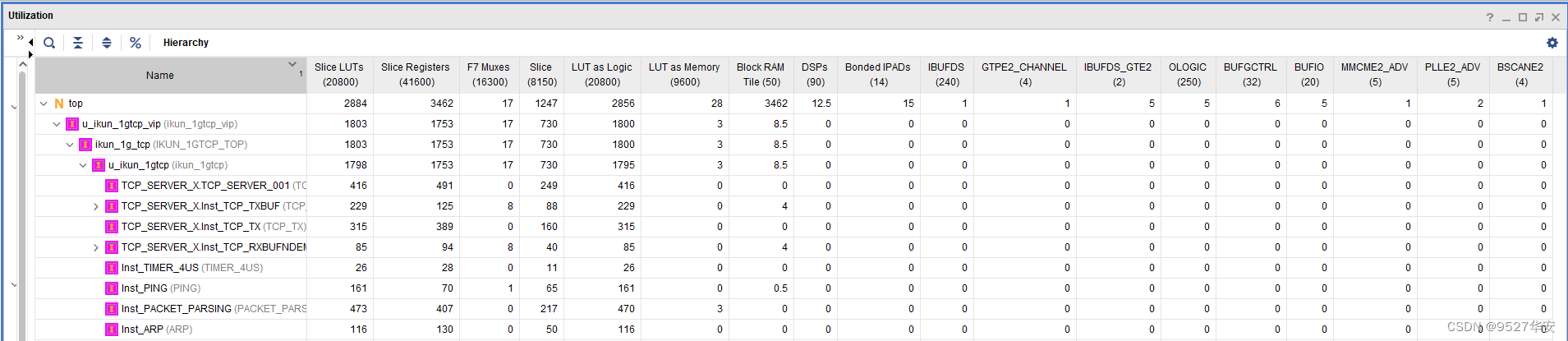

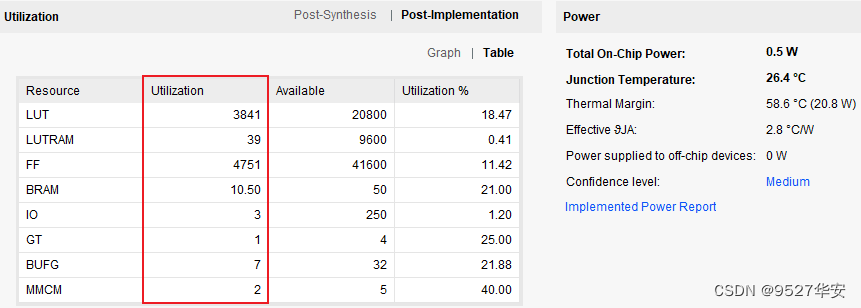

FPGA资源占用少

FPGA资源消耗是TCP里面最重要的性能指标之一,这里需要重点讲述:

FPGA资源消耗很低;以下举例:

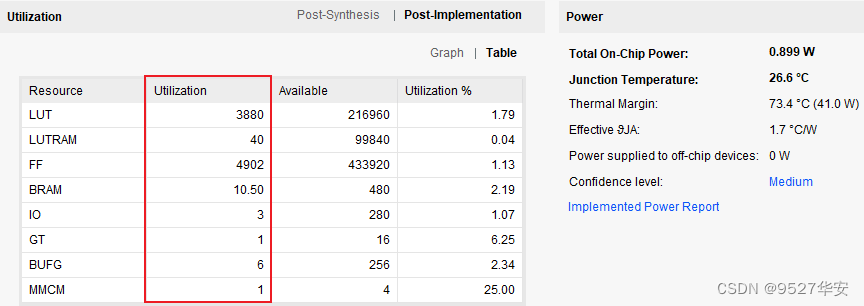

以Xilinx系列Artix7-35T平台为例,TCP/IP协议栈的资源消耗如下:

数据吞吐率高

数据吞吐率是TCP里面最重要的性能指标之一,这里需要重点讲述:

下面给出4项测试结果,你可以自己对比评估以下:

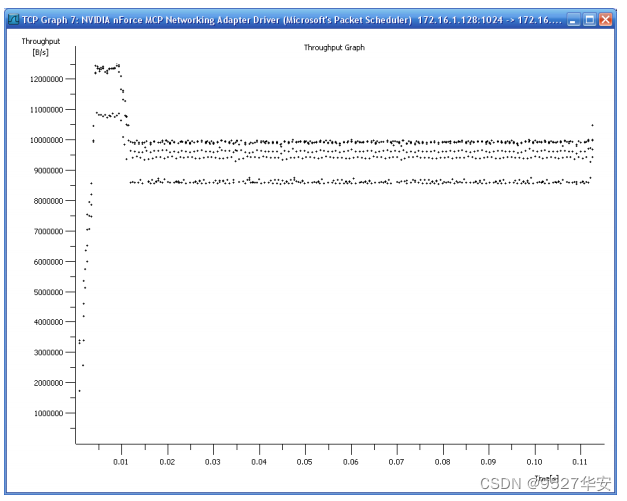

测试1:

通过千兆以太网在TCP服务器和TCP客户端之间双向连接,FPGA参考时钟120 MHz条件下,测量的持续吞吐率为双向并发452 Mbits/s;

测试2:

Xilinx Spartan-6 -2速度等级,FPGA参考时钟120 MHz,512字节的UDP数据包通过局域网点对点发送下测得:

0丢包,吞吐率为878.5 Mbits/s;当用户时钟为125 MHz或以上时,UDP最大帧吞吐率为915 Mbits/s;

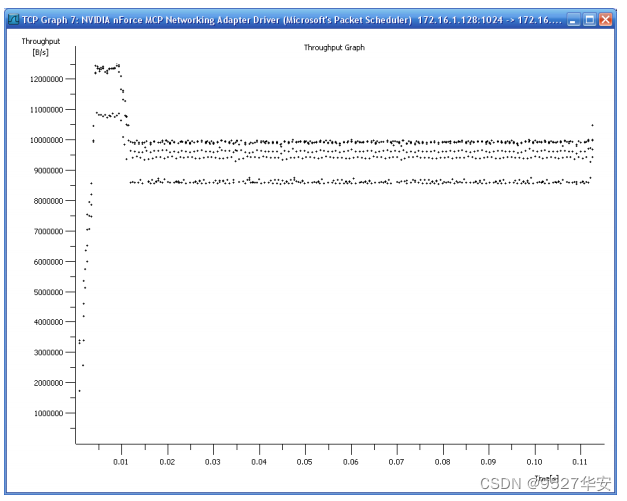

测试3:

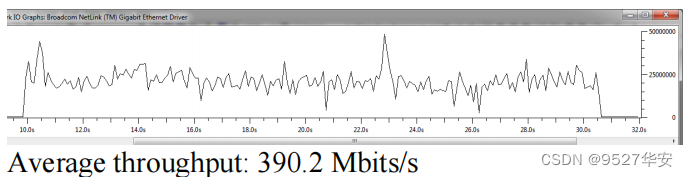

TCP服务器传输吞吐量在1百兆局域网下PC端测量平均吞吐量为93 Mbps,如下;

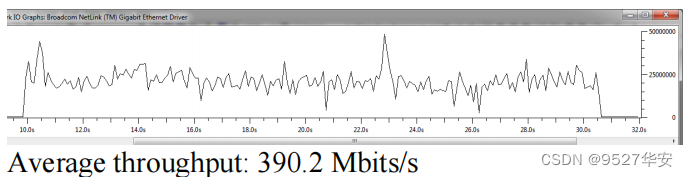

测试4:

TCP服务器将8Gbits发送到TCP Java客户端,同时Wireshark收集速度信息。从基于FPGA的TCP服务器到PC的点对点LAN连接平均吞吐率为390.2 Mbits/s;如下:

低延时性能

延时性能是TCP里面最重要的性能指标之一,这里需要重点讲述:

延时与TCP数据包长直接相关,如果你对延时性能性能要求很高,则可以减少包长来有效降低延时,假设你的载包为X bytes,那么你的收发延时关系如下:

发送延时=0.5 + 2X÷125 µs;

接收延时=0.5 + X÷125 µs;

最大帧长度为1460字节,FPGA 时钟125 MHz下的测试结果如下:

发送延时=23.9µs;

接收延时=12.2µs;

TCP/IP协议栈服务器–>接口描述

由于TCP/IP协议栈主体部分由VHDL代码编写,导致可读性较差,毕竟很多朋友都是直接学的verilog语言,对VHDL并不熟悉,所以我们用verilog模块对VHDL模块做了例化形成verilog的顶层模块接口供用户例化,所以TCP/IP协议栈顶层接口如下:

module ikun_1gtcp_vip #(

parameter TCP_NUM = 1 , // tcp 端口数量,这里仅用到了1个

parameter CLK_FREQUENCY = 125 , // 参考时钟频率,比如输入时钟为125M,则CLK_FREQUENCY=125

parameter TX_IDLE_TIMEOUT = 50 , // 以太网帧发送间隔

parameter IPVX_ADDR_LOOP = 1 , // 目的IP地址回环使能; 1-->不需要指定目的IP地址; 0-->需要指定目的IP地址;

parameter SIMULATION = 1'b0 // 仿真模式; 1-->开启仿真模式; 0-->关闭仿真模式; 默认关闭

)(

// 时钟和复位

input clk , // 参考时钟

input sync_reset , // 同步复位

input async_reset , // 异步复位

// 配置端口

input [ 47:0] fpga_MAC_addr , // FPGA网卡MAC地址

input [ 31:0] fpga_IPV4_addr , // FPGA网卡IPV4地址

input [127:0] fpga_IPV6_addr , // FPGA网卡IPV6地址

input [ 31:0] fpga_multicast_addr, // FPGA网卡组播地址

input [ 31:0] fpga_subnet_addr , // FPGA网卡子网掩码

input [ 31:0] fpga_gaitway_addr , // FPGA网卡网关地址

input [16*TCP_NUM-1:0] fpga_tcp_port , // FPGA网卡端口号

input [ 31:0] PC_IPV4_addr , // 远端网卡IPV4地址

input [ 15:0] PC_tcp_port , // 远端网卡端口号

output [ 15:0] PC_tcp_port_out , // 远端网卡端口号

// MAC层接口信号

output [ 7:0] mac_tx_tdata , // 输出--MAC层发送数据

input mac_tx_tready , // 输入--MAC层发送数据准备好

output mac_tx_tvalid , // 输出--MAC层发送数据有效

output mac_tx_tuser , // 输出--MAC层发送数据开始

output mac_tx_tlast , // 输出--MAC层发送数据结尾

input [ 7:0] mac_rx_tdata , // 输入--MAC层接收数据

input mac_rx_tvalid , // 输入--MAC层接收数据有效

input mac_rx_tuser , // 输入--MAC层接收数据开始

input mac_rx_tlast , // 输入--MAC层接收数据结尾

// UDP协议栈用户接口信号

output [ 7:0] udp_rx_tdata , // 输出--UDP协议栈用户接收数据

output udp_rx_tvalid , // 输出--UDP协议栈用户接收数据有效

output udp_rx_tuser , // 输出--UDP协议栈用户接收数据开始

output udp_rx_tlast , // 输出--UDP协议栈用户接收数据结束

input [ 7:0] udp_tx_tdata , // 输入--UDP协议栈用户发送数据

input udp_tx_tvalid , // 输入--UDP协议栈用户发送数据有效

output udp_tx_tready , // 输入--UDP协议栈用户发送数据准备好

input udp_tx_tuser , // 输入--UDP协议栈用户发送数据开始

input udp_tx_tlast , // 输入--UDP协议栈用户发送数据结束

output udp_tx_ack , // 输入--UDP协议栈用户发送数据应答

output udp_tx_nak , // 输入--UDP协议栈用户发送数据无应答

// TCP协议栈用户接口信号

output [8*TCP_NUM-1:0] tcp_rx_tdata , // 输出--TCP协议栈用户接收数据

output [TCP_NUM-1:0] tcp_rx_tvalid , // 输出--TCP协议栈用户接收数据有效

output [TCP_NUM-1:0] tcp_rx_tready , // 输出--TCP协议栈用户接收数据准备好

input [TCP_NUM-1:0] tcp_rx_tkeep , // 输入--TCP协议栈用户接收数据选通

input [8*TCP_NUM-1:0] tcp_tx_tdata , // 输入--TCP协议栈用户发送数据

input [TCP_NUM-1:0] tcp_tx_tvalid , // 输入--TCP协议栈用户发送数据有效

output [TCP_NUM-1:0] tcp_tx_tkeep // 输出--TCP协议栈用户发送数据选通

);

TCP/IP协议栈接口是用户逻辑与TCP/IP协议栈对接的,所以这部分非常重要,用户想要把TCP/IP协议栈用起来,理论上只需要掌握其用户接口的使用即可;

其中的parameter参数有详细注释;

配置端口用户对FPGA开发板做网卡级别的配置,包括IP、MAC地址等;

MAC层接口与Tri Mode Ethernet MAC IP核对接;

UDP协议栈用户接口暂时用不到;

TCP协议栈用户接口是用户逻辑直接对接的接口;

具体可参考工程源码中对该模块的调用;

TCP/IP协议栈客户端–>简介

本TCP/IP协议栈为纯VHDL实现的千兆网速率客户端版本,可实现TCP协议网络通信,针对不同需求,提供两个版本的模块,一种是TCP/IP 协议栈源码,即完全看得到并可修改的纯源码;另一种是TCP/IP 协议栈网表,可以正常调用、例化并使用,但看不到TCP/IP 协议栈源码也不能修改;TCP/IP协议栈基本设计框架如下:

、

其中的UDP我们没有用到,只用到了TCP;

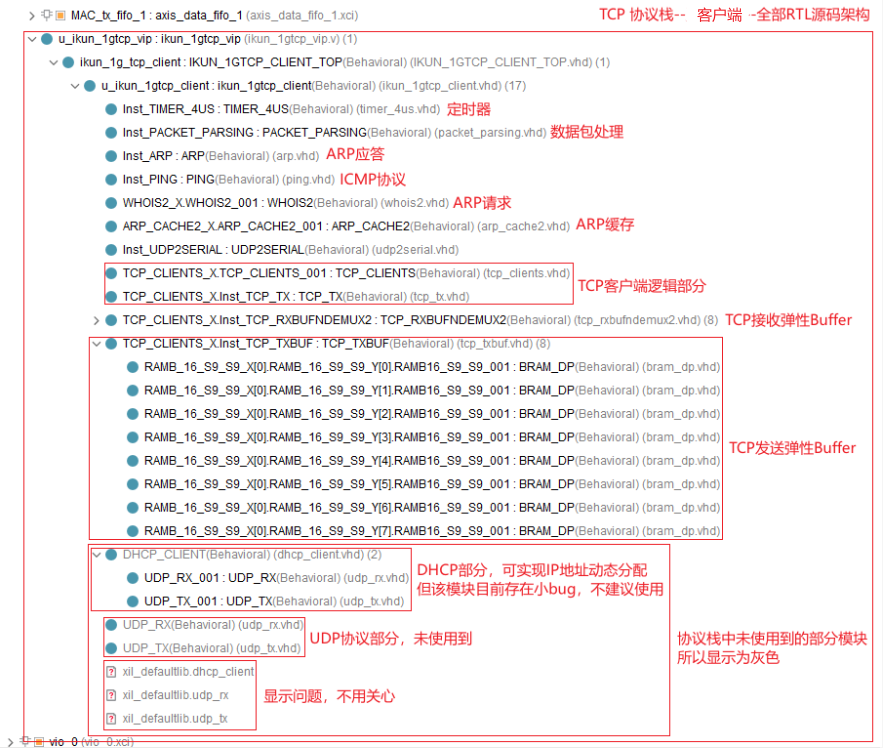

TCP/IP协议栈客户端–>源码架构

TCP/IP 协议栈源码架构如下:

TCP/IP协议栈客户端–>性能简介

此TCP/IP协议栈是TCP客户端,不是服务器;即FPGA是TCP客户端,远程节点(比如 PC 电脑)是服务器;

常规性能

1:纯VHDL实现,没有用到任何一个IP核;

2:移植性天花板,该协议栈可在Xilinx、Altera、Lattice、国产FPGA等各大FPGA型号之间任意移植,因为是没有任何IP和源语的纯VHDL代码实现;但例如Tri Mode Ethernet MAC这样的PHY侧IP核目前用的Xilinx的;

3:功能齐全,包含了客户端;TCP/IP协议栈本身包含了动态ARP、NDP、PING、IGMP (for multicast UDP)、DHCP等功能模块,但DHCP目前存在小BUG,不建议使用,具体就是DHCP实现了IP地址动态分配,也能ping通,但在传输TCP数据时有错误,有时甚至无法连接TCP客户端;

4:代码符合标准的IEEE 802.3协议,支持IPv4和IPv6;

5:对外接PHY的数据格式要求:RGMII;

6:时序收敛很到位,考虑到TCP协议的复杂性和时序的高要求,所以没有采用时序收敛不强的verilog,而是VHDL,虽然阅读性可能会低一些,但用户只需要知道用户接口即可,并不需要去看内部的复杂代码;

7:动态ARP功能;

8:带ping功能;

9:支持多播;

支持多节点

支持节点数是TCP里面最重要的性能指标之一,这里需要重点讲述:

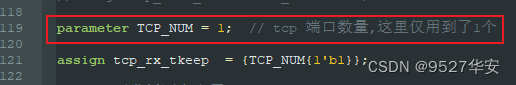

TCP节点数最大支持255个,通过parameter TCP_NUM参数设置,但前提是你的FPGA资源能满足;TCP_NUM参数可以在代码中自由修改,含义和用法,在代码里有详细的注释,为了防止不同编译器下中文注释出现乱码,注释均由英文书写,英语较差的兄弟可以直接某度翻译,位置如下:

本例程只用到了1个节点;

此外,使用TCP/IP 协议栈网表的工程不支持多节点,没有此参数配置;

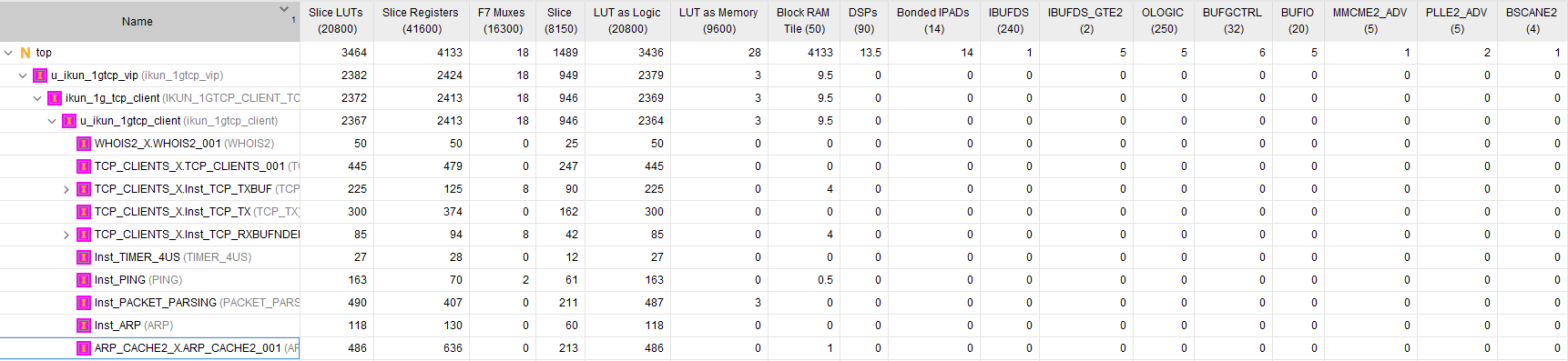

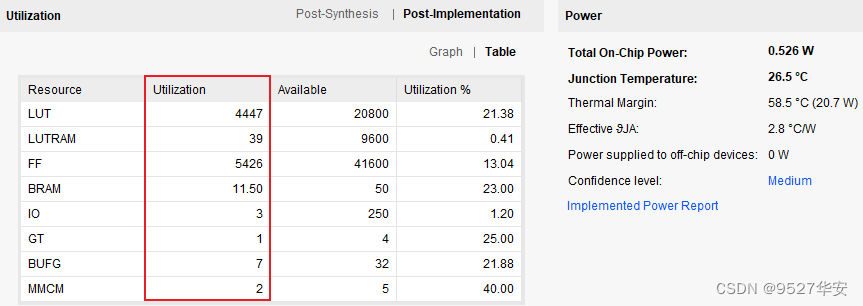

FPGA资源占用少

FPGA资源消耗是TCP里面最重要的性能指标之一,这里需要重点讲述:

FPGA资源消耗很低;以下举例:

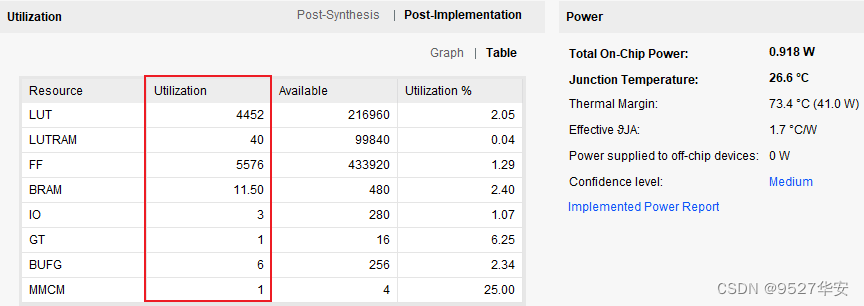

以Xilinx系列Artix7-35T平台为例,TCP/IP协议栈的资源消耗如下:

数据吞吐率高

数据吞吐率是TCP里面最重要的性能指标之一,这里需要重点讲述:

下面给出4项测试结果,你可以自己对比评估以下:

测试1:

通过千兆以太网在TCP服务器和TCP客户端之间双向连接,FPGA参考时钟120 MHz条件下,测量的持续吞吐率为双向并发452 Mbits/s;

测试2:

Xilinx Spartan-6 -2速度等级,FPGA参考时钟120 MHz,512字节的UDP数据包通过局域网点对点发送下测得:

0丢包,吞吐率为878.5 Mbits/s;当用户时钟为125 MHz或以上时,UDP最大帧吞吐率为915 Mbits/s;

测试3:

TCP服务器传输吞吐量在1百兆局域网下PC端测量平均吞吐量为93 Mbps,如下;

测试4:

TCP服务器将8Gbits发送到TCP Java客户端,同时Wireshark收集速度信息。从基于FPGA的TCP服务器到PC的点对点LAN连接平均吞吐率为390.2 Mbits/s;如下:

低延时性能

延时性能是TCP里面最重要的性能指标之一,这里需要重点讲述:

延时与TCP数据包长直接相关,如果你对延时性能性能要求很高,则可以减少包长来有效降低延时,假设你的载包为X bytes,那么你的收发延时关系如下:

发送延时=0.5 + 2X÷125 µs;

接收延时=0.5 + X÷125 µs;

最大帧长度为1460字节,FPGA 时钟125 MHz下的测试结果如下:

发送延时=23.9µs;

接收延时=12.2µs;

TCP/IP协议栈客户端–>接口描述

由于TCP/IP协议栈主体部分由VHDL代码编写,导致可读性较差,毕竟很多朋友都是直接学的verilog语言,对VHDL并不熟悉,所以我们用verilog模块对VHDL模块做了例化形成verilog的顶层模块接口供用户例化,所以TCP/IP协议栈顶层接口如下:

module ikun_1gtcp_vip #(

parameter TCP_NUM = 1 , // tcp 端口数量,这里仅用到了1个

parameter FPGA_TCP_PORT_B = 16'd1024, // FPGA网卡--tcp客户端--端口号

parameter CLK_FREQUENCY = 125 , // 参考时钟频率,比如输入时钟为125M,则CLK_FREQUENCY=125

parameter TX_IDLE_TIMEOUT = 50 , // 以太网帧发送间隔

parameter IPVX_ADDR_LOOP = 1 , // 目的IP地址回环使能; 1-->不需要指定目的IP地址; 0-->需要指定目的IP地址;

parameter SIMULATION = 1'b0 // 仿真模式; 1-->开启仿真模式; 0-->关闭仿真模式; 默认关闭

)(

// 时钟和复位

input clk , // 参考时钟

input sync_reset , // 同步复位

input async_reset , // 异步复位

output [4*TCP_NUM-1:0] tcp_status_out , // TCP连接状态; idle (0), connecting (1), connected (2), unreacheable IP (3), destination port busy (4)

// 配置端口

input client_dhcp_en , // 0-->disable client_dhcp ; 1-->enable client_dhcp

input [ 47:0] fpga_MAC_addr , // FPGA网卡MAC地址

input [ 31:0] fpga_static_IPV4_addr , // FPGA网卡静态IPV4地址

input [127:0] fpga_IPV6_addr , // FPGA网卡IPV6地址

input [ 31:0] fpga_subnet_addr , // FPGA网卡子网掩码

input [ 31:0] fpga_static_gaitway_addr, // FPGA网卡静态网关地址

input [16*TCP_NUM-1:0] fpga_tcp_port , // FPGA网卡端口号

input [ 31:0] PC_IPV4_addr , // 远端网卡IPV4地址

input [ 15:0] PC_tcp_port , // 远端网卡端口号

output [ 15:0] PC_tcp_port_out , // 远端网卡端口号

// MAC层接口信号

output [ 7:0] mac_tx_tdata , // 输出--MAC层发送数据

input mac_tx_tready , // 输入--MAC层发送数据准备好

output mac_tx_tvalid , // 输出--MAC层发送数据有效

output mac_tx_tuser , // 输出--MAC层发送数据开始

output mac_tx_tlast , // 输出--MAC层发送数据结尾

input [ 7:0] mac_rx_tdata , // 输入--MAC层接收数据

input mac_rx_tvalid , // 输入--MAC层接收数据有效

input mac_rx_tuser , // 输入--MAC层接收数据开始

input mac_rx_tlast , // 输入--MAC层接收数据结尾

// UDP协议栈用户接口信号

output [ 7:0] udp_rx_tdata , // 输出--UDP协议栈用户接收数据

output udp_rx_tvalid , // 输出--UDP协议栈用户接收数据有效

output udp_rx_tuser , // 输出--UDP协议栈用户接收数据开始

output udp_rx_tlast , // 输出--UDP协议栈用户接收数据结束

input [ 7:0] udp_tx_tdata , // 输入--UDP协议栈用户发送数据

input udp_tx_tvalid , // 输入--UDP协议栈用户发送数据有效

output udp_tx_tready , // 输入--UDP协议栈用户发送数据准备好

input udp_tx_tuser , // 输入--UDP协议栈用户发送数据开始

input udp_tx_tlast , // 输入--UDP协议栈用户发送数据结束

output udp_tx_ack , // 输入--UDP协议栈用户发送数据应答

output udp_tx_nak , // 输入--UDP协议栈用户发送数据无应答

// TCP协议栈用户接口信号

output [8*TCP_NUM-1:0] tcp_rx_tdata , // 输出--TCP协议栈用户接收数据

output [TCP_NUM-1:0] tcp_rx_tvalid , // 输出--TCP协议栈用户接收数据有效

output [TCP_NUM-1:0] tcp_rx_tready , // 输出--TCP协议栈用户接收数据准备好

input [TCP_NUM-1:0] tcp_rx_tkeep , // 输入--TCP协议栈用户接收数据选通

input [8*TCP_NUM-1:0] tcp_tx_tdata , // 输入--TCP协议栈用户发送数据

input [TCP_NUM-1:0] tcp_tx_tvalid , // 输入--TCP协议栈用户发送数据有效

output [TCP_NUM-1:0] tcp_tx_tkeep // 输出--TCP协议栈用户发送数据选通

);

TCP/IP协议栈接口是用户逻辑与TCP/IP协议栈对接的,所以这部分非常重要,用户想要把TCP/IP协议栈用起来,理论上只需要掌握其用户接口的使用即可;

其中的parameter参数有详细注释;

配置端口用户对FPGA开发板做网卡级别的配置,包括IP、MAC地址等;

MAC层接口与Tri Mode Ethernet MAC IP核对接;

UDP协议栈用户接口暂时用不到;

TCP协议栈用户接口是用户逻辑直接对接的接口;

具体可参考工程源码中对该模块的调用;

需要注意的是,由于EDF网表不支持对parameter参数的封装,所以EDF网表版本的TCP/IP协议栈接口没有parameter参数,只有wire用户接口,FPGA网卡端的TCP端口号被固定为1024,且不可更改;

TCP用户数据测试模块

TCP用户数据测试模块集成了接收数据回环和数据测速功能,通过define宏定义选择,如下:

接收数据回环功能:

将接收数据回环发送出去,即形成发送=接收的自回环功能;该功能的作用是配合网络调试助手进行数据收发测试、数据丢包测试、数据正确性测试等;

数据数据测速:

FPGA自动循环向TCP/IP 协议栈发送累加的数据,数据内容从0开始累加,即形成连续发送数据功能;该功能的作用是配合PC端测试网络极限速率,打开电脑端的资源管理器,查看网卡,即可看到通信速率;值得注意的是,该方法并不能真实反映网速,用更为专业的网速测试软件为佳;

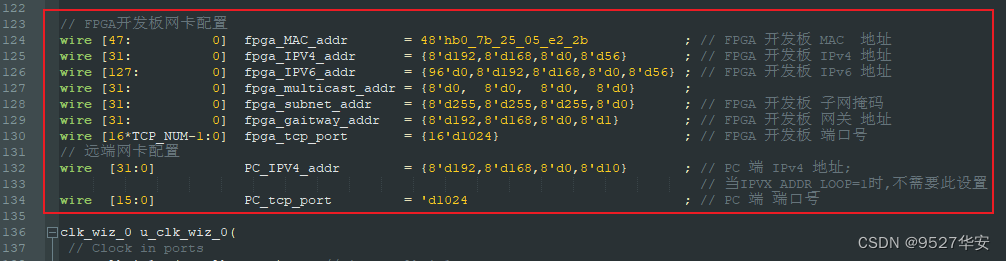

IP地址修改

每套工程均可修改FPGA开发板的IP地址、MAC地址、端口号等信息,同时也可以修改远程节点的IP地址、端口号等信息,当IPVX_ADDR_LOOP设置为1时,不需要指定远程节点的IP地址,这也是默认的工作方式,以工程源码1为例,代码里有注释,如下:

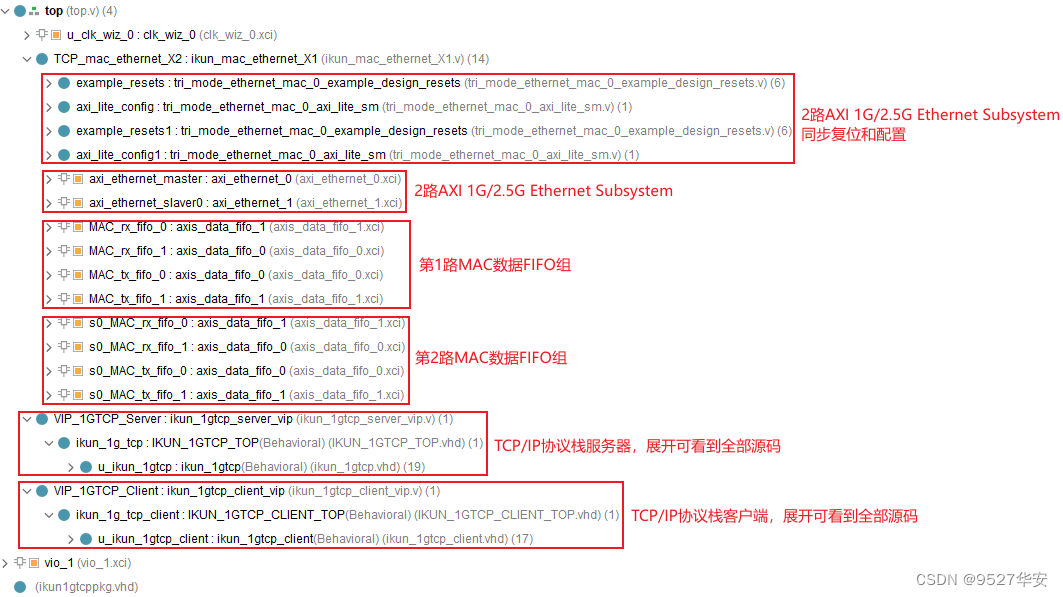

工程源码架构

18套工程的源码具有相似性,这里仅以工程3为例截图如下,其他工程与之类似:

注意!!!!

注意!!!!

上图为1主+1从的2路TCP协议栈架构,也就是用到了2路AXI 1G/2.5G Ethernet Subsystem,TCP协议栈用到了1路服务器+1路客户端,单独的服务器或客户端工程则只用到了1路AXI 1G/2.5G Ethernet Subsystem;

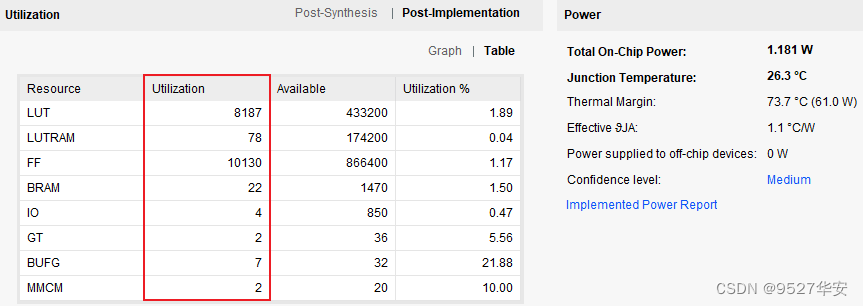

4、vivado工程1详解:Artix7版本,单路TCP服务器版本

开发板FPGA型号:Xilinx–>Artix7–>xc7a35tfgg484-2;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>服务器网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTP;

协议层方案:千兆TCP/IP协议栈–>服务器;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

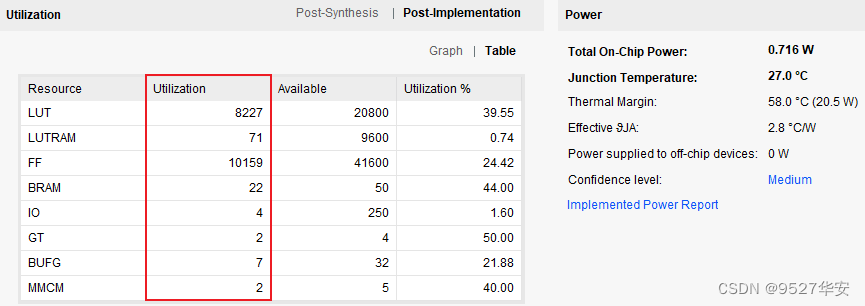

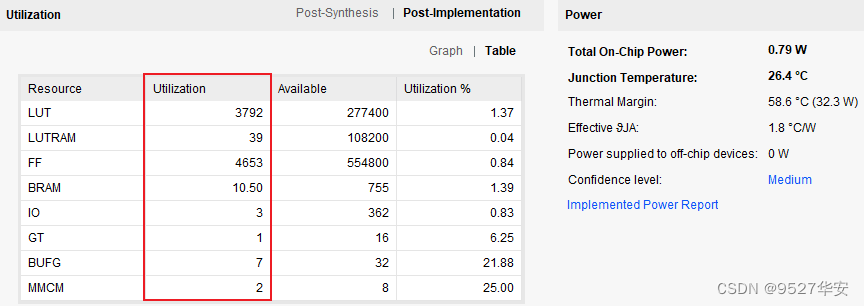

工程的资源消耗和功耗如下:

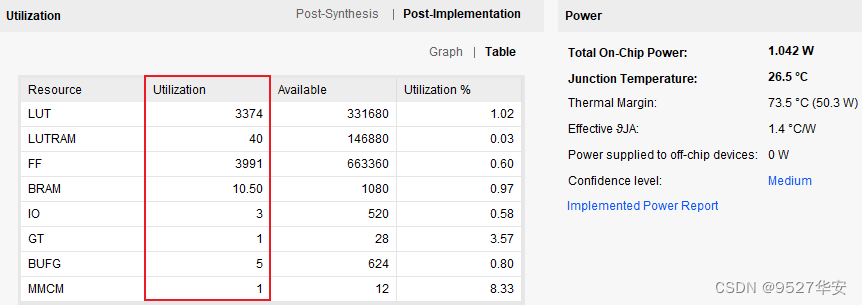

5、vivado工程2详解:Artix7版本,单路TCP客户端版本

开发板FPGA型号:Xilinx–>Artix7–>xc7a35tfgg484-2;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTP;

协议层方案:千兆TCP/IP协议栈–>客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

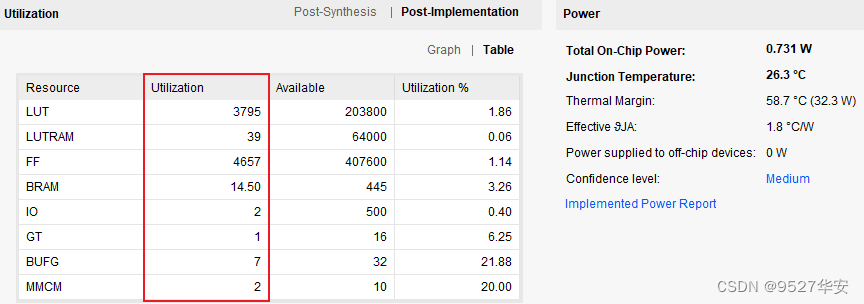

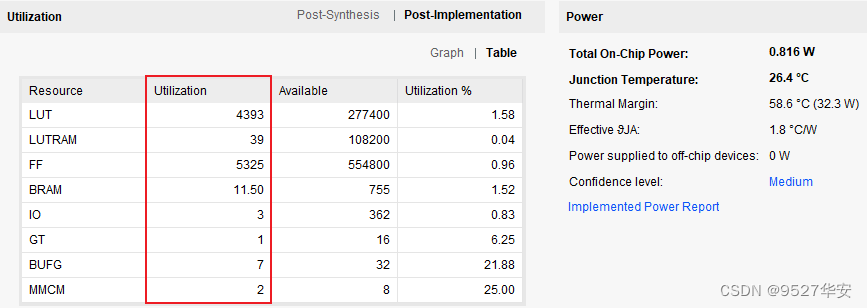

工程的资源消耗和功耗如下:

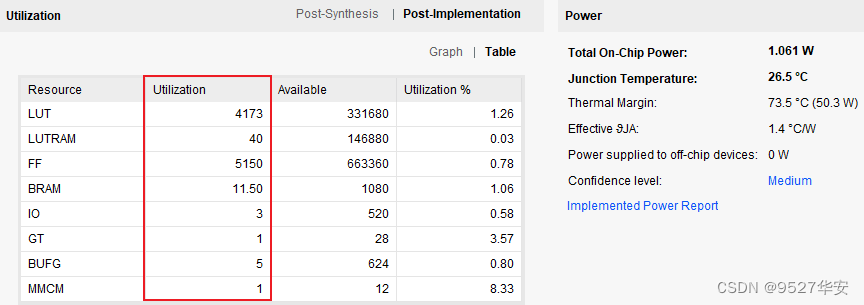

6、vivado工程3详解:Artix7版本,双路TCP客户端+客户端版本

开发板FPGA型号:Xilinx–>Artix7–>xc7a35tfgg484-2;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端/客户端网络数据;

接口:2路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:2路GTP;

协议层方案:1路千兆TCP/IP协议栈服务器+1路千兆TCP/IP协议栈客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

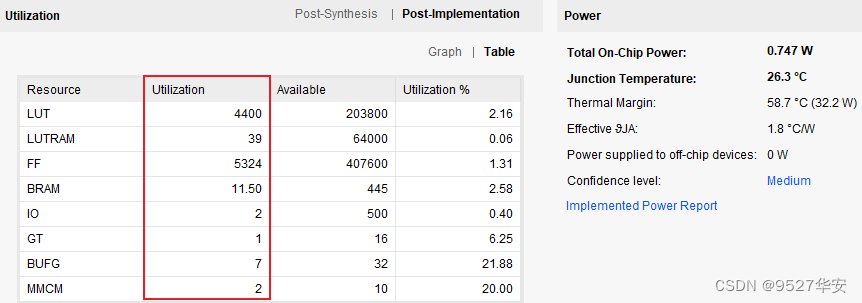

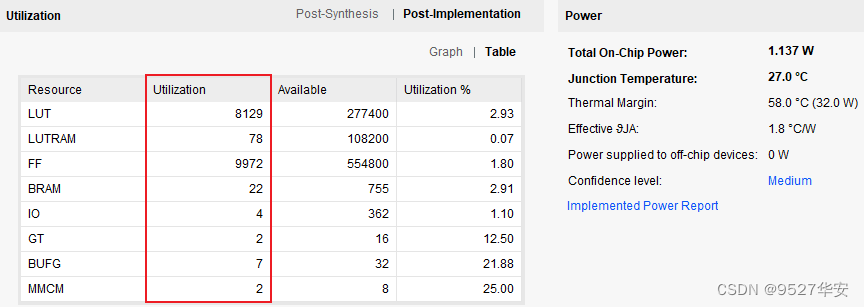

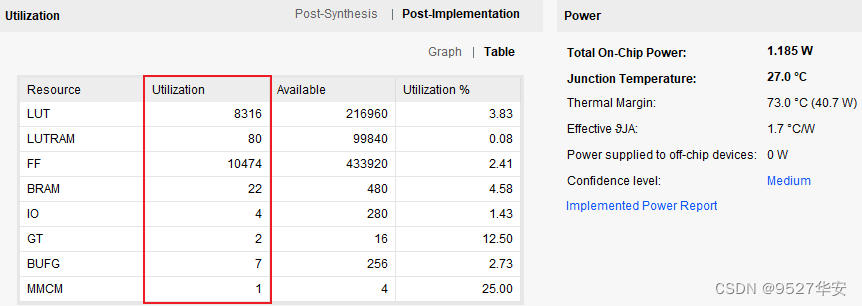

工程的资源消耗和功耗如下:

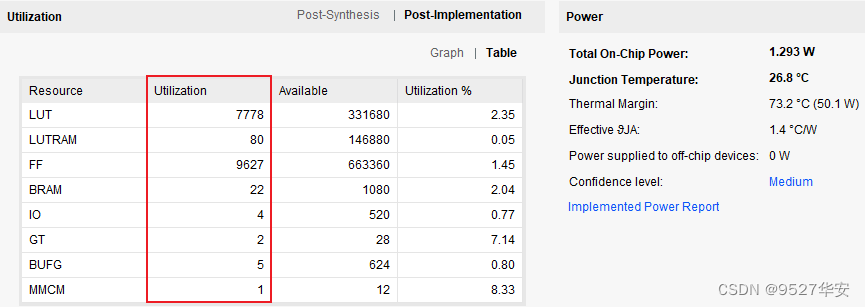

7、vivado工程4详解:Kintex7版本,单路TCP服务器版本

开发板FPGA型号:Xilinx–>Kintex7–>xc7k325tffg900-2;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>服务器网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTX;

协议层方案:千兆TCP/IP协议栈–>服务器;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

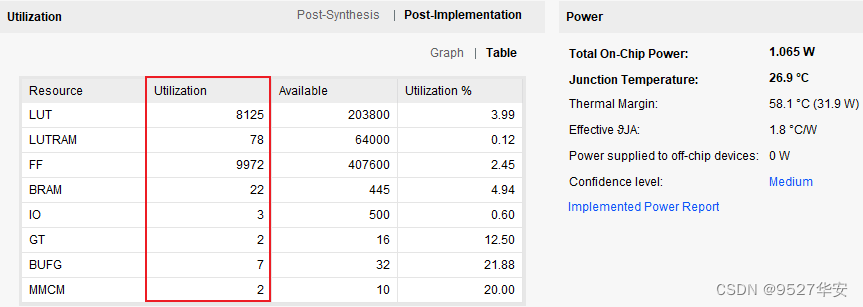

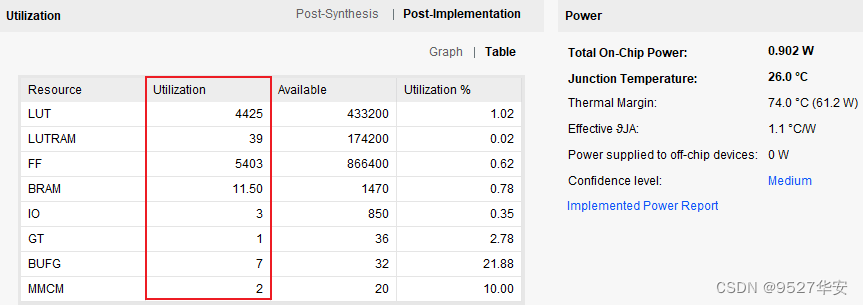

工程的资源消耗和功耗如下:

8、vivado工程5详解:Kintex7版本,单路TCP客户端版本

开发板FPGA型号:Xilinx–>Kintex7–>xc7k325tffg900-2;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTX;

协议层方案:千兆TCP/IP协议栈–>客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

9、vivado工程6详解:Kintex7版本,双路TCP客户端+客户端版本

开发板FPGA型号:Xilinx–>Kintex7–>xc7k325tffg900-2;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端/客户端网络数据;

接口:2路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:2路GTX;

协议层方案:1路千兆TCP/IP协议栈服务器+1路千兆TCP/IP协议栈客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

10、vivado工程7详解:Zynq7100版本,单路TCP服务器版本

开发板FPGA型号:Xilinx–Zynq7100–xc7z100ffg900-2;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>服务器网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTX;

协议层方案:千兆TCP/IP协议栈–>服务器;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

11、vivado工程8详解:Zynq7100版本,单路TCP客户端版本

开发板FPGA型号:Xilinx–Zynq7100–xc7z100ffg900-2;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTX;

协议层方案:千兆TCP/IP协议栈–>客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

12、vivado工程9详解:Zynq7100版本,双路TCP客户端+客户端版本

开发板FPGA型号:Xilinx–Zynq7100–xc7z100ffg900-2;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端/客户端网络数据;

接口:2路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:2路GTX;

协议层方案:1路千兆TCP/IP协议栈服务器+1路千兆TCP/IP协议栈客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

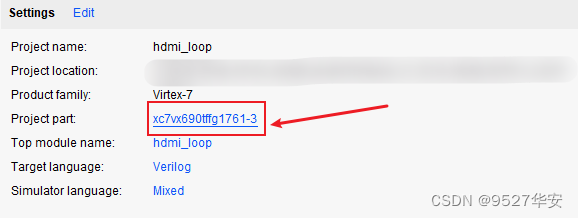

13、vivado工程10详解:Virtx7版本,单路TCP服务器版本

开发板FPGA型号:Xilinx–Virtx7–xc7vx690tffg1761-3;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>服务器网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTH;

协议层方案:千兆TCP/IP协议栈–>服务器;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

14、vivado工程11详解:Virtx7版本,单路TCP客户端版本

开发板FPGA型号:Xilinx–Virtx7–xc7vx690tffg1761-3;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTH;

协议层方案:千兆TCP/IP协议栈–>客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

15、vivado工程12详解:Virtx7版本,双路TCP客户端+客户端版本

开发板FPGA型号:Xilinx–Virtx7–xc7vx690tffg1761-3;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端/客户端网络数据;

接口:2路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:2路GTH;

协议层方案:1路千兆TCP/IP协议栈服务器+1路千兆TCP/IP协议栈客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

16、vivado工程13详解:KU060版本,单路TCP服务器版本

开发板FPGA型号:Xilinx-- Kintex UltraScale–xcku060-ffva1156-2-i;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>服务器网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTH;

协议层方案:千兆TCP/IP协议栈–>服务器;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

17、vivado工程14详解:KU060版本,单路TCP客户端版本

开发板FPGA型号:Xilinx-- Kintex UltraScale–xcku060-ffva1156-2-i;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTH;

协议层方案:千兆TCP/IP协议栈–>客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

18、vivado工程15详解:KU060版本,双路TCP客户端+客户端版本

开发板FPGA型号:Xilinx-- Kintex UltraScale–xcku060-ffva1156-2-i;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端/客户端网络数据;

接口:2路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:2路GTH;

协议层方案:1路千兆TCP/IP协议栈服务器+1路千兆TCP/IP协议栈客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

19、vivado工程16详解:KU5P版本,单路TCP服务器版本

开发板FPGA型号:Xilinx-- Kintex UltraScale±-xcku5p-ffvb676-1-i;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>服务器网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTY;

协议层方案:千兆TCP/IP协议栈–>服务器;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

20、vivado工程17详解:KU5P版本,单路TCP客户端版本

开发板FPGA型号:Xilinx-- Kintex UltraScale±-xcku5p-ffvb676-1-i;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端网络数据;

接口:1路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:1路GTY;

协议层方案:千兆TCP/IP协议栈–>客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

21、vivado工程18详解:KU5P版本,双路TCP客户端+客户端版本

开发板FPGA型号:Xilinx-- Kintex UltraScale±-xcku5p-ffvb676-1-i;

开发环境:Vivado2019.1;

输入输出:以太网帧,TCP/IP协议栈–>客户端/客户端网络数据;

接口:2路SFP,1G线速率;

PHY+MAC方案:Xilinx官方AXI 1G/2.5G Ethernet Subsystem方案;

PHY使用高速接口资源:2路GTY;

协议层方案:1路千兆TCP/IP协议栈服务器+1路千兆TCP/IP协议栈客户端;

工程源码架构请参考前面第3章节中的《工程源码架构》小节;

工程作用:此工程目的是让读者掌握FPGA基于AXI 1G/2.5G Ethernet Subsystem的TCP/IP协议栈设计能力,以便能够移植和设计自己的项目;

工程的资源消耗和功耗如下:

22、工程移植说明

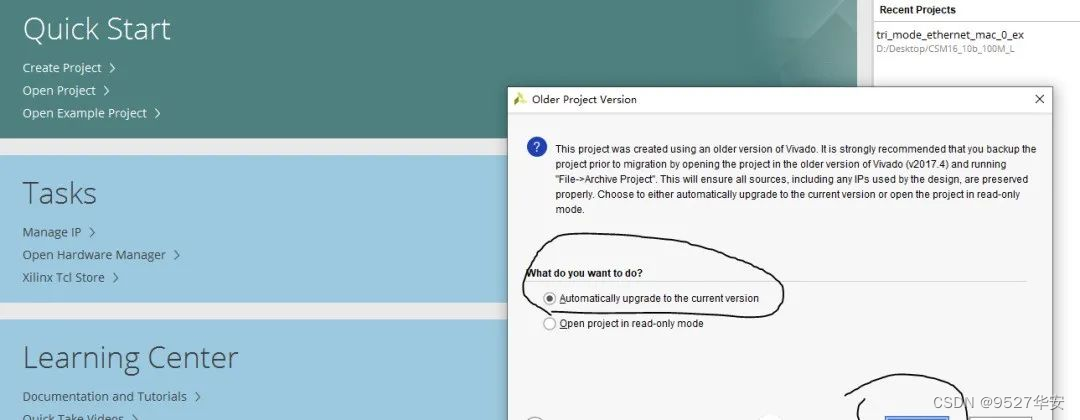

vivado版本不一致处理

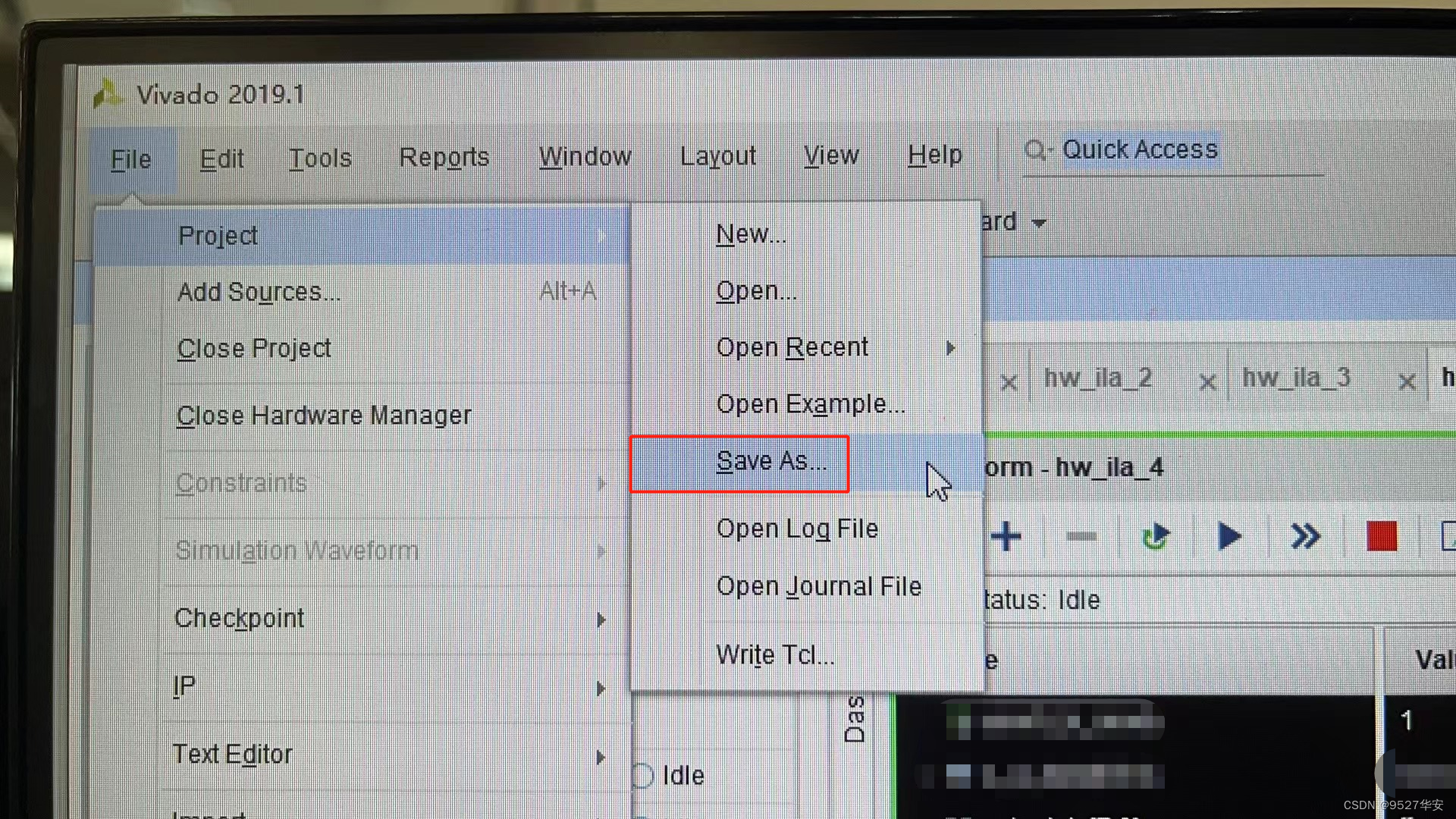

1:如果你的vivado版本与本工程vivado版本一致,则直接打开工程;

2:如果你的vivado版本低于本工程vivado版本,则需要打开工程后,点击文件–>另存为;但此方法并不保险,最保险的方法是将你的vivado版本升级到本工程vivado的版本或者更高版本;

3:如果你的vivado版本高于本工程vivado版本,解决如下:

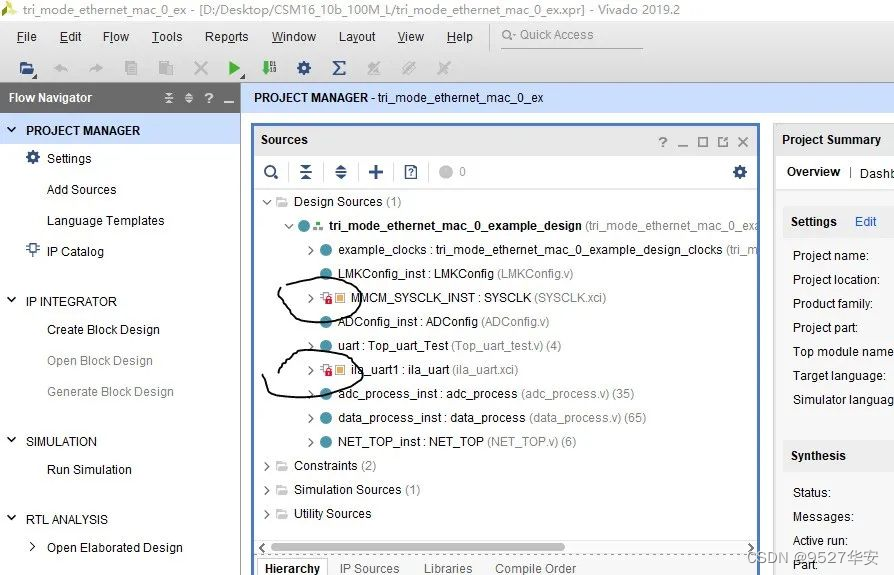

打开工程后会发现IP都被锁住了,如下:

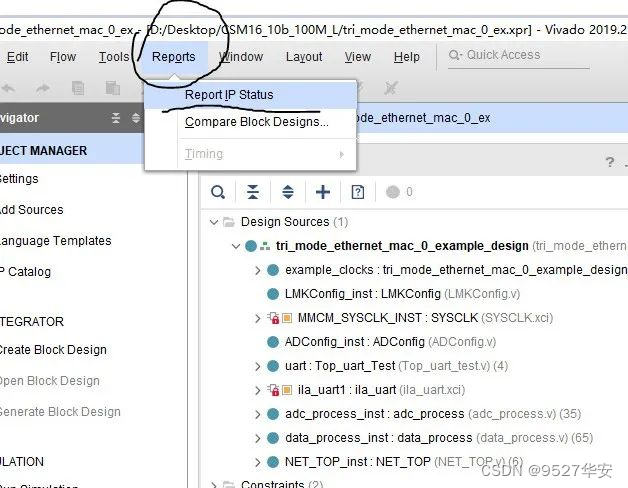

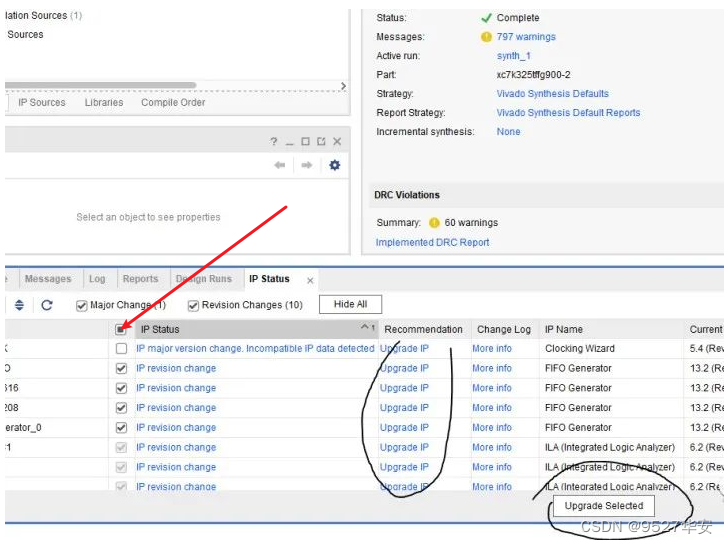

此时需要升级IP,操作如下:

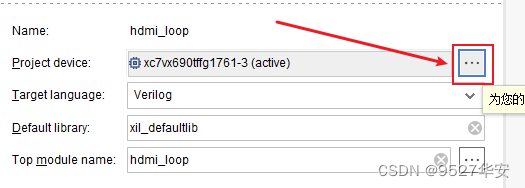

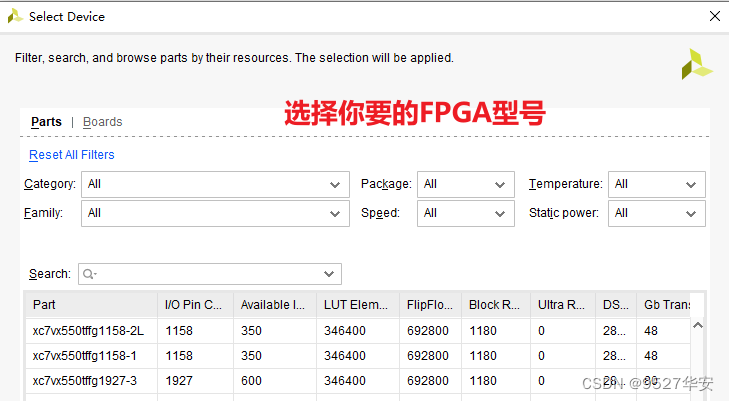

FPGA型号不一致处理

如果你的FPGA型号与我的不一致,则需要更改FPGA型号,操作如下:

更改FPGA型号后还需要升级IP,升级IP的方法前面已经讲述了;

其他注意事项

1:由于每个板子的DDR不一定完全一样,所以MIG IP需要根据你自己的原理图进行配置,甚至可以直接删掉我这里原工程的MIG并重新添加IP,重新配置;

2:根据你自己的原理图修改引脚约束,在xdc文件中修改即可;

3:纯FPGA移植到Zynq需要在工程中添加zynq软核;

23、上板调试验证并演示

准备工作

试验需要准备以下设备:

FPGA开发板,可以自行购买,也可以找本博主购买同款开发板;

测试电脑;

SFP转RJ45电口,千兆网线;

网络调试助手;

以工程源码1的开发板为例进行上板调试;

连接如下:

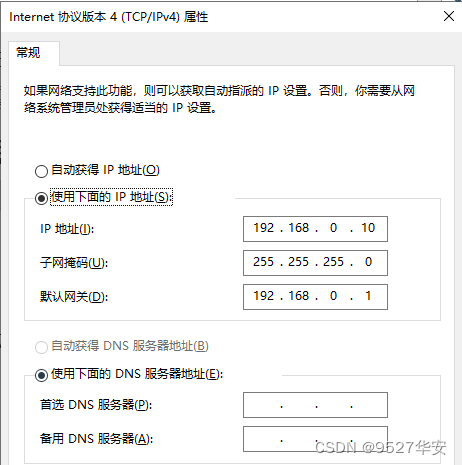

首先设置电脑端IP如下:

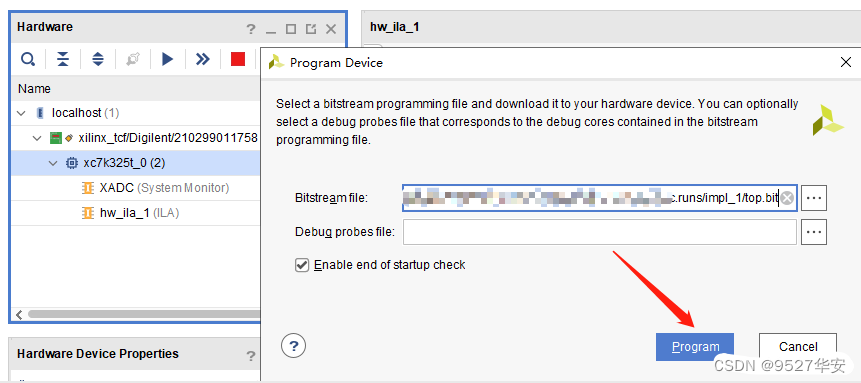

然后下载bit,如下:

ping测试

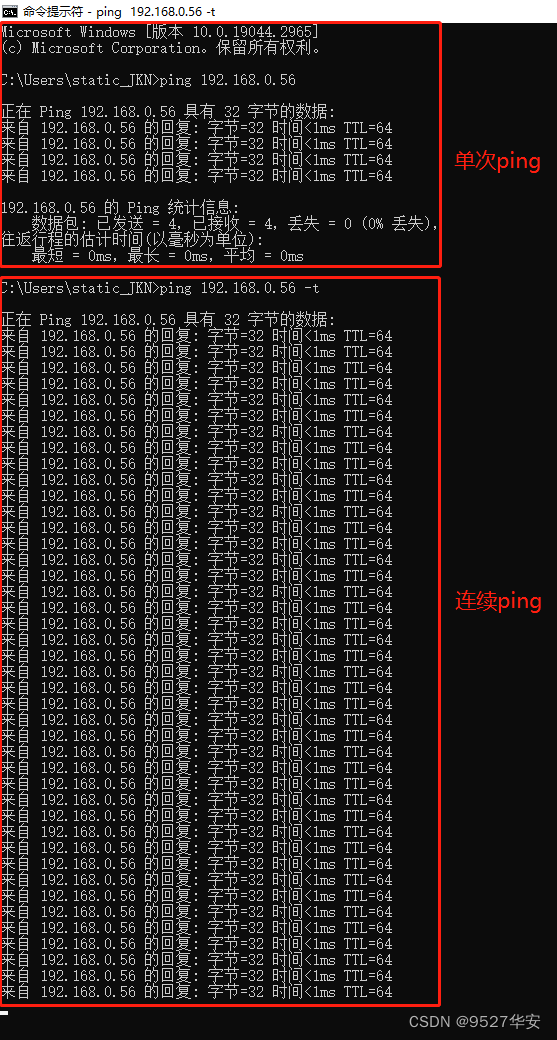

打开cdm,输入 ping 192.168.0.56,如下:

ping测试视频演示如下,请点击观看:

千兆网TCP协议栈ping操作

数据回环测试

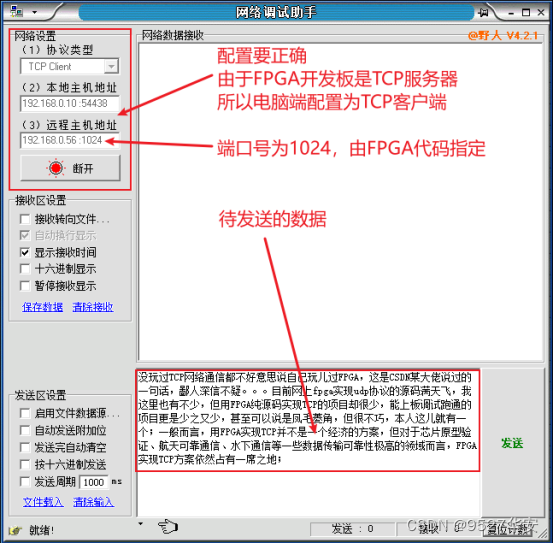

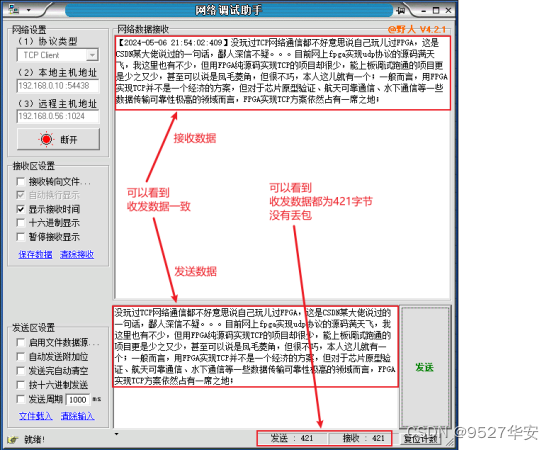

以工程源码1为例,打开网络调试助手并配置,如下:

单次发送数据测试结果如下:

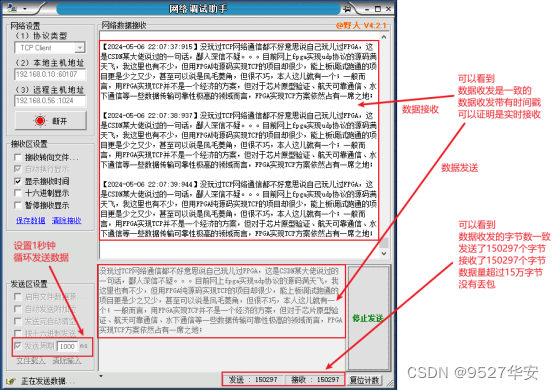

循环发送数据测试结果如下,1秒时间间隔循环:可以看到,数据收发量超过15万字节,没有丢包,足以证明其稳定性;

TCP数据回环测试视频演示如下,请点击观看:

千兆网TCP协议栈服务器数据收发测试

网络速度测试

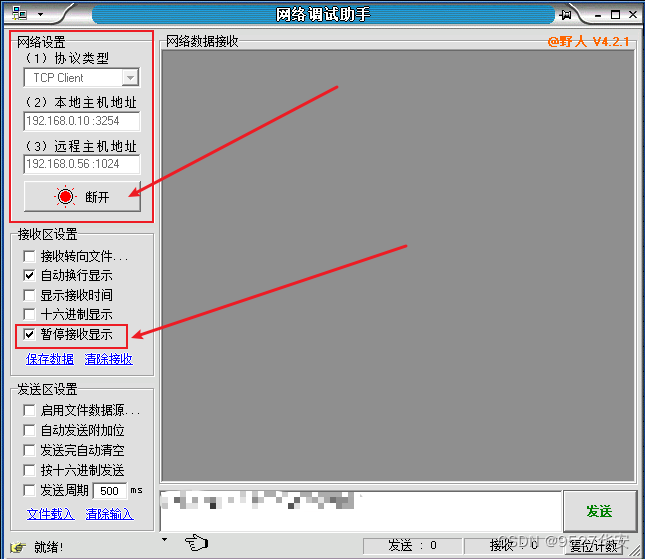

以工程源码1为例,下载测速的bit,打开网络调试助手,选择暂停接收显示,如下:

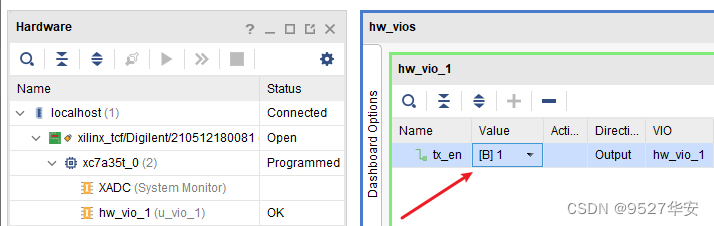

然后将测速bit里面的VIO打开,并将tx_en设置为1,如下:

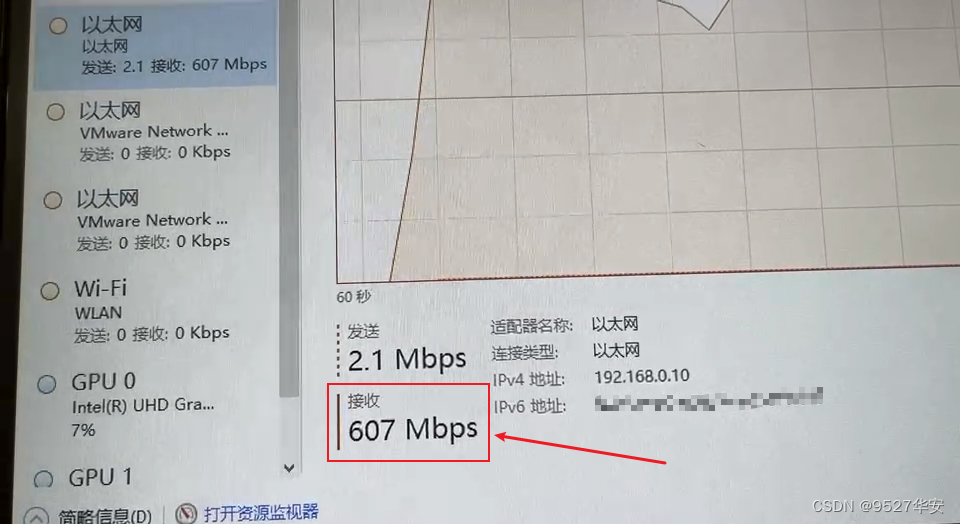

然后打开电脑资源管理器,点击性能,找到以太网网卡选项,即可看到测速,测速如下:

注意!!!

注意!!!

注意!!!

在电脑上观察到的是开发板以太网网口的发送速率,这个测速只代表可能的最高的速度,不代表电脑真实的不丢包速度,UDP 的点到点不丢包速度和电脑的网卡、CPU 速度、内存速度、操作系统都有关系。

TCP网络速度测试视频演示如下,请点击观看:

1G-TCP测速

24、福利:工程代码的获取

福利:工程代码的获取

代码太大,无法邮箱发送,以某度网盘链接方式发送,

资料获取方式:私,或者文章末尾的V名片。

网盘资料如下:

此外,有很多朋友给本博主提了很多意见和建议,希望能丰富服务内容和选项,因为不同朋友的需求不一样,所以本博主还提供以下服务:

778

778

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?