一、本文介绍

本文记录的是基于RevCol的RT-DETR目标检测改进方法研究。RevCol是一种新型神经网络设计范式,它由多个子网(列)及多级可逆连接构成,正向传播时特征逐渐解缠结且保持信息。可逆变换借鉴可逆神经网络思想,设计多级可逆单元用于解决模型对特征图形状的限制以及与信息瓶颈原则的冲突。本文将其应用到RT-DETR中,并配置了原论文中的revcol_tiny、revcol_small、revcol_base、 revcol_large和revcol_xlarge五种不同大小的模型,以适应不同的需求。

专栏目录:RT-DETR改进目录一览 | 涉及卷积层、轻量化、注意力、损失函数、Backbone、SPPF、Neck、检测头等全方位改进

文章目录

二、RevCol模型设计

2.1出发点

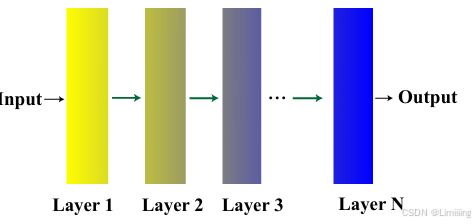

- 信息瓶颈原则的局限:传统监督学习网络遵循信息瓶颈原则(IB),如图所示,靠近输入的层包含更多低级信息,靠近输出的层富含语义信息,即与目标无关的信息在逐层传播中逐渐被压缩。但这种方式可能导致下游任务性能不佳,尤其当学习到的特征过度压缩或语义信息与目标任务无关,且源任务和目标任务存在领域差距时。

- 解缠结特征学习的需求:提出构建网络学习解缠结表示,不同于

IB学习,解缠结特征学习旨在将任务相关概念或语义分别嵌入到几个解耦维度,同时保持整个特征向量大致与输入有相同信息量,类似于生物细胞机制。

在计算机视觉任务中,学习解缠结特征是合理的,例如在Imag

订阅专栏 解锁全文

订阅专栏 解锁全文

725

725

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?