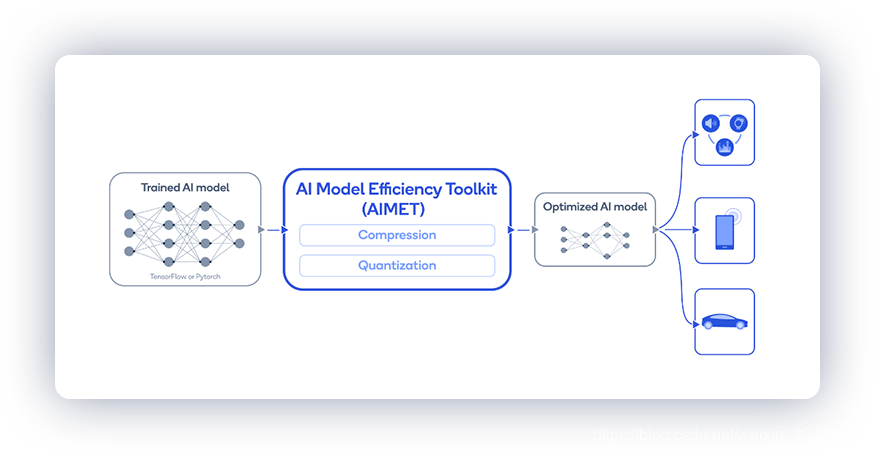

AI 模型效率工具包 (AIMET)

AIMET 是一个为经过训练的神经网络模型提供高级模型量化和压缩技术的库。 它提供的功能已被证明可以提高深度学习神经网络模型的运行时性能,并具有较低的计算和内存要求,并且对任务准确性的影响最小。

AIMET 旨在与 PyTorch 和 TensorFlow 模型配合使用。

AIMET 旨在与 PyTorch 和 TensorFlow 模型配合使用。

为什么选择 AIMET?

- 支持高级量化技术:使用整数运行时进行推理比使用浮点运行时快得多。 例如,模型在 Qualcomm Hexagon DSP 上的运行速度比在 Qualcomm Kyro CPU 上快 5 到 15 倍。 此外,8 位精度模型的占用空间比 32 位精度模型小 4 倍。 然而,在量化 ML 模型时保持模型准确性通常具有挑战性。 AIMET 使用无数据量化等新技术解决了这个问题,这些技术在几个流行模型上提供了最先进的 INT8 结果。

- 支持先进的模型压缩技术,使模型在推理时运行得更快并需要更少的内存。

- AIMET 旨在自动优化神经网络,避免耗时且繁琐的手动调整。 AIMET 还提供用户友好的 API,允许用户直接从他们的 TensorFlow 或 PyTorch 管道进行调用。

支持的功能

量化

- 跨层均衡:均衡权重张量以减少跨通道的幅度变化

- 偏差校正:校正由于量化而引入的层输出偏移

- 自适应舍入:学习给定未标记数据的最佳舍入

- 量化模拟:模拟目标量化推理精度

- 量化感知训练:使用量化模拟进一步训练模型以提高准确性

模型压缩

- 空间 SVD:张量分解技术将一个大层分成两个较小的层

- 通道修剪:从层中删除冗余输入通道并重建层权重

- 每层压缩比选择:自动选择模型中每一层的压缩量

可视化

- 权重范围:目视检查模型是否适合应用跨层均衡技术。以及应用该技术后的效果

- 每层压缩敏感性:直观地获得有关模型中任何给定层对压缩敏感性的反馈

最近添加的一些功能包括

- 自适应舍入(AdaRound):学习给定未标记数据的最佳舍入

- 循环模型(包括 RNN、LSTM 和 GRU)的量化感知训练 (QAT)

结果

AIMET 可以将现有的 32 位浮点模型量化为 8 位定点模型,而不会牺牲太多精度和模型微调。

DFQ

DFQ 方法应用于几个流行的网络,例如 MobileNet-v2 和 ResNet-50,在没有任何训练数据的情况下以自动化的方式导致准确度下降不到 0.9%,一直到 8 位量化。

AdaRound(自适应舍入)

ADAS 对象检测

对于这个示例 ADAS 对象检测模型,很难量化到 8 位精度,AdaRound 可以将精度恢复到 FP32 精度的 1% 以内。

DeepLabv3 语义分割

对于 DeepLabv3 语义分割模型等一些模型,AdaRound 甚至可以将模型权重量化到 4 位精度,而不会显着降低精度。

循环模型的量化

AIMET 支持循环模型(RNN、LSTM、GRU)的量化模拟和量化感知训练 (QAT)。 使用 AIMET 中的 QAT 功能,可以将具有双向 LSTM 的 DeepSpeech2 模型量化到 8 位精度,同时精度下降最小。

模型压缩

AIMET 还可以显着压缩模型。 对于流行的模型,例如 Resnet-50 和 Resnet-18,使用空间 SVD 和通道剪枝进行压缩可实现 50% 的 MAC(乘法-累加)减少,同时将精度保持在大约 50% 以内。 原始未压缩模型的 1%。

1109

1109

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?