#文本数据中加点代码

明确了:文本数据中加点代码,训练出的大模型更强、更通用

代码知识原来这么重要。

如今说起大语言模型(LLM),写代码能力恐怕是「君子六艺」必不可少的一项。

在预训练数据集中包含代码,即使对于并非专门为代码设计的大模型来说,也已是必不可少的事。虽然从业者们普遍认为代码数据在通用 LLM 的性能中起着至关重要的作用,但分析代码对非代码任务的精确影响的工作却非常有限。

在最近由 Cohere 等机构提交的一项工作中,研究者系统地研究了代码数据对通用大模型性能的影响。

论文链接:https://arxiv.org/abs/2408.10914

设问「预训练中使用的代码数据对代码生成以外的各种下游任务有何影响」。作者对范围广泛的自然语言推理任务、世界知识任务、代码基准和 LLM-as-a-judge 胜率进行了广泛的消融和评估,模型的参数大小从 4.7 亿到 2.8 亿个参数不等。

在各种配置中,我们可以看到存在一致的结果:代码是泛化的关键模块,远远超出了编码任务的范围,并且代码质量的改进对所有任务都有巨大影响。预训练期间投资代码质量和保留代码数据,可以产生积极影响。

这里有几个因素很重要,包括确保代码比例正确、通过包含合成代码和代码相邻数据(例如 commits)来提高代码质量,以及在冷却期间等多个训练阶段利用代码。该研究结果表明,代码是泛化的关键构建块,远远超出了编码任务的范围,代码质量的提高对性能有巨大的影响。

再进一步,作者对广泛的基准进行了广泛的评估,涵盖世界知识任务、自然语言推理和代码生成,以及 LLM 作为评判者的胜率。在对 4.7 亿到 28 亿参数模型进行实验后,以下是详细结果:

1. 代码为非代码任务的性能提供了重大改进。使用代码预训练模型进行初始化可提高自然语言任务的性能。特别是,与纯文本预训练相比,添加代码可使自然语言推理能力相对增加 8.2%,世界知识增加 4.2%,生成胜率提高 6.6%,代码性能提高 12 倍。

2. 代码质量和属性很重要。使用标记样式的编程语言、代码相邻数据集(例如 GitHub commits)和合成生成的代码可提高预训练的性能。特别是,与预训练中的基于 Web 的代码数据相比,在更高质量的合成生成的代码数据集上进行训练可使自然语言推理和代码性能分别提高 9% 和 44%。此外,与不包含代码数据的代码模型初始化相比,包含合成数据的代码模型持续预训练分别使自然语言推理和代码性能相对提高 1.9% 和 41%。

3. 冷却中的代码可进一步改善所有任务。在预训练冷却中包含代码数据,其中高质量数据集被加权,与冷却前的模型相比,自然语言推理性能增加 3.6%,世界知识增加 10.1%,代码性能增加 20%。更重要的是,包含代码的冷却比基线(无冷却的模型)的胜率高出 52.3%,其中胜率比无代码的冷却高出 4.1%。

方法概览

在方法部分,研究者从预训练数据、评估、训练与模型细节三个部分着手进行介绍。下图 1 为高级实验框架。

预训练数据

研究者描述了预训练和冷却(cooldown)数据集的细节。目标是在当前 SOTA 实践的标准下,评估代码在预训练中的作用。因此,他们考虑了由以下两个阶段组成的预训练运行,即持续预训练和冷却。

其中持续预训练是指训练一个从预训练模型初始化而来并在固定 token 预算下训练的模型。冷却是指在训练的最后阶段,提高高质量数据集的权重并对相对较少数量的 token 进行学习率的退火。

关于文本数据集,研究者使用 SlimPajama 预训练语料库作为他们的自然语言文本数据源。

关于代码数据集,为了探索不同属性的代码数据的影响,研究者使用了不同类型的代码源,包括如下:

基于 web 的代码数据,这是主要的代码数据源,包括用于训练 StarCoder 的 Stack 数据集。该数据集包含了爬取自 GitHub 的自由授权的代码数据。研究者使用了质量过滤器,并选定了基于文档数(document count)的前 25 种编程语言。在走完所有过滤步骤后,仅代码和 markup 子集的规模为 139B tokens。

Markdown 数据。研究者单独处理了 mark-up 风格的语言,比如 Markdown、CSS 和 HTML。走完所有过滤步骤后,markup 子集的规模为 180B tokens。

合成代码数据。为了对代码数据集进行消融测试,研究者使用了专门的合成生成代码数据集, 包含已经正式验证过的 Python 编程问题。他们将该数据集作为高质量代码数据源,最终的合成数据集规模为 3.2B tokens。

相邻代码数据。为了探索不同属性的代码数据,研究者还使用了包含 GitHub 提交、jupyter notebooks、StackExchange threads 等辅助数据的代码数据。这类数据的规模为 21.4B tokens。

预训练冷却数据集。冷却包含在预训练最后阶段提高更高质量数据集的权重。对此,研究者选择了包含高质量文本、数学、代码和指令型文本数据集的预训练冷却混合。

评估

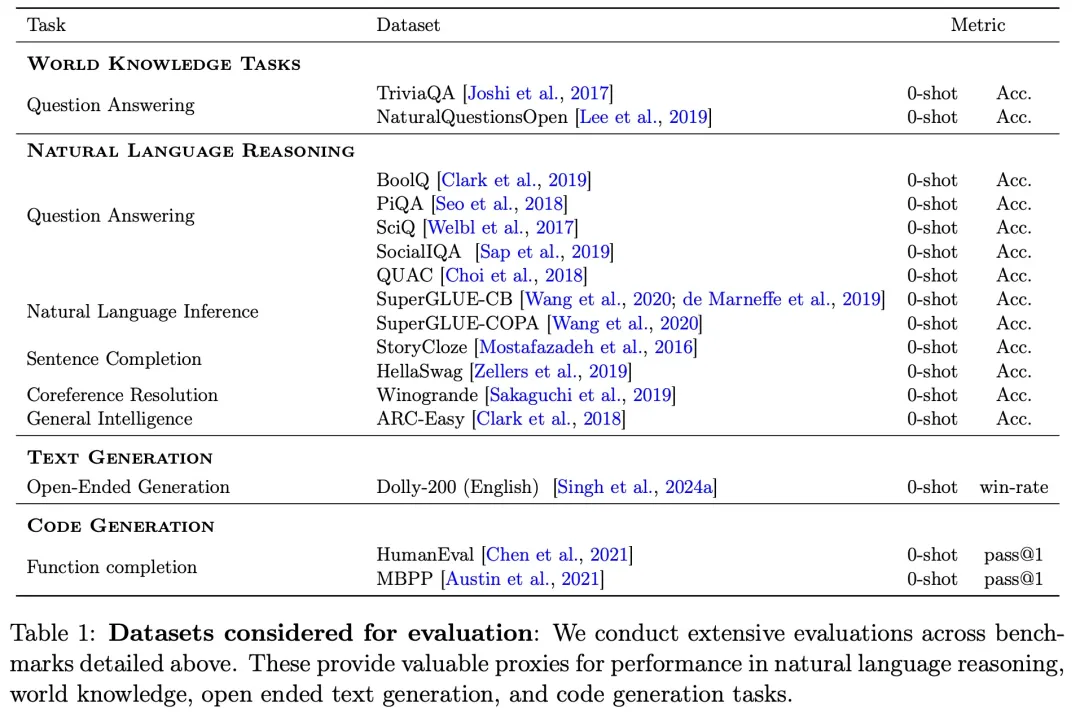

本文的目标是系统地理解代码对通用任务性能的影响,因此使用了一个广泛的评估组件,涵盖了包含代码生成在内的多样下游任务。

为此,研究者在包含 1)世界知识、2)自然语言推理和 3)代码性能的基准上对模型进行了评估。此外,他们还报告了通过 LLM-as-a-judge 评估的胜率(win-rates)。

下表 1 展示了完整的评估组件以及相应的任务、数据集、指标。

研究者对不同规模的模型(从 470M 到 2.8B 参数)展开了性能评估。由于最小规模的模型能力有限,因此为了保证公平比较,他们只比较了所有模型均能达到随机以上性能的基准。

除了特定于任务的判别式性能,研究者评估了使用 LLM-as-a-judge 胜率的生成式性能。

训练与模型细节

如上文所说,对于预训练模型,研究者使用了 470M 到 2.8B 参数的 decoder-only 自回归 Transformer 模型,它们按照标准语言建模目标来训练。

具体来讲,研究者使用了并行注意力层、SwiGLU 激活、没有偏差的密集层和包含 256000 个词汇的字节对编码(BPE)tokenizer。所有模型使用 AdamW 优化器进行预训练,批大小为 512,余弦学习率调度器的预热步为 1325,最大序列长度为 8192。

在基础设施方面,研究者使用 TPU v5e 芯片进行训练和评估。所有模型在训练中使用了 FAX 框架。为了严格进行消融评估,研究者总共预训练了 64 个模型。每次预训练运行使用 200B tokens,470M 参数模型用了 4736 TPU 芯片时,2.8B 参数模型用了 13824 TPU 芯片时。每次冷却运行使用了 40B tokens,470M 参数模型用了 1024 TPU 芯片时。

实验结果

该研究展开了系统的实验,探究了以下几方面的影响:

使用代码预训练模型初始化 LLM

模型规模

预训练数据中代码的不同比例

代码数据的质量和属性

预训练冷却中的代码数据

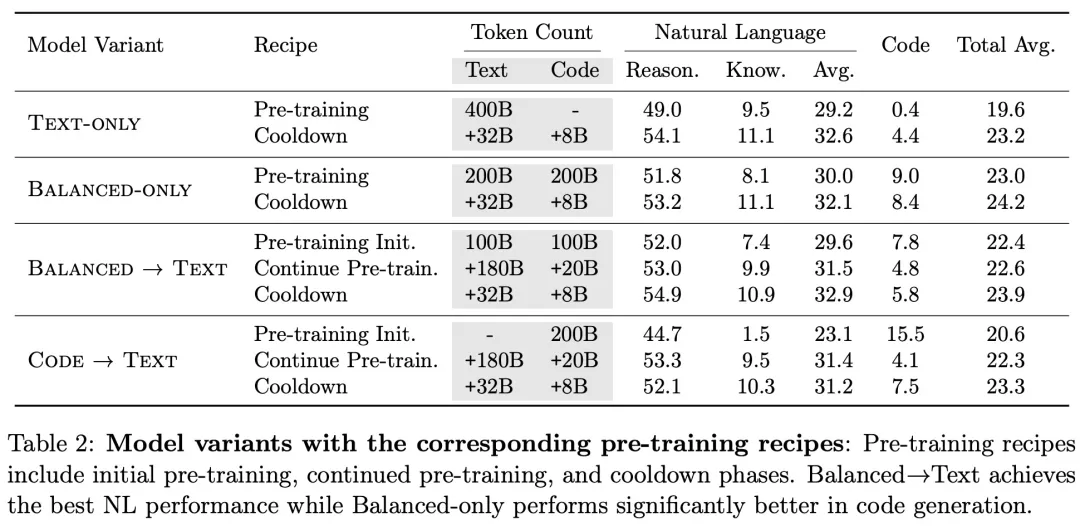

为了探究使用具有大量代码数据的 LM 作为初始化是否可以提高模型性能,该研究针对不同的预训练模型初始化进行了实验。如图 2 所示,使用 100% 代码预训练模型(code→text)进行初始化能让模型在自然语言 (NL) 推理基准上获得最佳性能,紧随其后的是 balanced→text 模型。

为了了解上述结果是否可以迁移到更大的模型,该研究以 470M 模型相同的 token 预算,训练了 2.8B 参数模型。下图显示了 2.8B 模型与 470M 模型的比较结果。

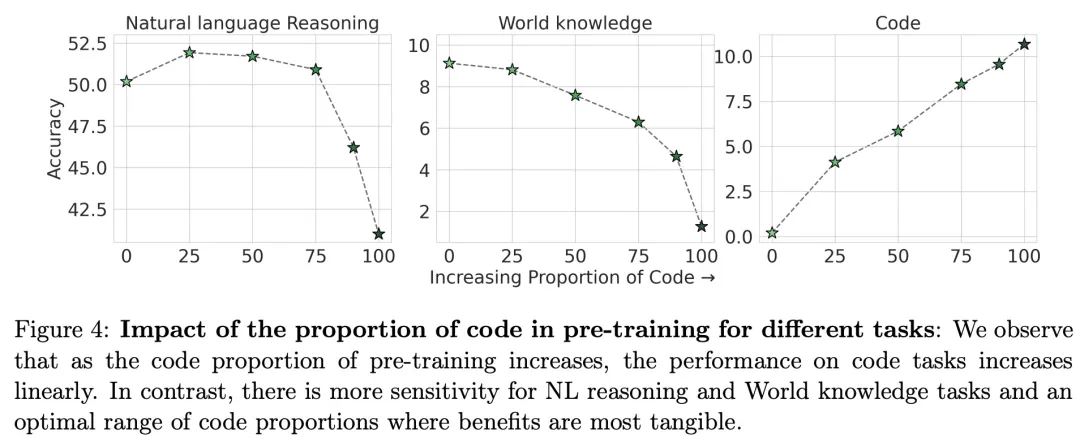

该研究探究了预训练中代码数据比例对不同任务模型性能的影响,观察到随着预训练代码数据比例的增加,代码任务的性能呈线性提高,而对于 NL 推理任务和世界知识任务则存在效益最明显的最佳代码数据比例范围。

如图 5 (a) 所示,在评估代码质量和代码构成的影响方面,该研究观察到,包含不同的代码源和合成代码,都会导致自然语言性能的提高,但是,只有合成生成的代码才能提高代码性能。

如图 5 (b) 所示,在 NL 推理任务和代码任务中,balanced+synth→text 比 balanced→text 分别实现了 2% 和 35% 的相对改进。这进一步证实,即使是一小部分的高质量代码数据,也可以提高代码和非代码任务的性能。

如图 6 所示,该研究发现:在预训练冷却中包含代码数据,模型的NL推理性能增加 3.6%,世界知识性能增加 10.1%,代码性能增加 20%。

如图 7 所示,正如预期的那样,冷却对以胜率衡量的生成性能有重大影响。

采用不同预训练方案的模型的性能比较结果如表 2 所示,Balanced→Text 实现了最佳的 NL 性能,而 Balanced-only 在代码生成方面明显表现更好。

#Seed-ASR

大模型时代的ASR就是不一样!豆包“听力”水平现场评测,方言&小朋友口音直接拿捏!

2024 火山引擎 AI 创新巡展上海站于近日举办,活动展示了豆包大模型在综合评分、语音识别等方面的效果提升,还发布了对话式 AI 实时交互解决方案。豆包大模型团队成果 Seed-ASR ,提供了语音识别能力支持。

Seed-ASR 是一款 ASR(自动语音识别)成果。它能准确转录各种语音信号,识别不同语言、方言、口音。对于人名、生词,Seed-ASR 也能结合文本语音等上下文,实现更准确转录。该成果目前已被集成进豆包 APP 、火山引擎相关服务模块中。

本文介绍了 Seed-ASR 技术亮点 —— 高精度识别、大容量模型、支持多种语言、上下文感知、分阶段训练方法。相关同学还分享了立项动机、研发历程及总结思考,展望了大模型 Scaling Laws 对 ASR 技术的推动和影响。

8 月 21 日,2024 火山引擎 AI 创新巡展﹒上海站带来了豆包大模型最新进展。

公开及内部测评集显示,最新版本豆包大模型对比 5 月 15 日发布版本综合能力提升 20.3% ,其中,角色扮演能力提升 38.3% ,语言理解能力提升 33.3% ,数学能力提升 13.5% 。根据 QuestMobile 报告,基于豆包大模型打造的豆包 APP 月活用户数在上半年已达 2752 万,为同类 APP 第一,是第二名的 2.43 倍。

语音能力是本次活动的发布重点。其中,语音识别和语音合成模型进一步升级,对话式 AI 实时交互功能也最新上线。

具体来说,豆包﹒语音合成模型升级了流式语音合成能力,能够实时响应、精准断句,支持“边想边说”。豆包﹒语音识别模型,可基于更强上下文感知能力,推理得出更准确的识别结果,并支持一个模型识别普通话和粤语、上海话、四川话、西安话、闽南语等多种中国方言。

基于语音合成、语音识别等成果,火山引擎整合了云服务的实时音视频技术,使 AI 语音交互能像人类说话一样打断和插话,端到端延时可低至 1 秒以内。即使在弱网环境,丢包 80% 依然可保持清晰流畅。

上述发布中,语音合成能力依托于 Seed-TTS 。而语音识别能力依托于豆包大模型团队另一成果—— Seed-ASR 。

Seed-ASR 能力展示

Seed-ASR 基于大语言模型,可将各种语音转化为文本信息,使机器能“听懂”用户说话,“聪明”地识别各类信息。

通过下面几个 Demo ,可感知其能力。

(1)基于人名的上下文推理

给到历史人物介绍,模型能从语音中识别相关信息。

(2)基于专业名词的上下文推理

模型能根据用户对字幕的编辑历史,关联并自动识别后续语音中的专业名词——比如滑雪中的“立刃”、“雪板”、“搓雪”等表达。

(3)方言识别

即便是 5 种方言夹杂的语音聊天,模型同样能够识别并展示出较为准确的结果。如果将聊天相关信息作为提示词,事先提供给模型,识别效果则会进一步提升。

Seed-ASR 已在豆包 APP 中应用,被网友用在英语会话、虚拟聊天伴侣、复刻亲友声音等多个场景。面向更多企业客户,Seed-ASR 依托火山引擎, 在语音交互、内容审核、会议访谈转写、音视频字幕等场景也有落地。

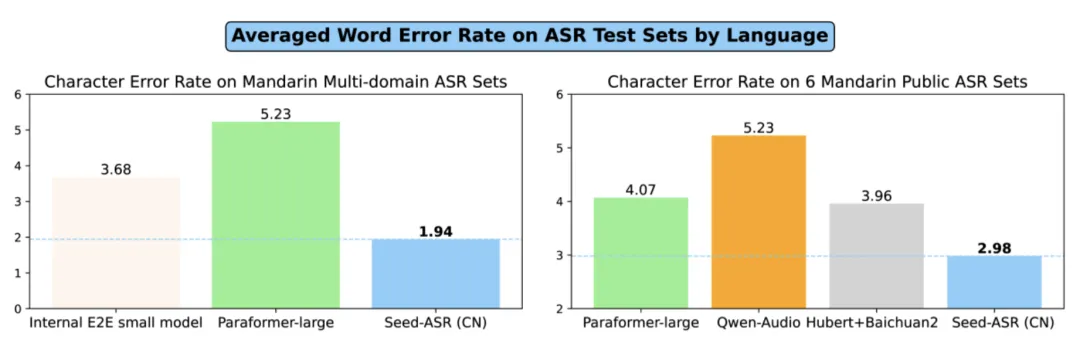

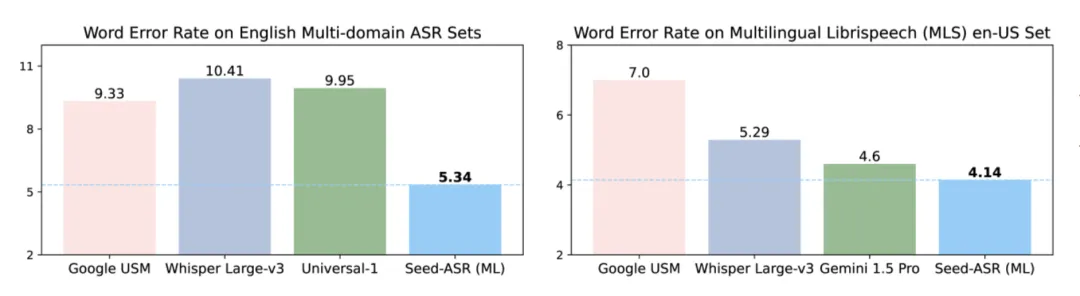

对比此前发布的大型 ASR 模型,Seed-ASR 在中英文公开测试集上,单词错误率(面向中文以单个字计算)降低 10%-40% ,展现出一定优势。

有网友在试用后表示,这个模型的表现确实超出预期,家里小朋友说话也能听懂。

技术详情及更多 Demo 展示,可通过下方链接了解:

- 论文标题:Seed-ASR: Understanding Diverse Speech and Contexts with LLM-based Speech Recognition

- 论文链接:https://team.doubao.com/zh/publication/seed-asr-understanding-diverse-speech-and-contexts-with-llm-based-speech-recognition?view_from=research

- Demo展示:https://bytedancespeech.github.io/seedasr_tech_report/

Seed-ASR 的立项始于 2023 年初,随着 ChatGPT 横空出世,Scaling Laws 成为显学,各领域研究者都意识到,参数量和数据量的大幅增长使得模型同时拥有强大的理解和生成能力。

此前,语音一直与 NLP 结合紧密,语音与文字的相互转换在人类大脑内本就是一项“不假思索便执行”的任务,对机器也类似。

基于上述背景,研究团队希望让 ASR 模型能够利用 LLM 丰富的知识,整体提升 ASR 识别结果的准确性,由此,开启了 Seed-ASR 的相关工作。

从技术角度看,Seed-ASR 核心亮点在于两方面:

其一,基于大模型,为 ASR 引入了上下文理解能力。

Seed-ASR 有 LLM 加持,可利用丰富的上下文理解语音信号。具体实现上,通过构建有效且多样的训练数据,团队激发了模型的语音模态,使得模型可以结合文本,捕捉语音中的相关信息,再在推理中,设计一些解码策略,以缓解上下文引入造成的幻觉及误转写问题。

上述工作使得与 AI 对话时,模型能够理解特定术语,也能在会议纪要中,“听懂”新加入参会者的人名。且沟通越多,上下文信息越多,后续转录的正确率就越高。

其二, All-in-One 理念带来强大的泛化效果。

传统 ASR 属于小模型,每个领域需要特定模型解决细分问题,另有与之配套的融合方法,脱离特定场景,表现便会下降。Seed-ASR 基于 All-in-One 思路,强大的泛化性使它能被用于各类场景,更为简洁。

除却上述两方面,Seed-ASR 还拥有识别准确率高、支持多种语言等特性,其中 CN 版支持 13 种中文方言,多语言版支持英语和其他 7 种语言,同时正在拓展支持 40 种语言。

这些能力中,高精度识别与多种语言支持能力源于 Scaling Laws 理念。模型容量扩大,更多样更广泛数据的引入,提供了模型更好的泛化性和能力涌现。正如 GPT 系列每一代的进化一样。此外,分阶段的训练方式既赋予模型高精度识别能力,也提供模型利用上下文推理的能力。

训练方法

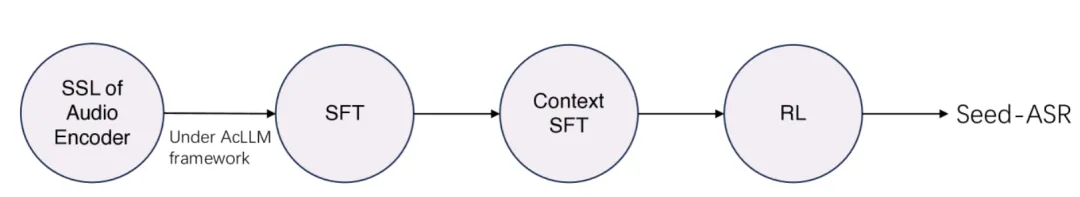

Seed-ASR 的开发加入了分阶段训练过程,这种基于音频条件 LLM 框架被称为 AcLLM 。

整个流程包括:编码器的自监督学习(SSL)、监督微调(SFT)、上下文微调(Context SFT)、强化学习(RL)。其中,预训练的大量文本数据训练使模型存储大量知识,在后续微调中,LLM 在更高质量的任务导向数据上进一步微调,增强了上下文推理和理解任务指令的能力。RLHF 阶段中,LLM 得以与人类偏好进一步保持一致。

注:Seed-ASR 训练过程

下面具体拆解各个阶段:

- 音频编码器的自监督学习

该步骤使编码器能从语音中捕获丰富信息,参考了基于 BERT 的语音 SSL 框架,团队开发了一种基于一致性的模型,可在音频信号中可捕捉并存储语音信号中的全局及局部信息。团队将训练后的音频编码成称为“ LUISE ”,它是大规模无监督迭代语音编码器(Large-scale Unsupervised Iterative Speech Encoder)的英文缩写。

继承 BERT 的理念,LUISE 采用掩码语言预测的学习范式,即:先将波形提取的特征序列输入到 Token 化模块,得到每个帧的离散标签,再使用交叉熵准则对 LUISE 进行训练,损失函数仅对掩码帧进行计算,训练完成后,移除 softmax 层,用 LUISE 的 Encoder 部分进行后续有监督微调。

下面是该编码器的训练过程:

团队还利用了迭代固定分词器方法,从连续数据中提取离散标签,重复迭代过程,逐步优化了分词结果。

在选择中间层过程中,团队冻结了第一次迭代训练的编码器参数,添加映射层并利用 CTC(Connectionist Temporal Classification)算法进行贪婪搜索,从而得到词错误率结果(WER)。

下图展示了针对 LUISE 语义表示最优化层的探索实验结果,对于 20 亿参数的LUISE,第 25 层(总共 30 层)的输出展示了最佳语义表示,并在后续迭代中,用于生成离散标签。

- SFT

大规模纯语音数据训练已让 LUISE 具备强大的语音表征能力,能够以 40ms 帧率输出丰富语音和语义信息的连续表征。

为了让模型能理解语音中对应文本内容,需要将编码表征的语义信息映射到 LLM 语义空间去。团队为此采用 2 种方法:

在模型结构上,引入一个转换器模块将音频编码器 LUISE 与 LLM 连接起来。当提供上下文时,模型会识别相关语音信息,结合上下文,提供准确文本,否则将语音直接转录为文本。

训练方式上,团队采用了“可学习编码器 + 可学习转化器+固定 LLM ”策略,这样可保持 LLM 丰富的语义知识和推理能力,通过编码器和转换器参数训练,使得语音中的语义信息与 LLM 的语义空间对齐。

- Context SFT

Context SFT ,不止关乎语音对话中的背景信息理解,对于语音识别中的模糊信息,比如口音、发音不清、同音异义词、生僻词等理解也有很大意义。为此,团队引入了上下文感知训练以及联合波束搜索方法来增强相关能力。

首先团队使用自研的语言模型来生成语音转录有关的上下文,并构建了“上下文,语音,文本”三种元素的数据集,将其与一定比例的一般 ASR 数据混合训练,并在训练中将上下文和语音表征输入 LLM 中。

为了解决原生波束搜索的幻觉问题,团队还提出一种联合波束搜索的解码策略以缓解幻觉,找到最优得分 P(y|x,c) ,其中,y 表示预测的假设,x 是语音信息,c 是给定上下文信息,超参数 α 用于平衡解码过程中语音信息和上下文信息的权重,并且,团队还引入了一种修剪策略,过滤掉语义方面不合理的候选词。

下图展示了“有上下文”和“无上下文”转录语音的示例情况,从第二行输出结果可见,有上下文情况下,模型输出与此前出现的单词“ ceaseth ” 、 “ sufficeth ”进行了对齐。

- RL

强化学习(RL)的引入,使模型在序列建模任务中学习到相对最优的决策策略。通过构建基于 ASR 指标的奖励函数,团队将其引入 Seed-ASR 中。不仅于此,团队还将加权单词错误率(WER)作为额外奖励函数,这样可使模型更多关注关键词的错误问题。

具体到训练过程中,团队使用前一阶段训练的上下文 SFT 初始化模型参数,利用高质量数据进行数千小时的强化学习训练,为保证上下文感知能力,训练数据还包括一定比例的“上下文,语音,文本”三种元素数据。

在消融研究中,将加权 WER 作为奖励函数的模型(最后 2 行)在 3 个评估集的表现优异,最后一行训练进一步加入三种元素的数据集,其上下文能力表现得以保持。

下图展示了 Seed-ASR 与其他同类模型的平均单词错误率,在中文领域,Seed-ASR 对比主流模型无论是普通话在多领域的识别错误率,还是 6 个普通话测试集上,其平均错误率都低于其他模型。

面向英文表现也很好,无论面向多领域英语识别评测,还是 MLS 公共评测集,其表现同样突出。

除却客观评价外,团队还引入主观评价,选择 3 名转录员进行人工识别,将文本与 Seed-ASR 进行对比。

结果显示,在语音搜索和语音助手领域,两者旗鼓相当,而在直播、视频、会议场景,Seed-ASR( CN 版本)表现出比人类更好的主观可理解性。

在研究测试过程中,团队还观察到,更大模型可以通过增加训练数据量级,不断降低损失值。

据团队所了解,目前尚无基于 LLM 框架的音频编码器 Scaling Laws 的研究,团队在训练阶段选取了 5 个量级的模型,通过 770 万小时无监督多领域纯语音数据训练,观察 Loss 值、单词错误率(WER)。

从下图能看出,随着模型规模提升(在横轴取 2 为底的对数值),交叉熵预训练 Loss 值与单词错误率均会降低,且预训练 Loss 值与单词错误率呈正相关关系。

为探索长语音数据在模型表现上的影响,团队还构建了一系列数据集,分别直接用长语音数据进行微调,对照组使用切分后的短语音微调,并且比对了其他 ASR 模型。

结果显示,长语音 SFT 效果更佳。团队认为,分段操作可能导致了边界信息丢失,降低识别准确率,且影响了全局上下文的一致性,进而降低了识别结果的准确性和一致性。

林同学是该项目的主要参与者之一,展望 Seed-ASR 将释放的潜力,他认为,语音内容理解作为交互入口,准确率的进一步提升将推动人机交互更为“智能化”。ASR 对于小众语言、口音、发音的更强兼容性,可促使技术进一步普惠不同文化背景或沟通障碍的小众群体。

对于技术发展的展望,林同学颇为乐观:“目前 Scaling Laws 的潜力尚未被穷尽,我们在数据和模型结构的升级工作仍收益可观,我们将继续探索”。

“务实”、“重视技术”是团队的底色

事实上,Seed-ASR 早已被应用于豆包 APP 实际场景中,从立项到上线,只历经不到半年时间。此后,模型历经不断调优,性能继续提升。

“项目推进效率非常高”,这是让林同学印象最深的事。

据他回忆,快速推进一方面得益于技术路线选取的前瞻性。Seed-ASR 的框架连续性很好,一开始选择了连续语音表示的方向,后续也没有切换大方向,使得团队少走“弯路”,还能做进一步深入研究和优化。

另一方面也源于高效的跨团队协同。

这当中,算法同学发起前期验证和技术方向规划,当模型展现出对应能力,更多同学加入进来。其中,工程同学提供了训练稳定性和推理加速方面的支持,数据同学快速支持了要素生产,评测同学构建了一套六边形的评价维度。Leader 们会身居一线,紧密跟踪前沿工作和技术推进,与各职能同学紧密沟通技术细节,以更好协调资源和指导项目推进。在大家紧密配合下,模型得以快速迭代。

“所有人都一心扑在实际效果优化上,反而在公开集上没来得及测试,导致技术报告迟迟没有公开”,林同学补充道。

最后,团队氛围也是促成项目高效推进的因素之一。

“我们团队的关键词,一个是务实,另一个是非常重视技术”,林同学说道,而正是这种氛围,促使大家更加自驱,更加积极去推进项目。

“每个同学都有机会做适合自己的事情,又能收获成就感。当看到技术实际落地,释放价值,也给同行提供新的视角,这给了我们动力把技术做得更扎实”,他认真地补充道。

截至目前,豆包大模型团队语音方向已发布 Seed-TTS 、Seed-ASR 等多项技术成果,团队希望吸引自驱、务实、有志于“用科技改变世界”的顶尖人才加入,点击阅读原文了解更多信息。

注:本文受访同学采用化名。

#SuperClue-V

大模型从认知空间走向物理世界的发展路径

近期,腾讯混元推出了基于 MoE 架构的多模态理解大模型。该模型在架构、训练方法和数据处理方面进行了创新和深度优化,显著提升了其性能,并能支持任意长宽比及最高 7K 分辨率图片的理解。与大部分多模态模型主要在开源基准测试中进行调优不同,腾讯混元多模态模型更加注重模型的通用性、实用性和可靠性,具备丰富的多模态场景理解能力。在近期发布的中文多模态大模型 SuperCLUE-V 基准评测中(2024 年 8 月),腾讯混元斩获国内排名第一,超越了多个主流闭源模型。

方法介绍:MoE 架构

腾讯混元语言大模型,在国内率先采用混合专家模型 (MoE) 架构,模型总体性能相比上一代提升 50%,部分中文能力已追平 GPT-4o,在 “时新” 问题的回答表现上,数学、推理等能力上均有较大提升。早在今年年初,腾讯混元就将该模型应用于腾讯元宝。

腾讯混元认为,能够解决海量通用任务的 MoE 架构,也是多模态理解场景的最佳选择。MoE 能够更好地兼容更多模态和任务,确保不同模态和任务之间是互相促进而非竞争的关系。

依托腾讯混元语言大模型的能力,腾讯混元推出了基于MoE架构的多模态理解大模型,在架构、训练方法和数据处理方面进行了创新和深度优化,性能得到显著提升。这也是国内首个基于MoE架构的多模态大模型。

腾讯混元多模态模型架构示意图

简单可规模化

除了采用 MoE 架构外,腾讯混元多模态模型的设计还遵循简单、合理、可规模化的原则:

- 支持原生任意分辨率:与业界主流的固定分辨率或切子图方法相比,腾讯混元多模态模型能够处理原生任意分辨率的图片,实现了首个支持超过 7K 分辨率和任意长宽比(例如 16:1,见下文例子)图片理解的多模态模型。

- 采用简单的 MLP 适配器:相较于此前主流的 Q-former 适配器,MLP 适配器在信息传递过程中损失更小。

这种力求简单的设计,使得模型和数据更容易扩展和规模化。

SuperClue-V 榜单国内排名第一

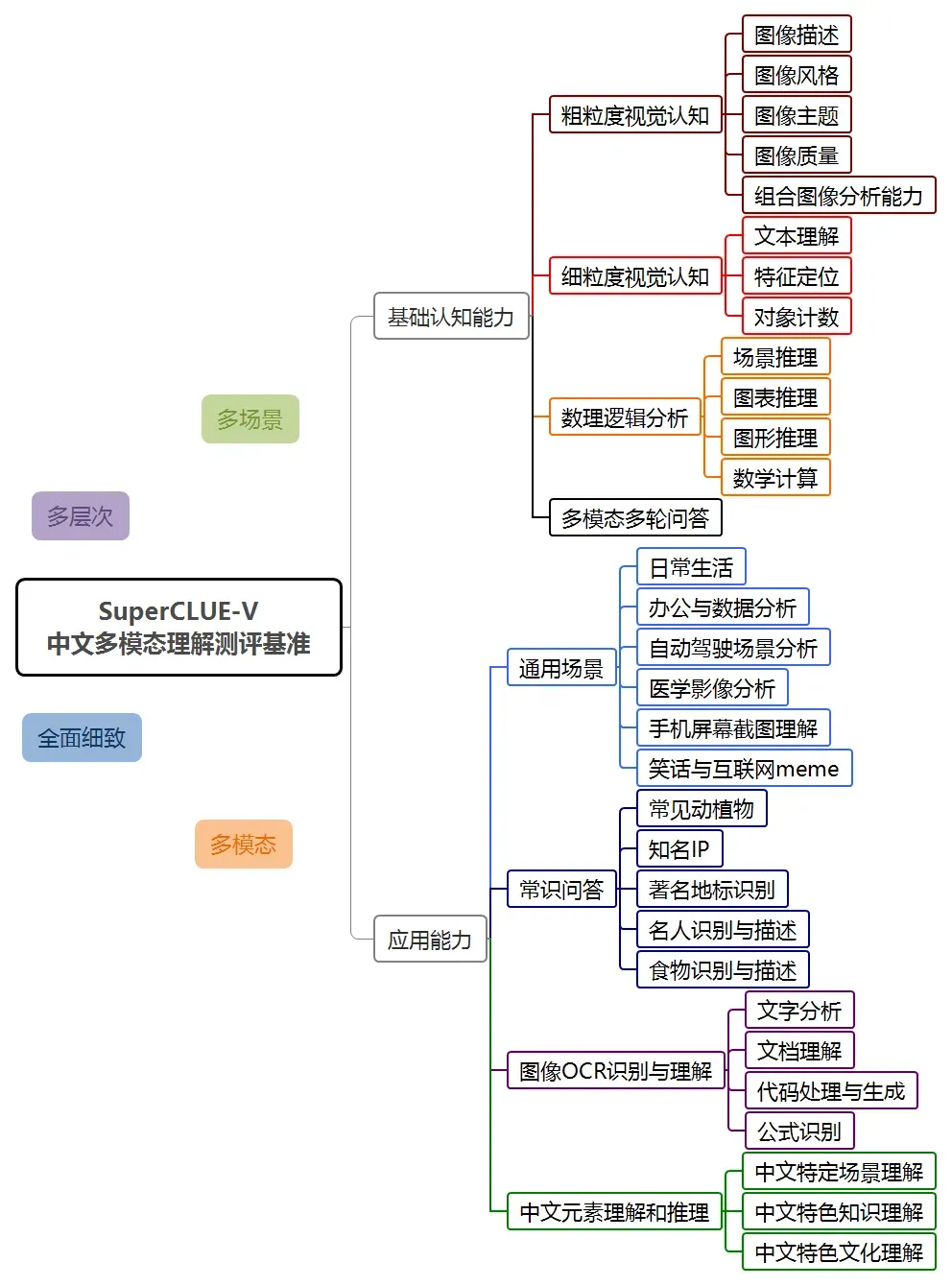

2024 年 8 月,SuperCLUE 首次发布了多模态理解评测榜单 ——SuperClue-V。

SuperCLUE-V 基准包括基础能力和应用能力两个大方向,以开放式问题形式对多模态大模型进行评估,包含 8 个一级维度 30 个二级维度。

在此次评测中,混元多模态理解系统 hunyuan-vision 取得了 71.95 得分,仅次于 GPT-4o。在多模态应用方面,hunyuan-vision 领先于 Claude3.5-Sonnet 和 Gemini-1.5-Pro。

值得注意的是,业界此前的多模态评测多集中于英文能力,评测题目类型大多为选择题或判断题。而 SuperCLUE-V 评测更侧重于中文能力评测,关注用户的真实问题。此外,由于是首次发布,尚未出现过拟合现象。

腾讯混元图生文大模型在通用场景、图像 OCR 识别理解和中文元素理解推理等多个维度上显示了不错的性能,也体现了模型在未来应用上的潜力。

面向通用应用场景

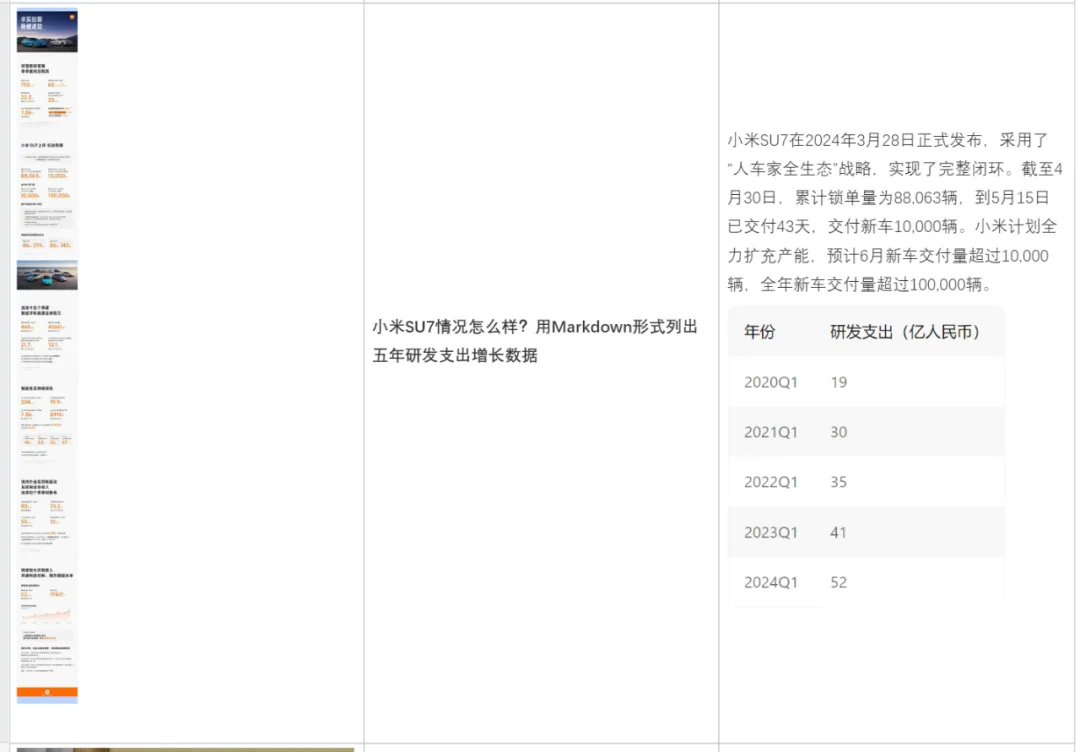

混元多模态理解模型面向通用场景和海量应用进行了优化,积累了数千万相关问答语料,涵盖图片基础理解、内容创作、推理分析、知识问答、OCR 文档解析、学科答题等众多场景。以下是一些典型应用实例。

以下是更多典型示例:

将图片转换成文本表格:

解释一段代码:

分析账单:

描述图片内容:

做数学题:

根据图片内容,进行分析:

帮你写文案:

目前腾讯混元多模态理解大模型已在 AI 助手产品腾讯元宝上线,并通过腾讯云面向企业及个人开发者开放。

腾讯元宝地址:https://yuanbao.tencent.com/chat

https://yuanbao.tencent.com/chat

#Automated Design of Agentic Systems

用AI自动设计智能体,数学提分25.9%,远超手工设计

基于 ADAS 所发现的智能体的性能大大优于最先进的手工设计的基线。

基础模型 (FM) 如 GPT 和 Claude ,正在成为通用智能体的强有力支持,被越来越多的用于多种推理和规划任务。

然而,在解决问题时,需要的智能体通常是具有多个组件的复合智能体系统,而不是单片模型查询 。此外,为了使智能体能够解决复杂的现实世界任务,它们通常需要访问外部工具,例如搜索引擎、代码执行和数据库查询。

因此,人们提出了许多有效的智能体系统构建块,例如思维链规划和推理、记忆结构、工具使用和自我反思。尽管这些智能体已经在各种应用中取得了显著的成功,但开发这些构建块并将它们组合成复杂的智能体系统通常需要特定领域的手动调整以及研究人员和工程师的大量努力。

然而,机器学习的历史告诉我们,手工设计的解决方案最终会被模型学习到的解决方案所取代。

本文,来自不列颠哥伦比亚大学、非营利人工智能研究机构 Vector Institute 等的研究者制定了一个新的研究领域,即智能体系统的自动化设计(ADAS,Automated Design of Agentic Systems),并提出了一种简单但有效的 ADAS 算法,名为元智能体搜索(Meta Agent Search),以证明智能体可以通过代码编程来发明新颖而强大的智能体设计。

该研究旨在自动创建强大的智能体系统设计,包括开发新的构建块并以新的方式组合它们。

实验表明,基于 ADAS 所发现的智能体的性能大大优于最先进的手工设计的基线。例如,本文设计的智能体在 DROP 的阅读理解任务中将 F1 分数提高了 13.6/100(与基线比),在 MGSM 的数学任务中将准确率提高了 14.4%。此外,在跨域迁移后,它们在 GSM8K 和 GSM-Hard 数学任务上的准确率分别比基线提高了 25.9% 和 13.2%。

与手工设计的解决方案相比,本文算法表现出色,这说明 ADAS 在自动化智能体系统设计方面的潜力。此外,实验表明,所发现的智能体不仅在跨相似领域迁移时表现良好,而且在跨不同领域迁移时也表现出色,例如从数学到阅读理解。

- 论文地址:https://arxiv.org/pdf/2408.08435

- 项目地址:https://github.com/ShengranHu/ADAS

- 论文主页:https://www.shengranhu.com/ADAS/

- 论文标题:Automated Design of Agentic Systems

新研究领域:智能体系统的自动化设计(ADAS)

该研究提出了一个新的研究领域 —— 智能体系统的自动化设计(Automated Design of Agentic Systems,ADAS),并描述了 ADAS 算法的三个关键组成部分——搜索空间、搜索算法、评估函数。ADAS 使用搜索算法跨搜索空间来发现智能体系统。

搜索空间:搜索空间定义了哪些智能体系统可以在 ADAS 中被表征并被发现。例如,像 PromptBreeder (Fernando et al., 2024) 这样的工作仅改变智能体的文本提示,而其他组件(例如控制流)保持不变。因此,在搜索空间中,无法表征具有与预定义控制流不同控制流的智能体。

搜索算法:搜索算法定义了 ADAS 算法如何探索搜索空间。由于搜索空间通常非常大甚至无界,因此应考虑探索与利用的权衡(Sutton & Barto,2018)。理想情况下,该算法既可以快速发现高性能智能体系统,又可以避免陷入局部最优。现有方法包括使用强化学习(Zhuge et al., 2024)或迭代生成新解决方案的 FM(Fernando et al., 2024)作为搜索算法。

评估函数:根据 ADAS 算法的应用,可能需要考虑不同的优化目标,例如智能体的性能、成本、延迟或安全性。评估函数定义如何评估候选智能体的这些指标。例如,为了评估智能体在未见过的数据上的表现,一种简单的方法是计算任务验证数据的准确率。

该研究提出的简单但有效的 ADAS 算法——元智能体搜索的核心概念是指示元智能体迭代地创建有趣的新智能体,评估它们,将它们添加到智能体存储库中,并使用此存储库帮助元智能体在后续迭代中创建更有趣的新智能体。与现有的利用人类兴趣概念的开放式算法类似,该研究鼓励元智能体探索有趣的、有价值的智能体。

元智能体搜索的核心思想是采用 FM 作为搜索算法,基于不断增长的智能体存储库来迭代编程有趣的新智能体。该研究为元智能体定义了一个简单的框架(100 行代码以内),为其提供了一组基本功能,例如查询 FM 或格式化提示。

因此,元智能体只需要编写一个「前向」函数来定义一个新的智能体系统,类似于 FunSearch 中的做法(Romera-Paredes et al., 2024)。该函数接收任务信息并输出智能体对任务的响应。

如图 1 所示,元智能体搜索的核心思想是让元智能体在代码中迭代地编程新的智能体。下面显示了元智能体程序新智能体程序的主要提示,其中提示中的变量高亮显示。

实验

所有实验结果表明本文发现的智能体大大优于基线最先进的手工设计的智能体。值得注意的是,该研究发现的智能体在 DROP 阅读理解任务上比基线提高了 13.6/100(F1 分数),在 MGSM 数学任务上比基线提高了 14.4%(准确率)。此外,研究者发现的智能体在从 GPT-3.5 迁移到 GPT-4 后,在 ARC 任务上的表现比基线提高了 14%(准确率),在从 MGSM 数学任务迁移到 GSM8K 和 GSM-Hard 中的 held-out 数学任务后,准确率分别提高了 25.9% 和 13.2%。

案例研究:ARC 挑战

如图 3a 所示,元智能体搜索可以有效且逐步地发现性能优于最新手工设计的智能体。文本框中突出显示了重要的突破。

此外,图 3b 显示了发现最好的智能体,其中采用了复杂的反馈机制来更有效地细化答案。仔细观察搜索进度就会发现,这种复杂的反馈机制并不是突然出现的。

推理和问题 - 解决域

跨多个域的结果表明,元智能体搜索可以发现表现优于 SOTA 手工设计的智能体(表 1)。

泛化性以及可迁移性

研究者进一步展示了所发现智能体的可迁移性和可泛化性。

如表 2 所示,研究者观察到搜索到的智能体(searched agent)始终优于手工设计的智能体,并且差距很大。值得注意的是,研究者发现 Anthropic 最强大的模型 Claude-Sonnet 在所有测试模型中表现最佳,使基于该模型的智能体在 ARC 上实现了近 50% 的准确率。

如表 3 所示,研究者观察到元智能体搜索的性能与基线相比具有类似的优势。值得注意的是,与基线相比,本文的智能体在 GSM8K 和 GSM-Hard 上的准确率分别提高了 25.9% 和 13.2%。

更令人惊讶的是,研究者观察到在数学领域发现的智能体可以迁移到到非数学领域(表 4)。 开发板商城 天皓智联 TB上有视觉设备哦 支持AI相关~ 大模型相关也可用whaosoft aiot

1134

1134

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?