1.1 AI : 从模型到算力、应用,进入全面繁荣时代

ChatGPT : 强人工智能时代的里程碑。

-

2022年11月,OpenAI公司推出大型语言对话模型ChatGPT,发布仅短短5天,注册用 户数就超过100万。

-

2023年1月末,ChatGPT的月活用户已突破1亿,一度成为史上增长最快的消费者应用。

-

ChatGPT具有自 然语言处理能力强、上下文理解能力强、多轮对话能力强等特征,被视为强人工智能时代的里程碑。

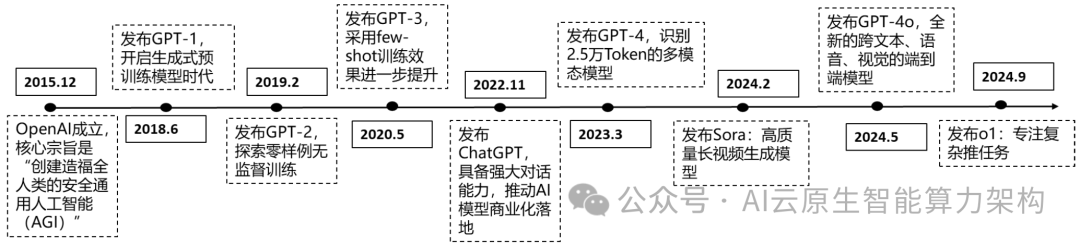

图12:GPT系列模型技术迅速演进

1.1.1、 模型端:Openai有望开启AGI时代,国内外科技厂商快速跟进

-

从GPT-4到GPT-4o再到o1-preview,GPT快速迭代。

-

继 ChatGPT 后,OpenAI 于2023 年 3 月发布了 GPT-4 。

-

它是GPT系列模 型的重要升级,首次将输入模态从单一文本扩展到图文双模态。

-

OpenAI对GPT-4系列模型进行了重要技术升级,发布了GPT- 4V(2023年9月)和GPT-4 Turbo(2023年11月),这些升级显著增强了模型的视觉能力和安全性。

-

2024年5月14日,OpenAI 春季发布会发布了新型旗舰模型“GPT-4o”。

-

与 GPT-4 Turbo 相比,GPT-4o 速度提高了 2 倍,价格减半,限制速率提高了 5 倍。

-

9月13日,OpenAI官宣发布o1-preview,其全新推理模型系列的首个预览版。

-

新模型专注于复杂任务推理,能在科学、 编程和数学等领域解决比以往模型更难的问题,使用速度比GPT-4o慢,价格也更高。

-

同时,OpenAI发布了小尺寸经济版本 o1-mini。

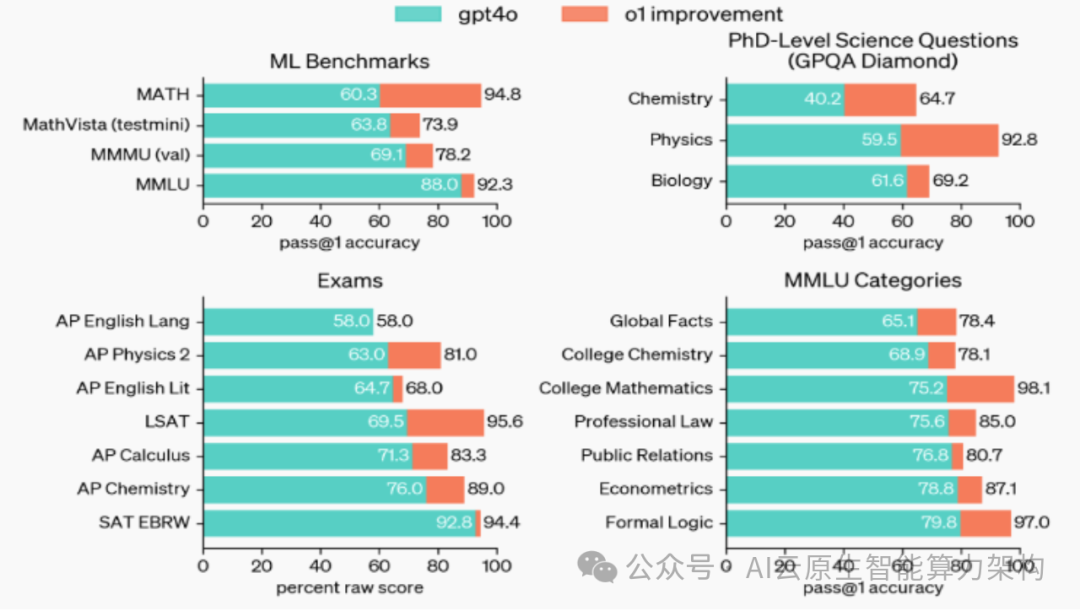

图13:o1在具有挑战性的推理基准测试上大大超越了GPT-4o

图14:o1在很多基准测试中大幅提升GPT-4o的表现

1.1.1、 模型端:Openai有望开启AGI时代,国 内外科技厂商快速跟进

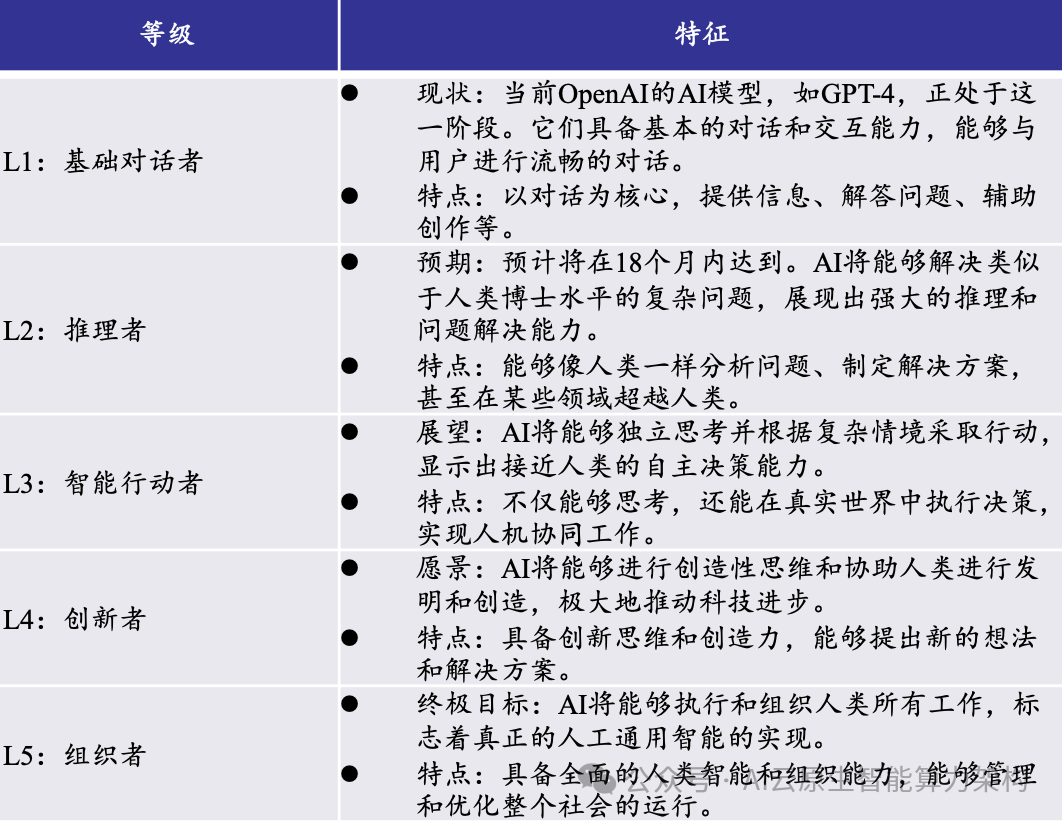

OpenAI正在努力从对话式AI向AGI迈进。

2024年7月,OpenAI公布全新AGI路线图, OpenAI将AI划分为5个等级,自称其AI模型正 处于L1,但很快就会达到L2(推理者)。

而根 据其预测,五级AGI最快将在2027年实现。

表2:OpenAI公布全新AGI路线图

1.1.1、 模型端:Openai有望开启AGI时代,国内 外科技厂商快速跟进

此外,Claude、Gemini、Llama等大模型也在迭代。

Claude :

-

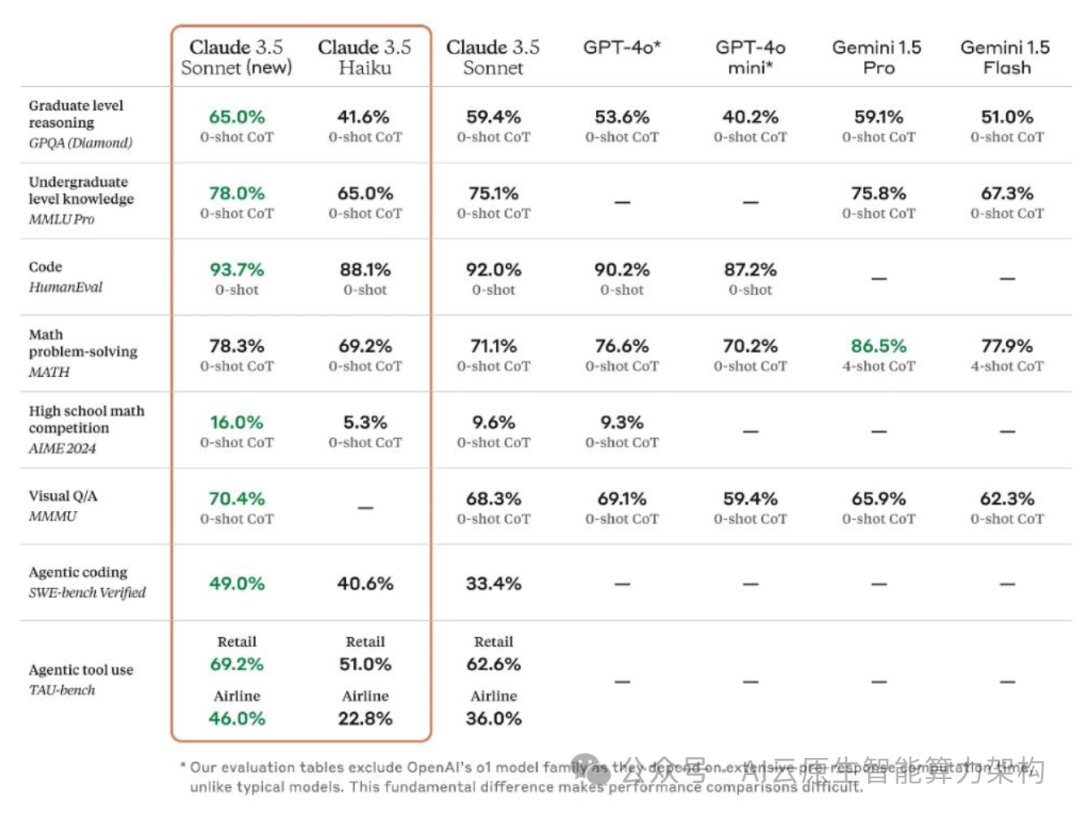

2024年3月4日,Anthropic公司推出 了Claude 3系列,包括Opus、Sonnet和Haiku三个版 本,每个版本都针对不同的应用场景和需求进行了 优化。

-

6月21日,Anthropic发布了Claude 3.5 Sonnet, 进一步提升了模型的性能和能力。

-

10月22日, Anthropic发布了两个新模型:升级版的Claude 3.5 Sonnet和全新的Claude 3.5 Haiku。

-

升级版的Claude 3.5 Sonnet在保持原有价格和速度的基础上,实现 了全面性能提升,尤其在编码领域取得了显著进步。

-

此次发布最引人注目的是Claude 3.5 Sonnet引入了 一项突破性的新功能:计算机使用能力(Computer Use),使Claude能够像人类一样通过观看屏幕、 移动光标、点击按钮和输入文本来操作计算机。

图15:升级版Claude 3.5 Sonnet实现了全面性能提升

1.1.1、 模型端:Openai有望开启AGI时代,国内外科技厂商快 速跟进

Gemini:

-

谷歌的Gemini是一款由Google DeepMind于2023 年12月6日发布的人工智能多模态大模型。

-

2024年2月,Gemini 1.5发布,不仅性能全面升级,更在长上下文处理能力上实现重 大突破,能够理解并运用训练数据中未包含的新语言,其最高配 置版本Gemini 1.5 Pro支持高达1,000,000 token的超长上下文,成 为谷歌史上最强MoE大模型。

-

10月,谷歌宣布重大组织调整, Gemini团队并入进DeepMind。

-

11月1日消息,谷歌首席执行官桑 达尔.皮查伊在最新季度财报电话会议上发言,宣布Gemini API 的使用量在过去六个月中飙升了14倍。

-

这一增长反映了谷歌在其 核心业务如 Google Maps 和 Google Search 中整合 Gemini API 的成果。此外,独立的Gemini应用和嵌入的Android Assistant也 显示出了强劲的用户增长。

Llama:

-

2024年9月,Meta正式推出了 Llama 3.2 AI 模型, 其特点是开放和可定制,其中包括适合边缘和移动设备的中小型 视觉 LLMs (11B 和 90B),以及轻量级纯文本模型(1B 和 3B),此外提供预训练和指令微调(instruction-tuned)版本。

-

同 时,Meta于10月24日发布了这两个模型的量化版本,量化后的模 型大小平均减少了 56%,RAM 使用量平均减少了 41%,模型速 度提高了 2 至 4 倍,同时降低了功耗,使这些模型能够部署到更 多移动设备上。

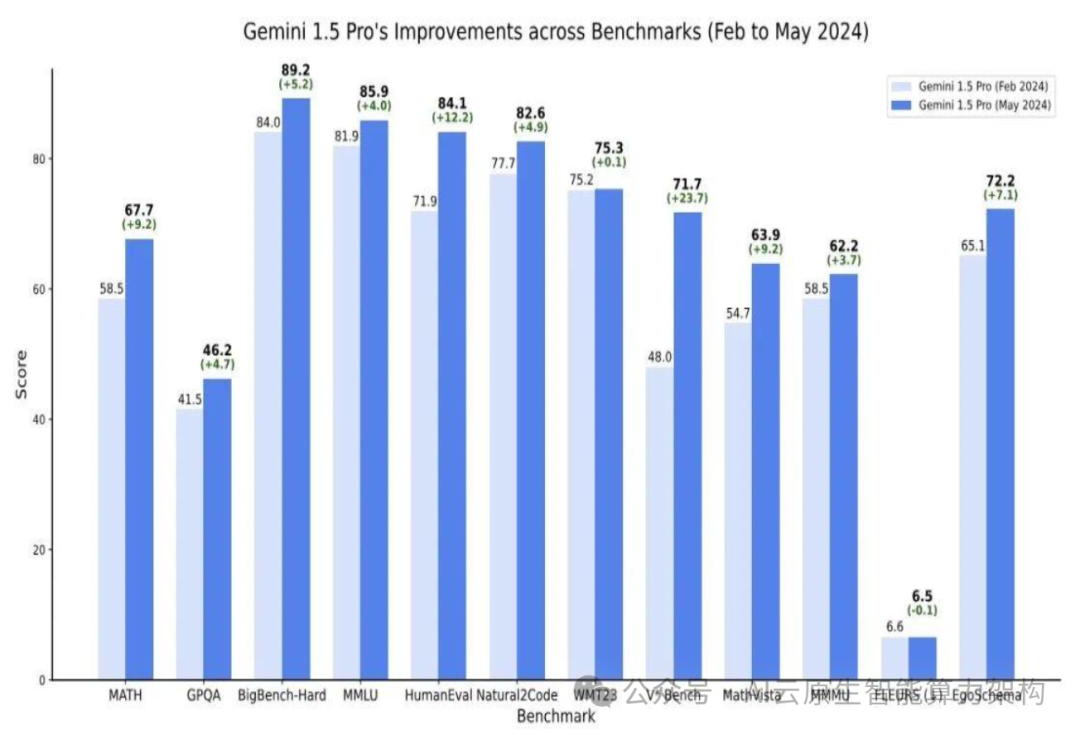

图16:2024年5 月Gemini 1.5 的性能相比 2 月份已有明显提升

1.1.1、 模型端:Openai有望开启AGI时代,国内外科 技厂商快速跟进

国内大模型发展迅速,已成为科技竞争的新焦点和产 业发展的新引擎。

(1)国内大模型创业领域形成了“6+2”格局,包括 智谱AI、minimax、阶跃星辰、百川智能、月之暗面、 零一万物、面壁智能和deepseek等公司,这些公司在 模型、应用和融资方面形成了关键竞争力。

(2)百度、阿里巴巴、腾讯、字节跳动等科技巨头 也积极布局大模型领域,推出了文心一言、通义千问、混元大模型、豆包大模型等,展现出强大的技术实力 和应用潜力。

(3)科大讯飞、昆仑万维等AI公司推出了星火、天 工等大模型,并且与其自身的业务形成了很好地融合。

表3:智谱、讯飞星火、minimax等国内大模型快速迭代

1.1.2、 算力端:大模型的快速发展,带动 了AI算力的强劲需求

大模型的快速发展,带动了AI算力的强劲需 求。

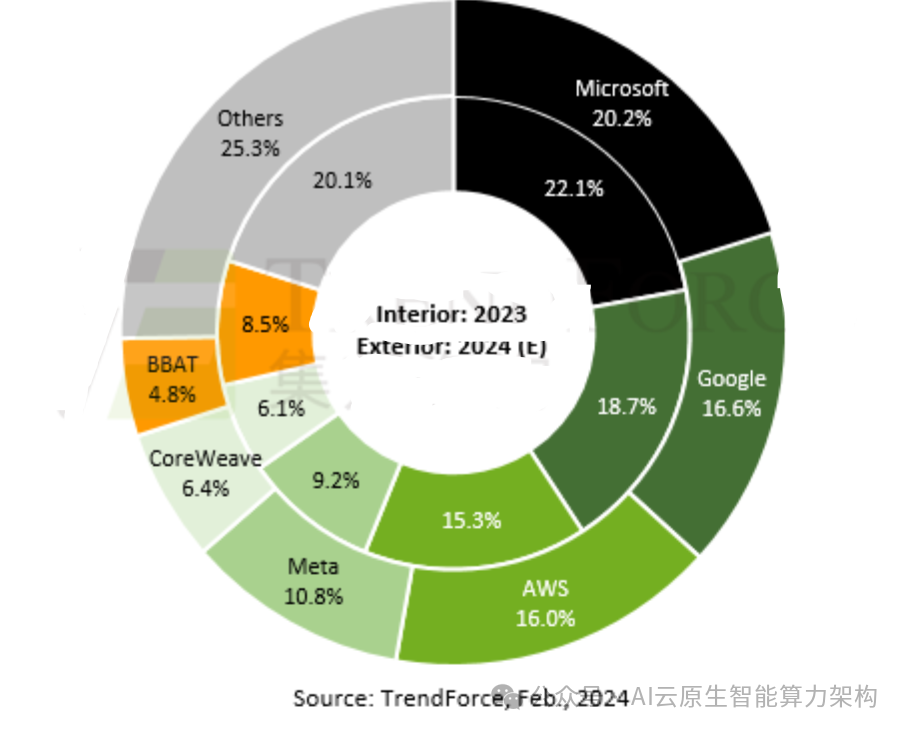

\根据TrendForce集邦咨询最新预估,以 2024年全球主要云服务厂商(CSP)对高端 AI服务器(包含搭载NVIDIA、AMD或其他 高端ASIC芯片等)需求量观察,预估美系四大CSP业者包括Microsoft、Google、AWS、 Meta各家占全球需求比重分别达20.2%、 16.6%、16%及10.8%,合计将超过6成,居 于全球领先位置。

其中,又以搭载NVIDIA GPU的AI 服务器为主。

图17:预估2024年北美四大云服务厂商对高端AI服务器需求量将逾六成

1.1.2、 算力端 : 大模型 的快速发展,带动了AI 算力的强劲需求

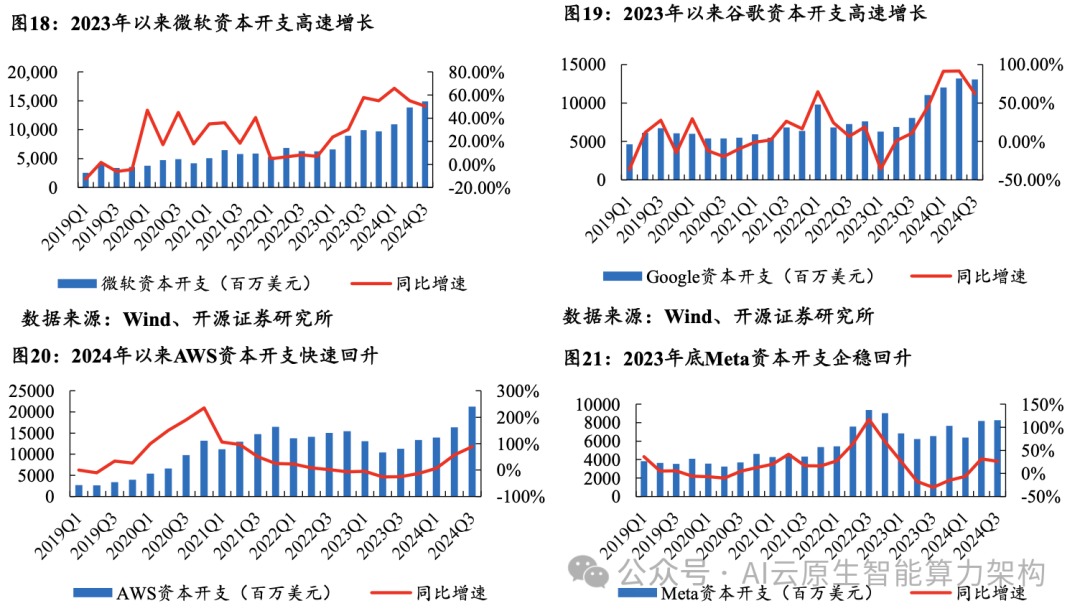

Microsoft 、 Google 、AWS、Meta四大云服务厂商资本开支持续强劲,说明AI算力需求旺盛。根据各大云厂商最新披根据各大云厂商最新披露的财报:

2024年03月:

-

Microsoft资本开支为149.23亿美元,同比增长50.48%;

-

Google资本开支为130.61亿美元,同比增长62.15%;

-

AWS资本开支为212.78亿美元,同比增长88.33%;

-

Meta资本开支为82.58亿美元,目同比增长26.21%。

1.1.2、 算力端:大模型的快速发展,带动 了AI算力的强劲需求

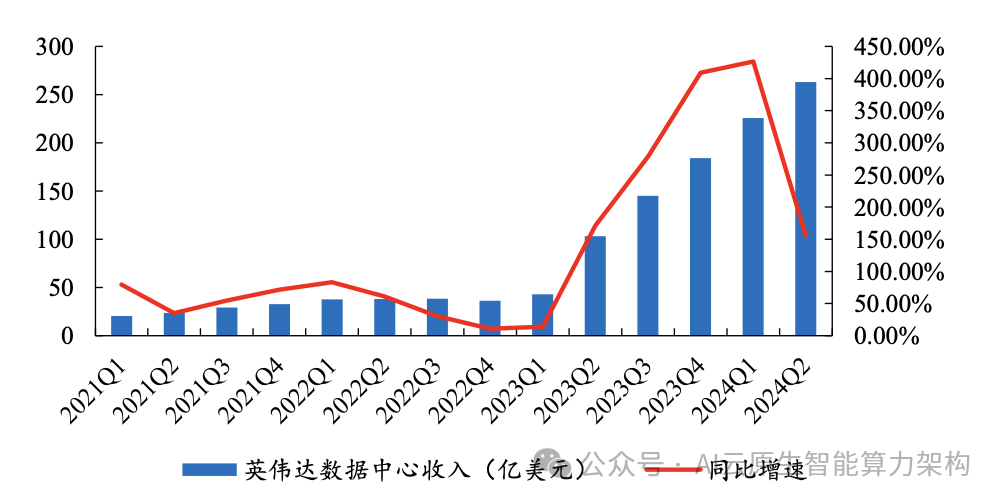

此外,英伟达数据中心业务持续高增长更为直接地论证了AI算力的强劲市场需求。 2023Q2开始英伟达数据中心业务保持超高 速增长,主要由于市场对AI和高性能计算的 需求不断增加,推动了英伟达GPU的销售。

图22:2023年以来英伟达数据中心业务持续高增长

1.1.2、 算力端:大模型的快速发展,带动了AI算力的强劲需求

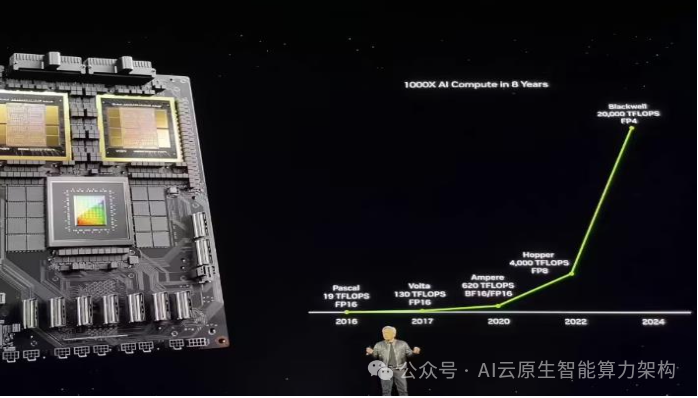

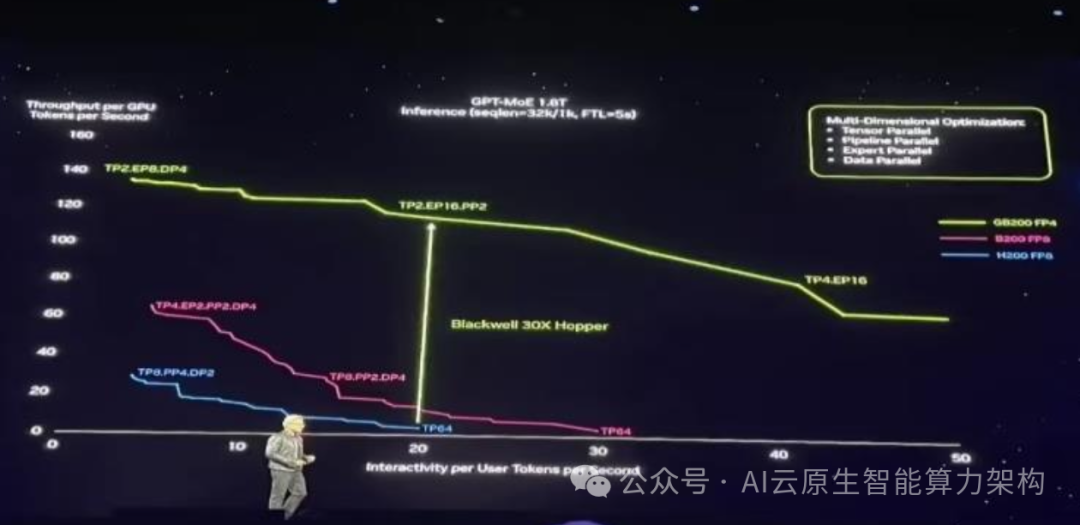

同时,AI算力产品自身的快速迭代也为大模型的训练提供良好基础。2024年3月,英伟达发布新一代 Blackwell GPU 架构, 继续沿用 4nm 的定制增强版工艺台积电 4NP。从 2016 年 Pascal GPU 的 19TFLOPS,到Blackwell GPU 的 20PFLOPS,英伟 达用 8 年将单卡AI训练性能提升了1000倍。

-

以训练 1.8 万亿参数的 GPT-MoE 混合专家模型为例,用25000个 Ampere GPU, 需要 3~5 个月左右;

-

要是用 Hopper,需要约 8000 个 GPU、90 天来训练,耗电 15MW;

-

而用 Blackwell,同样花 90 天,只 需 2000 个 GPU,耗电仅 4MW。

Blackwell全新NVLink Switch 芯片总带宽达到 7.2TB / s,支持 GPU 纵向扩展,能驱动 4 个 1.8TB / s 的 NVLink 端口。

而 PCIe 9.0 x16 插槽预计要到 2032 年才能提供 2TB / s 的带宽。

从单卡来看,相比 H100,Blackwell GPU的训练性能仅提高到 2.5倍,即便按新添的 FP4 精度算,推理性能也只提高到5倍。

但如果从系统性能来看,相比上一代Hopper集群,Blackwell可 将1.8万亿参数的 GPT-MoE 推理性能提高到30倍。

图23:英伟达用 8 年将单卡AI训练性能提升了1000倍

图24:相比上一代Hopper集群,Blackwell可将1.8万亿参数的 GPT-MoE 推理性能提高到30倍

1.1.3、 应用端:AI应用开始向用户场景渗透,拉开商业化序幕

2024年,AI大模型开始实质性向用户场景渗透。并且历经行业高速发展的混沌时期,AI应用市场逐渐回归理性,如何商业 化变现成为大模型厂商主要思考的问题。

按照客户类型,我们将AI应用市场分为C端市场和B端市场。

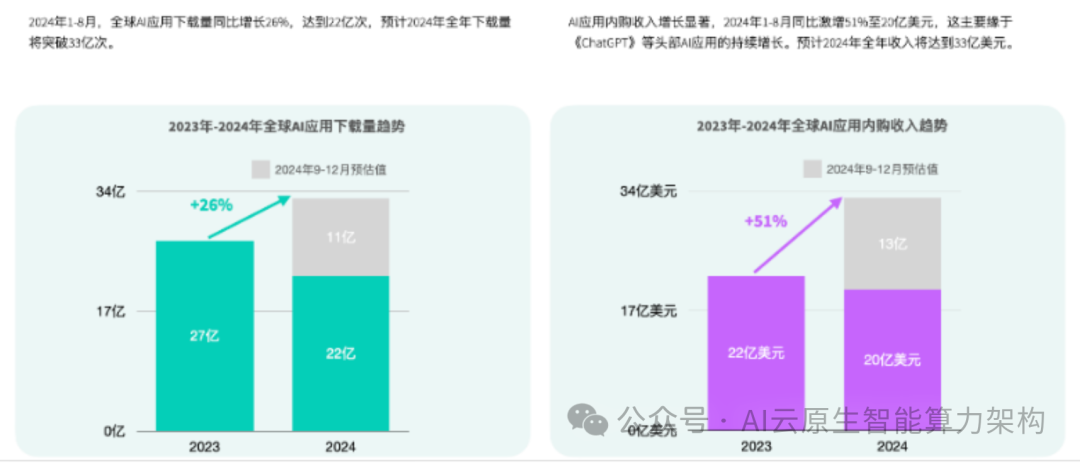

C端: 全球AI应用下 载量增长强劲。根据Sensor Tower发布的报告,2024年,全球AI应用市场在App Store和Google Play渠道展现出强劲的增长 势头。

2024年1-8月,全球AI应用下载量同比增长26%,达到22亿次,预计2024年全年下载量将突破33亿次。

与此同时,AI 应用内购收入增长显著,2024年1-8月同比激增51%至20亿美元,预计2024年全年收入将达到33亿美元。

2024年全球AI应用下载榜Top30几乎由Chatbot应用与图像编辑类应用包揽。

无论从下载量、收入还是活跃用户规模来看, OpenAI 推出的ChatGPT都是 AI 应用市场的冠军。

Google Gemini、Microsoft Copilot和Chatbot AI & Smart Assistant等 3 款新 AI应用跻身榜单第4、8和9名。此外,来自字节跳动的Chatbot应用《豆包》位列下载榜第5名,是榜单中唯一一款中文 AI 应用。

图25:2024年1-8月全球AI应用下载量同比增长26%,内购收入同比激增 51%至20亿美元

图26:2024年全球AI应用下载榜Top30几乎由Chatbot应用与图像编辑类 应用包揽

1.1.3、 应用端:AI应用开始向用户场景渗透,拉开商业化序幕

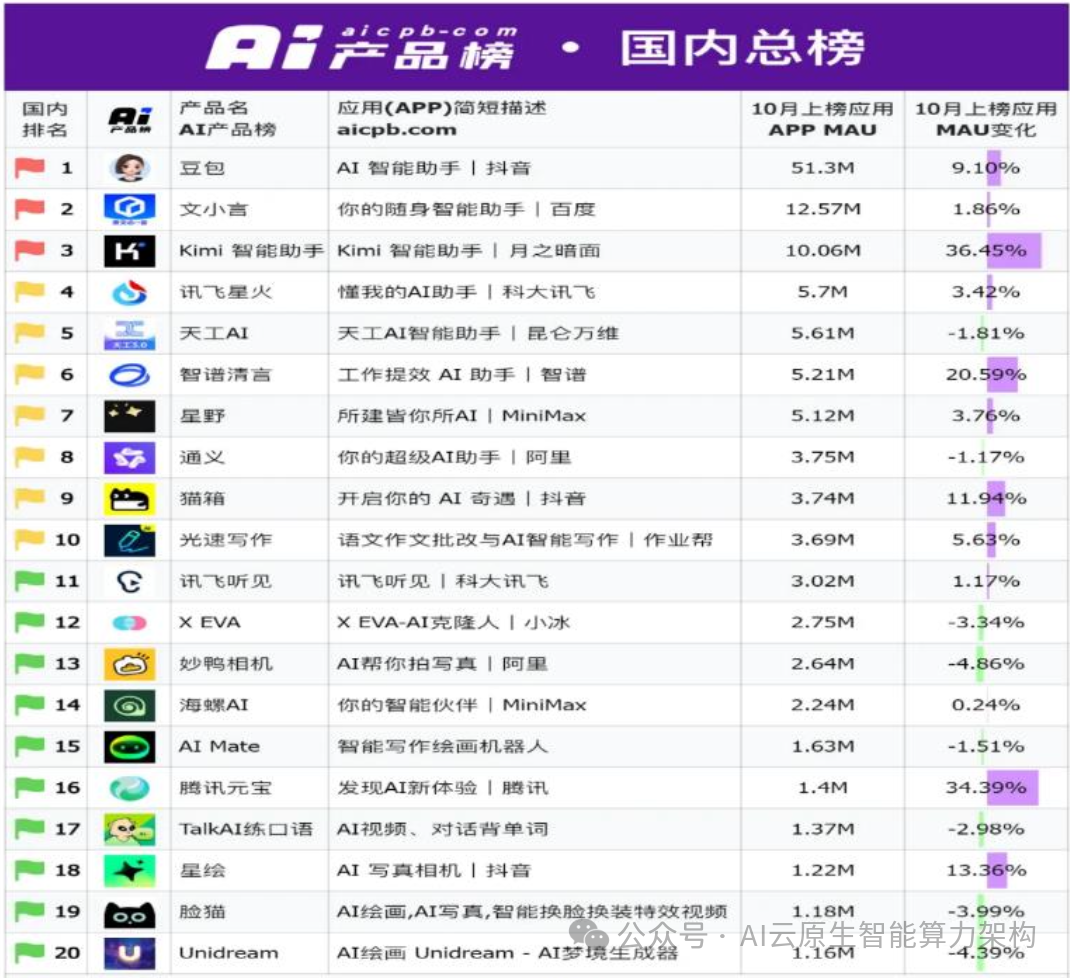

国内AI应用月活榜Top20也主要以Chatbot应用与图像编辑类应用为主。

根据aicpb-com发布的Ai产品榜10月国内总榜(按月 活用户量),豆包、文小言、kimi排名前三。

其中,豆包MAU最高,达到5130万; Kimi MAU增速最快,10月增长了36.45%,达到1006万。

图27:国内AI应用月活榜Top20也主要以Chatbot应用与图像编辑类应用为主

1.1.3、 应用端:AI应用开始向用户场景渗透,拉开商业化序幕

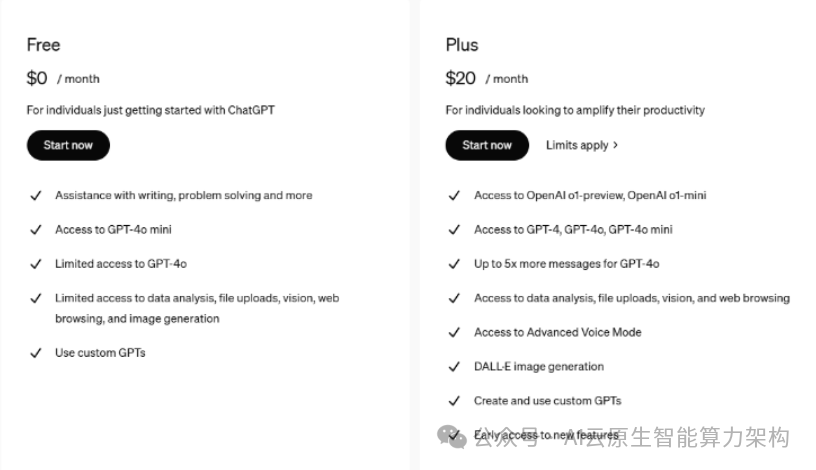

C端市场,大模型厂商的主要商业模式为SaaS化订阅。

以ChatGPT为例,面向个人用户,OpenAI推出免费版和Plus版会员, Plus会员收费为20$/月。

-

Plus版会员有使用GPT-4、GPT-4o、GPT-4o mini,GPT-4o的限额是普通用户的5倍以上,DALL·E图 片生成等一系列会员权限。

-

国内以文心一言为例,2024年11月1日上午,百度大模型“文心一言”平台推出会员模式,开通 后可解锁文心大模型4.0。

-

这是国内首个向To C(消费)端付费的人工智能(AI)大模型产品。

-

文心一言会员单月购买价格 为59.9元,连续包月价格为 49.9 元(次月以49.9元/月自动续费,可随时取消)。

-

此外,百度还推出了文心一言4.0+文心一 格白银的联合会员,价格为99元/月。

图28:面向个人用户,OpenAI推出免费版和Plus版会员

1.1.3、 应用端:AI应用开始向用户场景渗透,拉开商业化序幕

B端市场,大模型商业模式分为按Tokens/API接口调用次数收费、SaaS订阅模式(按时间)、项目制私有化大模型部署等 多种模式。

(1)按Tokens/API接口调用次数收费:这是大多数大模型厂商选择的收费方式。

同样以ChatGPT为例,各大模 型定价相差较大,其中o1-preview 输出服务收费最贵,收费标准为$0.0600/1K output tokens。

表4:ChatGPT各大模型定价相差较大

1.1.3、 应用端:AI应用开始向用户场景渗透,拉开商业化序幕

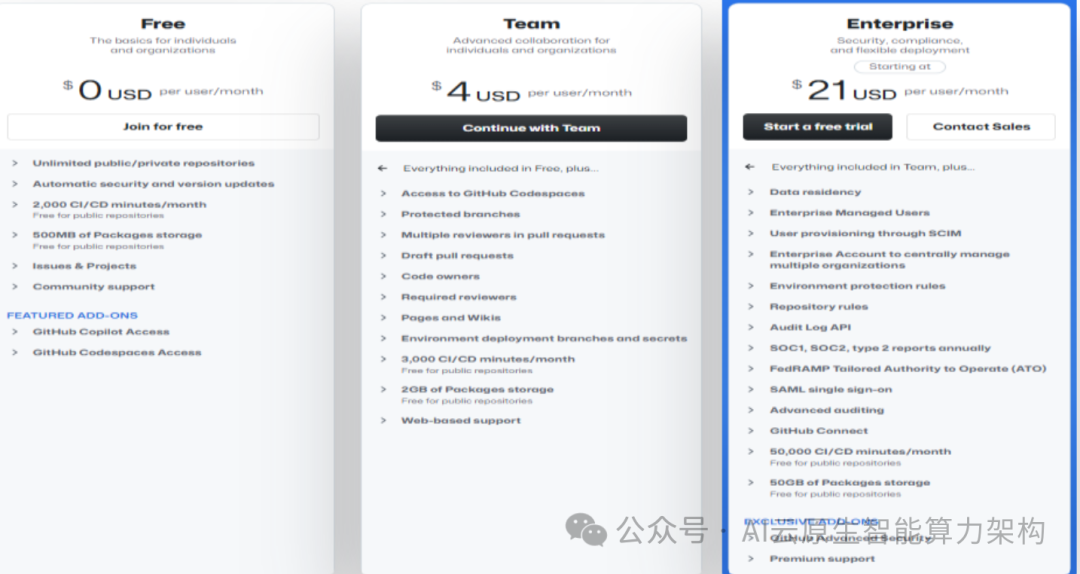

(2)SaaS订阅模式(按时间): 如微软开发的AI编程工具GitHub Copilot,其团队版本和企业版本收费分别为$4/user/month和$21/user/month。

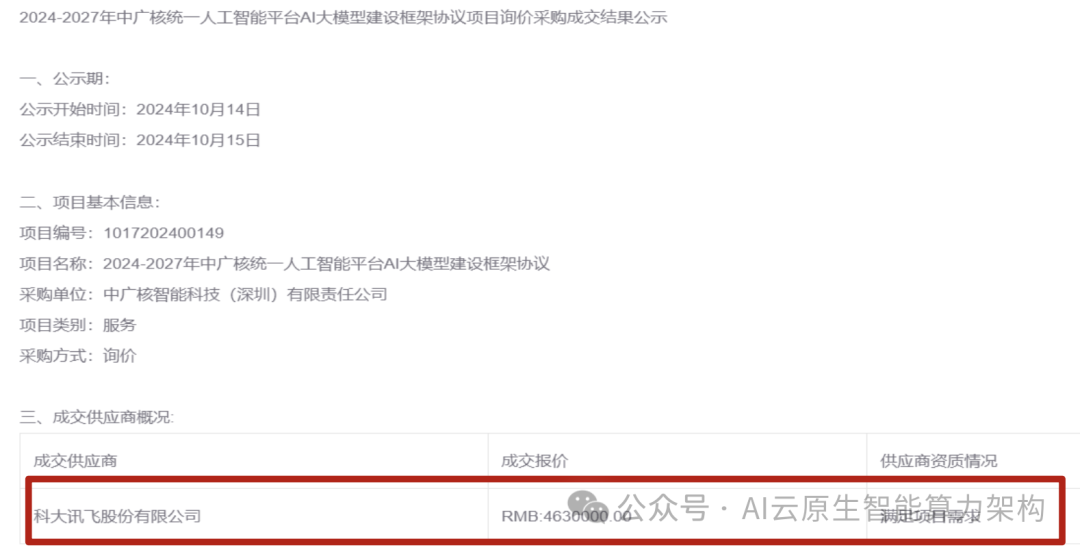

(3)项目制私有化大模型部署: 对于大型国央企及事业单位,基于安全性考虑更倾向于选择私有化部署的模式,服务内容 不仅包括大模型系统,还包括服务器等硬件产品等一站式解决方案。例如,2024年10月,科大讯飞中标2024-2027年中广核 统一人工智能平台AI大模型项目,中标金额为463万元,主要建设内容为:大模型算法训练平台、大模型算法推理平台、模 型库、样本库、AI大模型授权服务(买断)、AI大模型场景应用、算法定制服务、数据服务及技术支持服务。

图30:GitHub Copilot团队版本和企业版本收费分别为$4/user/month和 $21/user/month

图31:科大讯飞中标2024-2027年中广核统一人工智能平台AI大模型项目

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1987

1987

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?