作者主页(文火冰糖的硅基工坊):文火冰糖(王文兵)的博客_文火冰糖的硅基工坊_CSDN博客

本文网址:https://blog.csdn.net/HiWangWenBing/article/details/121051650

目录

第1章 关于1维Conv1d、2维卷积Conv2d、3维卷积Conv3d说明

前言:

本文是深度学习框架 pytorch 的API : torch.nn.Conv2d() 函数的用法。

本博客介绍了 torch.nn.Conv2d() 各个参数的含义和用法,学会使用 pytorch 创建 卷积神经网络。

参考:官方文档和其它博客。

第1章 关于1维Conv1d、2维卷积Conv2d、3维卷积Conv3d说明

1.1 一维卷积

-

无论有几个通道,卷积后的输出数据的形状是:一维。

-

一维卷积常用于序列模型,如自然语言处理领域。

-

图中的输入的数据维度为1,长度为8,形状为1*8,过滤器的维度为1,长度为5,形状为1*5,步长为1,卷积后输出的数据形状为:8−5+1=4。

-

如果过滤器数量仍为1,输入数据的channel数量变为16,即输入数据形状为16*8。

1.2 二维卷积

-

无论有几个通道,卷积后的输出数据的形状是:二维。

-

二维卷积常用于计算机视觉、图像处理领域。

-

图中的输入的数据形状为14×14,过滤器形状为5×5,二者做卷积。步长为1时,输出的数据形状为10×10,即14−5+1=10。

-

上述内容没有引入channel的概念,也可以说channel的数量为1。

-

如果将二维卷积中输入的channel的数量变为3,即输入的数据维度变为(14×14×3)。由于卷积操作中过滤器的channel数量必须与输入数据的channel数量相同,过滤器大小也变为5×5×3。在卷积的过程中,过滤器与数据在channel方向分别卷积,之后将卷积后的数值相加,最终输出的数据形状为10×10。输出依然是二维数据。

1.3 三维卷积

- 无论有几个通道,卷积后的输出数据的形状是:三维。

- 三维卷积常用于医学领域(CT影响),视频处理领域(检测动作及人物行为)。

第2章 Conv2d类说明

2.1 作用

在Pytorch中,用于的定义一个二维卷积层。

2.2 Conv2d的本质

Conv2d本质是一个模板类,其参数用于赋给构造函数,用于创建二维的卷积层 。

2.3 类原型

Conv2d (in_channels, out_channels, kernel_size, stride=1,padding=0, dilation=1, groups=1,bias=True, padding_mode=‘zeros’)

2.4 参数说明

- in_channels:输入的通道数目 【必选】

- out_channels: 输出的通道数目 【必选】,决定了卷积的个数。

- kernel_size:卷积核的大小,类型为int 或者元组,当卷积是方形的时候,只需要一个整数边长即可,卷积不是方形,要输入一个元组表示 高和宽。【必选】

- stride: 卷积每次滑动的步长为多少,默认是 1 【可选】

- padding: 设置在所有边界增加 值为 0 的边距的大小(也就是在feature map 外围增加几圈 0 ),例如当 padding =1 的时候,如果原来大小为 3 × 3 ,那么之后的大小为 5 × 5 。即在外围加了一圈 0 。【可选】

备注:

这里并没有指定特征输出的大小,特征输出的形状是有输入特征的形状、卷积核的形状、移动步长共同决定的,可以计算出来。

- dilation:控制卷积核之间的间距,(什么意思?请看例子)【可选】,就是相邻两个卷积核元素的距离,默认为0,即相邻两个卷积核元素是仅仅相邻的,中间没有空隙。

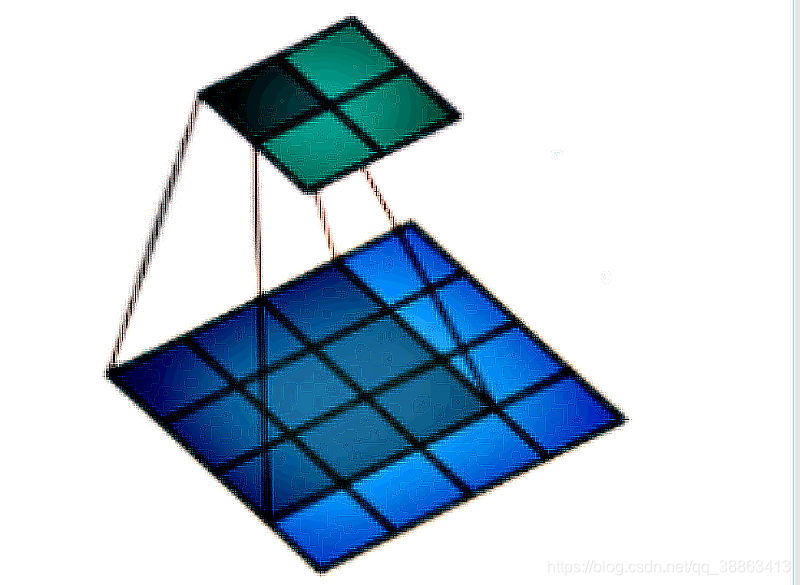

如果我们设置的dilation=0的话,效果如图:(蓝色为输入,绿色为输出,卷积核为3 × 3)

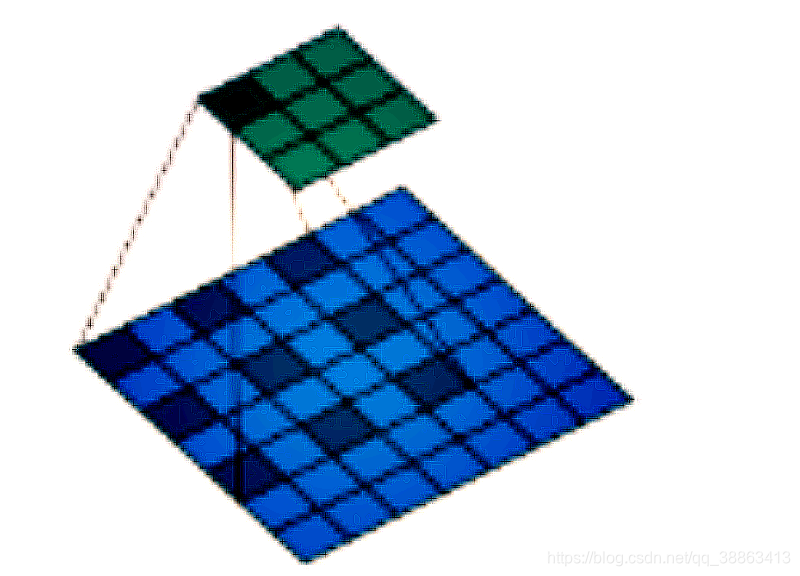

如果设置的是dilation=1,那么效果如图:(蓝色为输入,绿色为输出,卷积核仍为 3 × 3 。)

这时候,卷积核的元素之间有一个空隙。

- groups:控制输入和输出之间的连接。(不常用)【可选】

举例来说:

当groups 为1的时候,分为一组,即所有的输入都会连接到所有输出。

当groups 为2的时候,分为两组,并排放置两层,每层看到一半的输入通道并产生一半的输出通道,并且两者都是串联在一起的。这也是参数字面的意思:“组” 的含义。

需要注意的是,in_channels 和 out_channels 必须都可以整除 groups,否则会报错。

Alex就是把卷积核分层了两组,分别用不同的GPU上进行训练。

- bias: 是否将一个 学习到的 bias 增加输出中,默认是 True,就是否需要偏置值b 。【可选】

- padding_mode : 字符串类型,接收的字符串只有 “zeros” 和 “circular”。【可选】

注意:参数 kernel_size,stride,padding,dilation 都可以是一个整数或者是一个元组,一个值的情况将会同时作用于高和宽 两个维度,两个值的元组情况代表分别作用于 高 和 宽 维度。

作者主页(文火冰糖的硅基工坊):文火冰糖(王文兵)的博客_文火冰糖的硅基工坊_CSDN博客

本文网址:https://blog.csdn.net/HiWangWenBing/article/details/121051650

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?