资料

我的代码:https://github.com/Whiffe/Bert-OCNLI/tree/main/T5-OCNLI-yf

过去的内容:

Bert 在 OCNLI 训练微调

Bert 在 OCNLI 训练微调 2

BERT系列模型 在OCNLI 训练微调 3

模型下载与训练测试

mt5-base

conda install -c conda-forge sentencepiece

https://huggingface.co/google/mt5-base/tree/main

调用t5模型的过程:https://blog.csdn.net/znevegiveup1/article/details/121300828

训练测试结果:

train.50k.json、max_length=128、batch_size=32、dropout=0.1、lr=5e-5、epochs=10

准确率:70.13

train.50k.json、max_length=128、batch_size=32、dropout=0.3、lr=5e-5、epochs=10

准确率:70.03

train.50k.json、max_length=128、batch_size=32、dropout=0.2、lr=5e-5、epochs=10

准确率:67.43

train.50k.json、max_length=128、batch_size=32、dropout=0.1、lr=1e-5、epochs=10

准确率:58.9%

train.50k.json、max_length=128、batch_size=32、dropout=0.1、lr=5e-5、epochs=15

准确率:70.7%

train.50k.json、max_length=128、batch_size=16、dropout=0.1、lr=5e-5、epochs=15

准确率:37.63%

train.50k.json、max_length=128、batch_size=64、dropout=0.1、lr=5e-5、epochs=15

准确率:37.8%

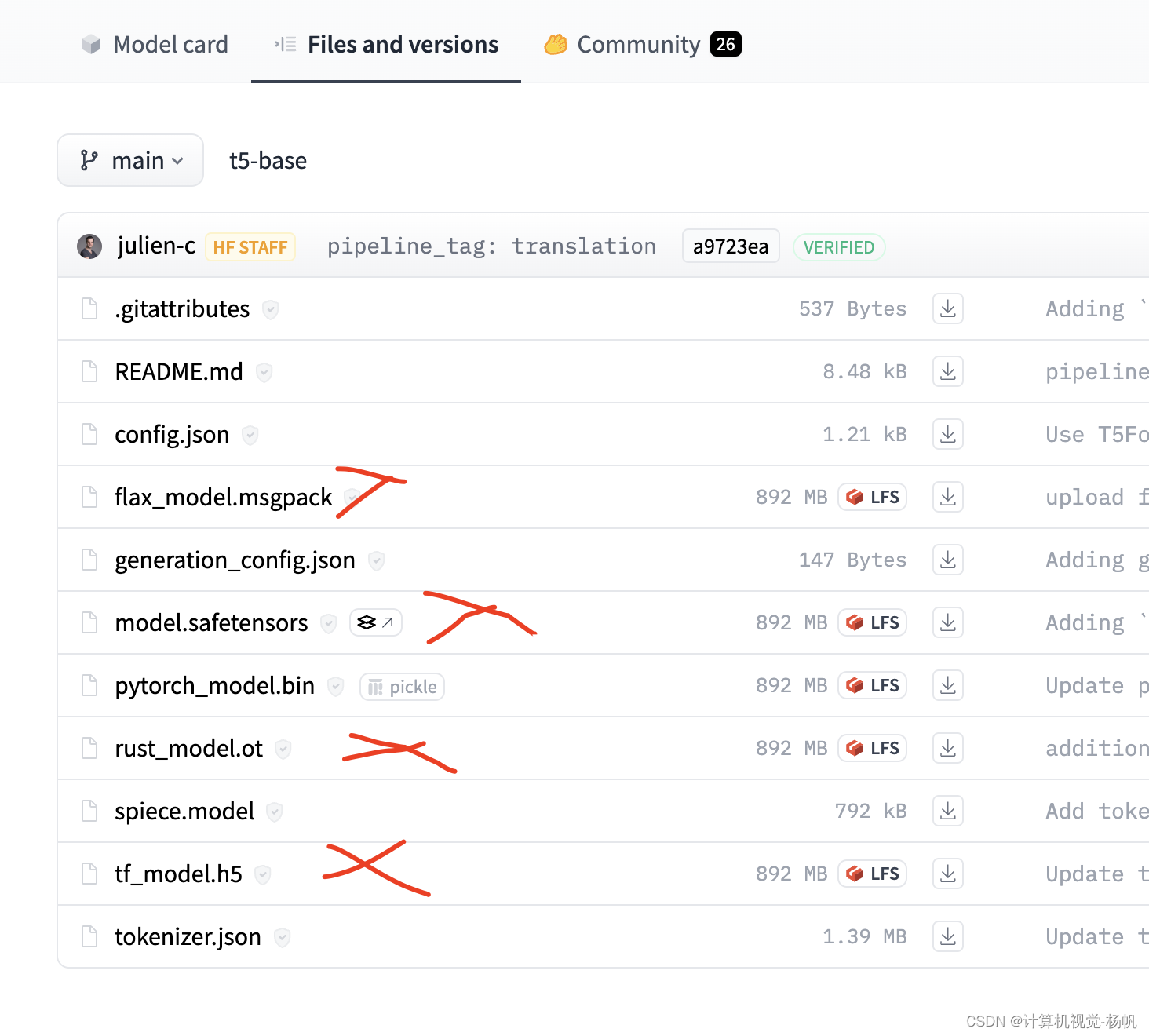

t5-base

https://huggingface.co/google-t5/t5-base/tree/main

训练测试准确率

train.50k.json、max_length=128、batch_size=32、dropout=0.1、lr=5e-5、epochs=15

准确率:37.6%

nlp_mt5_zero-shot-augment_chinese-base

全任务零样本学习-mT5分类增强版-中文-base · 模型库 (modelscope.cn):https://www.modelscope.cn/models/iic/nlp_mt5_zero-shot-augment_chinese-base/files

训练测试准确率:

train.50k.json、max_length=128、batch_size=32、dropout=0.1、lr=5e-5、epochs=15

准确率:71.6%

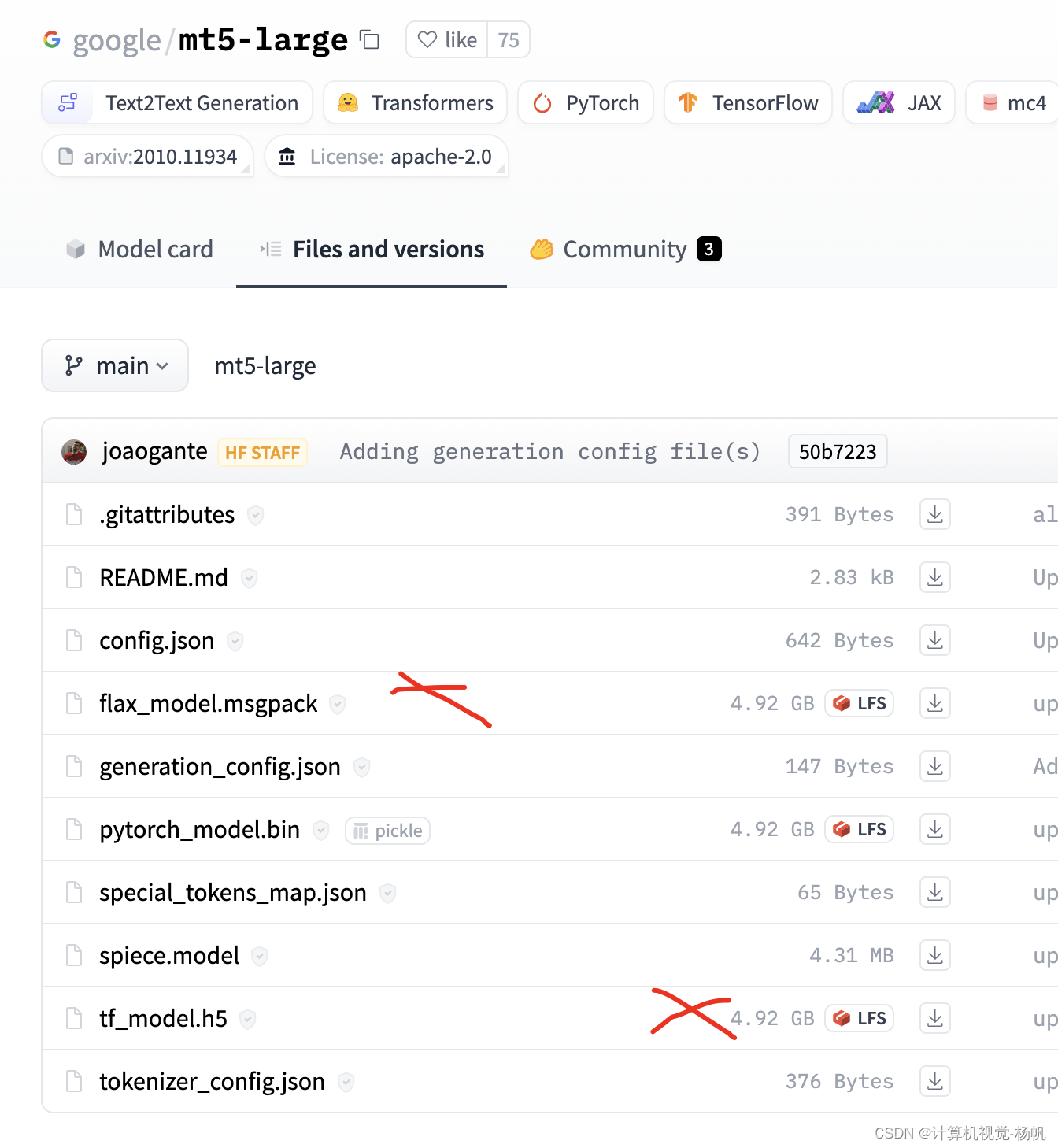

mt5-large

https://huggingface.co/google/mt5-large/tree/main

训练测试准确率:

在这里插入代码片

1154

1154

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?