点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

作者丨paopaoslam

来源丨 泡泡机器人SLAM

标题:CLINS: Continuous-Time Trajectory Estimation for LiDAR-Inertial System

作者:Jiajun Lv1, Kewei Hu1, Jinhong Xu, Yong Liu, Xiushui Ma, Xingxing Zuo

来源:IROS 2021

编译:曹明

审阅:lionheart

摘要

在这篇文章中,我们提出了一个用于SLAM的准确度极高的连续时间轨迹估计框架。它能够高效地融合高频率与不同步的传感器信息。我们在一个3D激光-惯性系统下使用了这一套框架来验证其效果。本文提出的方法使用了非刚体配准的方法来进行连续时间的轨迹预测,同时来进行激光雷达的点云畸变矫正。除此之外,当回环检测发生时,我们还提出了一个两阶段的轨迹矫正方法,来高效的解决比较耗时的全局优化问题。我们在几个公开的数据集以及我们自己采集的数据上都测试了我们的方法。实验的结果表明了当激烈的运动发生时,我们的方法优于离散时间估计的方法。此外,我们还开源了代码以给研究社区做出贡献。

主要贡献

1. 提出了一个连续时间的轨迹估计器,支持融合3D激光雷达的数据与IMU的数据,并且很容易将其扩展,使得其能够融合其他不同频率的传感器信息。

2. 提出了一个两阶段的轨迹矫正方法来有效的解决回环检测时的计算量问题。

3. 所提出的方法在几个公开的数据集以及我们采集的数据集上进行了验证,并且跟其他SOTA的方法进行比较。我们还开源了代码。据我们所知,这是第一份开源的连续时间的激光-惯性轨迹估计器的工作。

连续时间的轨迹表示方法

离散时间的轨迹优化方法是直接针对机器人的离散时间的轨迹点来进行位姿图优化。

连续时间的轨迹优化方法不直接对机器人的轨迹点进行优化,而是将机器人的轨迹用B样条来拟合,并且通过调整B样条的控制点的位置使得轨迹尽可能贴合观测。

本文采用两组B样条控制点,分别拟合机器人的旋转与平移在时间上的轨迹。

方法论

A. 时序图

本文提出的方法所采用的方案的时序图如图所示。该方法采用的是三次B样条,并且以固定的时间间隔来插入控制点。在当前帧的点云的数据采集周期之内的段(segment)为活跃段(Active Segments),而影响活跃段的控制点,定义为活跃的控制点(蓝色与红色的点),对应的B样条基函数为活跃基函数(图中蓝色曲线和红色曲线)。受到活跃基函数影响的除了活跃段之外的段,称之为静态段,对应的控制点与基函数称之为静态曲线与静态基函数。

B. 初始化

一帧新的激光雷达点云被采集时,根据设定的时间频率,已经有一定数量的控制点被加入以控制机器人的当前的轨迹。对此,先将该时间段内的IMU数据进行旋转、位置以及速度上的积分,然后调整控制点的位置,使得B样条插值出来的旋转、位移以及速度符合IMU积分的结果。其优化的目标函数为

C. 局部窗口内的非刚体变换配准

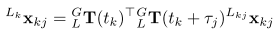

由于激光雷达在一帧点云的采集时间之内,由于外部运动,会导致点云畸变的产生。产生畸变的点云就不再是可以用刚体变换来描述的了,因此传统的刚体配准方法(ICP, NDT)往往会带来误差。本文由于使用B样条拟合轨迹,因此可以插值出任意时刻的速度与位姿。利用其位姿来将点云内的每一个点还原到k时刻激光雷达的坐标系下,其公式为

本文的位姿优化是在一个局部窗口中,该局部窗口由关键帧组成。关键帧的选取准则为机器人的位姿变换超出了设置的阈值。每当一帧新的点云获取时,会将其提取LOAM的面点与特征点,并且与局部地图的最近点来做关联。

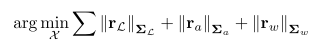

在一些退化的场景下,IMU的信息是不受影响的。因此我们紧耦合了IMU的测量与激光雷达的特征来进行轨迹的约束。本文的目标函数为:

这三个残差项的定义为

其中,公式(7)表示将边缘点以及面点投影后的残差。公式(8)表示优化出来的位姿相对于IMU加速度的残差,公式(9)表示优化出来的位姿相对于角速度的残差。

当回环检测发生时,直接对连续轨迹的控制点进行优化是非常耗时的,因此本文提出了一种两阶段的优化策略。

在阶段一,当回环被检测到时,对对应的位姿进行图优化来消除累积误差,这种方法与传统的离散的方法(如LIO-SAM)类似。

在阶段二,对影响阶段1的轨迹的那些控制点来进行优化,使得轨迹能够更好的贴合阶段1得到的优化后的位姿。阶段二的目标函数为:

实验

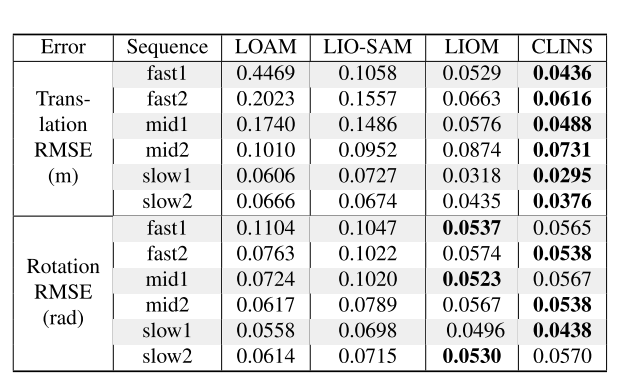

A. 室内场景的轨迹估计

在公开数据集上验证了本文提出的方法的唯一与旋转的均方根误差,相较于其他的激光雷达-惯性系统的结果。

B.大规模场景的轨迹预测与场景建图

在公开数据集以及校园场景下的数据集的一个结果验证。建图效果如图所示。

Abstract

Abstract—In this paper, we propose a highly accurate continuous-time trajectory estimation framework dedicated to SLAM (Simultaneous Localization and Mapping) applications, which enables fuse high-frequency and asynchronous sensor data effectively. We apply the proposed framework in a 3D LiDAR-inertial system for evaluations. The proposed method adopts a non-rigid registration method for continuous-time trajectory estimation and simultaneously removing the motion distortion in LiDAR scans. Additionally, we propose a two- state continuous-time trajectory correction method to efficiently and efficiently tackle the computationally-intractable global optimization problem when loop closure happens. We examine the accuracy of the proposed approach on several publicly available datasets and the data we collected. The experimental results indicate that the proposed method outperforms the discrete-time methods regarding accuracy especially when ag- gressive motion occurs. Furthermore, we open source our code at https://github.com/APRIL-ZJU/clins to benefit re- search community.

本文仅做学术分享,如有侵权,请联系删文。

3D视觉精品课程推荐:

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

4.国内首个面向工业级实战的点云处理课程

5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~

1457

1457

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?