基于情绪转移的对话情绪识别的多任务学习

摘要

随着人机交互的不断发展,情感识别在对话中的重要性变得越来越明显。对于聊天机器人等应用程序提供更多类似人类的反应来说,机器理解对话中嵌入的情绪是至关重要的。虽然最近的大多数研究都集中在从对话中提取上下文信息,但局部对话中情绪转移(ES)的微妙之处往往被忽视。然而,获取互动之间的ES知识可以降低情绪波动对话中的情绪识别错误率。作为ES转移的一种解决方案,我们使用对话中的情绪识别(ERC)数据集来定义同一说话者之间以及不同说话者之间的ES。我们提出了一种新的多任务学习模型,称为MtlERC-ES,它可以同时识别三个任务:对话中的情绪识别(ERC)、情绪转移(ES)和情绪极性分类(SC)。我们的方法在ERC任务上提供了高质量的性能,在多个数据集中始终排在性能最好的位置上。我们的方法还证明了自定义ES任务的有效性。

1 介绍

对话中的情感识别(ERC)在人机交互系统领域具有重要的应用意义,在民意挖掘和医疗咨询等领域具有重要的应用价值。ERC的目标是识别在对话中包含的每个话语中的情感。由于情绪表达的情境依赖性,这项任务是复杂的。一波ERC的研究都集中在有效地建模对话情境上,这是影响对话的情绪基调的一个关键因素。

在对话设置中,情绪惰性常常导致说话者保持一致的情绪状态。然而,外部刺激可以导致这些情绪状态的突变。图1展示了一个对话,其中说话者的情绪随着外部触发而波动。在这种情况下,我们可以观察到情绪的多个变化。首先,对话中Phoebe开始时表现出一种中立的情绪。当Monica提到她的惊喜派对时,Phoebe表达了她对惊喜派对的无知,她的情绪变成了惊喜,但仍然是积极的,因为惊喜派对是一件让人们快乐的事情。然而,当Monica说Joey告诉了她时,Phoebe的情绪开始改变,从积极到愤怒和消极,因为她讨厌被排除在信息圈之外。这个例子说明了动态对话所产生的不可预测性如何影响上下文中的情绪流动。

Poria 等人(2019b)的研究表明,现有的最先进方法往往会持续为某一特定说话者重复相同的情绪。这种模式与以下理解相一致,即由于情绪的惰性,说话者的情绪不太可能发生突然的转变。因此,这些方法在情绪转换(ES)发生时往往表现不足。这个局限性凸显了一个事实:许多现有技术缺乏有效检测语句间情绪转换的能力,同时忽视了会话中情绪标签之间的动态关系。Gao等人(2022)的研究提出了使用多任务学习来同时检测ES和情绪识别。但是,他们的方法只定义了ES是否发生在话语之间,因此模型不能完全捕获ES的细节。例如,一个模型可能无法区分从幸福到悲伤的过渡和从悲伤到幸福的过渡,尽管这两种过渡在现实生活中有非常不同的意义和后果。因此,为了更好地理解和预测情绪转移,该模型必须能够捕捉到更具体的ES的方向和幅度。

为了更好地理解话语间的ES,我们提出了Mtl-ERC-ES网络,一种用于情绪识别的多任务学习方法。这种方法允许模型同时理解和处理三个任务,主要任务是ERC。ERC的第一个辅助任务,称为情绪极性分类(SC),模型学习情绪极性(情绪的正负倾向),从而提供更广泛的情绪表示。这种理解增强了模型区分正面和负面情绪强弱的能力,并能够识别对话中情绪状态是发生了显著还是轻微的变化。。第二个辅助任务专门针对情绪转移,这在现有的研究中还没有得到很好的定义和探索。因此,我们提出了一种新的方法,基于在对话中观察到的情绪极性来定义和处理ES。我们在四个ERC数据集上进行了实验。实验结果表明,我们的模型始终表现出优异的性能。对这两种辅助任务都进行了消融研究,证实了将SC和ES相结合的多任务学习方法的有效性。本研究的主要贡献如下:

- 我们基于ERC数据集开发了一个情绪转移的详细定义。

- 我们提出了Mtl-ERC-ES网络,它同时处理ERC和相关任务: SC和ES

- 我们在四个基准的ERC数据集上进行了广泛的实验。实验结果不仅证明了该方法的优越性,也显示了其与现有SOTA模型的竞争力。

2. 相关工作

2.1 对话中的情感识别

近年来,由于深度学习技术的进步和现有ERC数据集的增长,对话中的情感识别(ERC)领域越来越受到研究者的关注。这些研究主要集中在静态上下文信息的建模上,其中包括与目标陈述相关的说话者和话语的信息。DialogueRNN(Majumder等人,2019)利用递归神经网络跟踪对话中每个参与者的状态,并利用这些信息进行情绪识别。COSMIC(Ghosal et al.,2020)通过引入外部知识来学习参与对话的对话者之间的相互作用。DAG-ERC(Shen et al.,2021)使用一个有向的无环图网络来学习长距离的上下文信息。DialogueCRN(Hu et al.,2021)探索了基于情感理论的情境模型的知觉推理能力。CoMPM(Lee和Lee,2022)通过构建一个额外的模型来提取上下文信息,并将其合并到一个预先训练过的语言模型中,从而提高了性能。

然而,这些研究大多集中在特定范围内的语境和相关对话中说话者状态的建模,而忽略了局部成对对话中情绪的动态流动。近年来,一些研究探讨了对话中情绪的动态转移关系。EmotionFlow(Song et al.,2022)通过一个额外的CRF层捕获了对话过程中情绪传播的影响。HCL-ERC(Yang et al.,2022)使用课程学习方法,根据ES发生的频率,制定了一种在对话层面提供培训示例的策略。DialogueEIN(Liu et al.,2022)设计了一个情绪交互网络来模拟说话者内部、说话者之间以及全局和局部的情绪交互。

2.2 多任务学习

多任务学习(MTL)同时训练来自多个相关任务的机器学习模型,目的是利用多个任务中包含的有价值的信息来提高泛化性能。在ERC领域,之前的一些研究已经应用了MTL。在Li等人(2020)的研究中,使用说话人识别作为辅助任务,以增强对话中的上下文信息。ERC-ESD(Gao et al.,2022)通过将定义和检测ES定义为一个子任务,确定这种变化是否发生在同一说话者中,从而提高了ERC的性能。在MTL框架中,当任务密切相关时,模型的性能会显著提高。例如,Chauhan等人(2020)进行了一项研究,假设讽刺与情感和情绪极性密切相关,他们提出了一种使用MTL的方法,利用情感和情绪极性分析这两个辅助任务,来显著提高讽刺检测性能。在ERC任务的范围内,情绪极性SC代表了情绪识别的粗粒度分类,而情感转移ES则代表了整个对话过程中情绪表达的动态变化。这三个元素——SC、ES和ERC任务本身—有着密切的关系。因此,我们有理由认为,ES识别和SC可以作为辅助任务来提高ERC的性能。

3. 提出的方法

3.1 准备工作

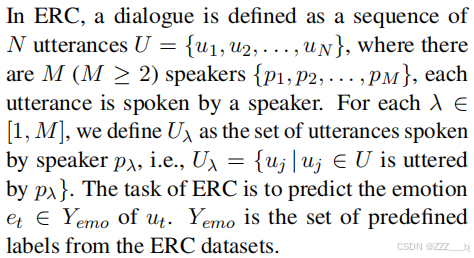

3.1.1 对话中的情感识别(ERC)

3.1.2 情绪转移(ES)

我们根据 ERC 数据集来定义 ES。为此,我们需要确保根据 ERC 数据集定义的 ES 任务的每个类别都有足够的样本数量。由于数据量的限制,我们将情绪转移(ES)视为一个固定类别的分类任务。将其视为分类任务的优势在于,可以通过实验结果轻松分析模型识别每个类别情绪转移的能力。受 MELD 数据集(Poria et al., 2019a)中对每个语句进行情感标注(正面、负面、中性)的启发,我们根据情绪是否为正面,对 ERC 数据集的情绪标签进行极性标注,并将其划分为三种情感标签类型:正面、中性和负面。以 MELD 数据集和 IEMOCAP 数据集为例,情绪到情感的映射如表 1 所示。 我们将情感标签按负面(0)、中性(1)、正面(2)的顺序排序,从而将情绪转移(ES)定义为当前语句与前一语句情感标签之间的差值。例如,如果当前语句为正面(2),而前一语句为中性(1),则差值为 1,表示正向的情绪转换(正向 ES)。 另一个例子是,如果当前语句为正面(2),而前一语句为负面(0),则差值为 2,表示强烈的正向情绪转换(强正向 ES)。这一概念与直觉一致:从负面情绪突然转变为正面情绪应表示一种强烈的正向转变。

同时,我们认识到说话者的内部情绪演变与整个对话的情绪波动存在差异。因此,我们首先定义了对话中相邻语句之间的情绪转移(对话情绪转移),然后独立定义了说话者自身的情绪转移(说话者情绪转移)。这些定义如下:

其中,global 表示整体的语句级别,具体而言,是指对话中相邻的语句;speaker 表示说话者的语句级别,即由说话者自己发出的相邻语句。因此,对于 U 中的每个语句,我们分配两个额外的标签:说话者自己的情绪转移标签和相邻情绪转移标签。

这些情绪转移标签的分类如下:

Yshift = {强烈负向转移、负向转移、无转移、正向转移、强烈正向转移}。

表 2 显示了我们基于 ERC 数据集构建的情绪转移标签类别分布的一部分。

3.2 提出的方法

图2提供了我们的多任务学习模型的概述。第一个模块处理SC和ERC任务,对模型底层的情绪极性标签和顶层的情绪标签进行分类。它捕获了话语中粗粒度和细粒度的情感信息。第二个模块处理我们定义的ES任务,它在架构上类似于Transformer编码器。该模型包含一个自定义注意力机制用于查询情感信息、一个单头自注意力机制以及前馈网络(FFN)。这些模块使模型能够学习语句间的情感转移信息。 模型接收一个连续的语句会话序列 {u₁, …, uₜ, …, uₙ},并最终输出每个任务对应于每个小批量数据的预测值。我们预计,通过多任务学习,模型可以有效学习语句间的情绪转移信息,从而增强其应对情绪识别(ERC)挑战的能力。

3.2.1 ERC和SC任务

为了在ES任务中对应说话者自己的局部和全局单元,我们采用了DialogueCRN中的上下文信息表示模块(Hu et al.,2021)。我们利用两个双向LSTM网络(霍克雷特和施米德胡伯,1997)来分别捕获说话者级别和全局级别的上下文信息。输入ui∈U的维数为d,LSTM的每个方向都隐藏大小为d/2,因此两个方向的总输出维数都为d。

在全局层面上,我们使用了一个两层的双向LSTM网络来捕获对话中连续的相邻话语之间的上下文信息。在全局级别上的上下文表示法计算如下:

在说话者层面上,我们还使用双向LSTM网络来捕获同一说话者相邻话语之间的上下文信息。说话者级的上下文表示的计算方法如下:

基于说话者和全局上下文表示,我们将最终表示oi(emo)定义为它们的连接,随后用于ERC任务的分类。

同时,基于 Chen 等人(2021 年)的研究见解,该研究表明,在多任务学习(MTL)用于提升主任务性能时,引入不同层级的辅助任务是有益的,我们的模型在较低层级实现了一个较粗粒度的分类,这一策略旨在提升模型的性能。

我们使用LSTM网络第一层的输出oi(senti)来进行SC。它计算SC如下:

3.2.2 ES任务

由于我们将ES标签定义为两个ERC标签之间的差异,所以我们将ES任务的输入定义为ERC输入特征之间的差异。ES特征表示的计算方法如下:

我们使用两个类似于Transformer中的编码器的单元(Vaswani et al.,2017)来建模ES任务。在第一个单元的结构中,应用单头注意力机制来学习输入之间的关系,并生成相应的ES表征。在第二单元中,考虑到ES任务与SC任务,我们取代查询向量自注意力机制的输出LSTM层SC任务,目的是让模型试图找到信息相关情感特性表示学习第一单元,并体现这一部分的信息在最后的输出。最后,我们将第一个单元和第二个单元的输出连接起来进行分类。基于整体对话中相邻话语的输入和同一说话者相邻话语的输入,我们还构建了全局级和说话者级模型,并分别计算了全局级和说话者特定的ES。全球级输出o g i(shif t)和扬声器级输出o s i(shif t)的计算过程如下:

3.2.3 多任务学习的训练与预测(MTL)

分类

对于每个任务,我们通过前馈神经网络处理最终的隐藏状态,得到预测的情绪:

训练

我们使用交叉熵损失来训练每个任务:

我们通过将单个任务的损失函数合并为一个单一的全局损失函数来训练我们的多任务学习(MTL)模型。然后利用反向传播的随机梯度下降对MTL模型的组合目标函数进行优化。根据此策略,我们将总损失总额定义如下:

其中,g和s分别代表全局层面和说话者层面的ES任务。为了确认ES和SC任务在ERC任务中的作用,我们假设在我们的多任务学习框架中的每个任务都具有相同的重要性。因此,我们为每个任务分配一个权重为1。这种统一的权重分配确保了在训练过程中所有任务的平衡注意力分散,从而防止任何单个任务以牺牲其他任务为代价主导学习过程。

605

605

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?