声明

不定期更新自己精度论文,通俗易懂,初级小白也可以理解

涉及范围:深度学习方向,包括 CV、NLP、Data Fusion、Digital Twin

论文标题:D2A U-Net: Automatic segmentation of COVID-19 CT slices based on dual attention and hybrid dilated convolution

论文链接:https://doi.org/10.1016/j.compbiomed.2021.104526

论文代码:

发表时间:2021年6月

创新点

1、提出了一种基于双注意策略和混合扩张卷积的新型扩张双注意 U-Net(D2A U-Net)

2、引入了由门注意模块 (GAM) 和解码器注意模块 (DAM) 组成的双重注意策略

Abstract

2019年冠状病毒病(COVID-19)具有较高的传染性和死亡率,已成为全球最紧迫的公共卫生事件之一。计算机断层扫描(CT)是 2019 冠状病毒疾病感染的重要筛查工具,2019 冠状病毒疾病 CT 图像中肺部感染的自动分割有助于患者的诊断和保健。然而,2019 冠状病毒疾病肺部感染的准确和自动分割面临着一些挑战,包括感染边缘模糊和敏感性相对较低。

为了解决上述问题,提出了一种基于双注意策略和混合扩张卷积的新型扩张双注意 U-Net,即D2A U-Net,用于 CT 切片 2019 冠状病毒疾病病变的分割。在我们的 D2A U-Net中,由两个注意模块组成的双注意策略被用于细化特征图,并缩小不同层次特征图之间的语义差距。此外,在模型解码器中引入了混合扩张卷积,以获得更大的接收场,从而优化了解码过程。

该方法在一个开源数据集上进行了评估,骰子得分为 0.7298,召回得分为 0.7071,在语义分割方面优于流行的前沿方法。该网络有望成为一种潜在的人工智能方法,用于 2019 冠状病毒疾病患者的诊断和预后。

Method

本文提出的 D2A U-Net 与原始 U-Net 相比,框架中集成了扩张卷积和注意力机制的新组合,以获得更好的特征表示。

首先,一个门控注意模块被插入到跳过连接的旁边,以利用来自不同级别的特征表示并减少编码器和解码器之间的语义差距;

此外,在模型解码器中引入了另一种融合注意力机制,以在上采样后细化特征图。

---------------------------------------------------------------------------------------------------------------------------------

Dual attention

作者向网络引入了由门注意模块 (GAM) 和解码器注意模块 (DAM) 组成的双重注意策略。利用双重注意策略而不是单一注意模块的,是为了进一步突出感染区域并抑制假阳性。利用 GAM 来完善模型编码器提取的特征,并通过融合高低水平特征图来减少语义差距,从而突出潜在的感染区域并提高新型冠状病毒肺炎感染的敏感性。

---------------------------------------------------------------------------------------------------------------------------------

Gate attention module(GAM)

两个特征图被输入注意力模块。引导信号是指来自模型解码器(或模型编码器中的最后一个卷积块)的特征图,而特征是指馈送到跳过连接的特征图。G 表示引导信号,F 表示特征。

在 U 形网状结构中,与 F 相比,G 包含在通道维度上编码的更深语义信息。利用全局平均池化操作和多层感知 (MLP) 来创建通道注意图 Zc。并且 MLP 的输出大小小于输入大小,这可以抑制通道维度中不相关的特征表示。

---------------------------------------------------------------------------------------------------------------------------------

Decoder attention module(DAM)

作者引入了一个解码器注意力模块,融合注意力机制用于在通道和空间维度上细化后采样特征图

---------------------------------------------------------------------------------------------------------------------------------

Residual attention block(RAB)

RAB 的实际目的是,因为标准卷积很难达到具有固定内核大小的大感受野。传统基于 U-Net 的网络中的这种缺点可能会限制分割性能。因此提出了一个残差注意块(RAB)作为模型解码器中的基本模块。

RAB 的茎是一堆扩张卷积,核大小为 3,扩张率为 [1, 2, 5]。这种扩张率设置获得了更大的感受野,并且还避免了普通扩张卷积的网格效应。

---------------------------------------------------------------------------------------------------------------------------------

Experiments

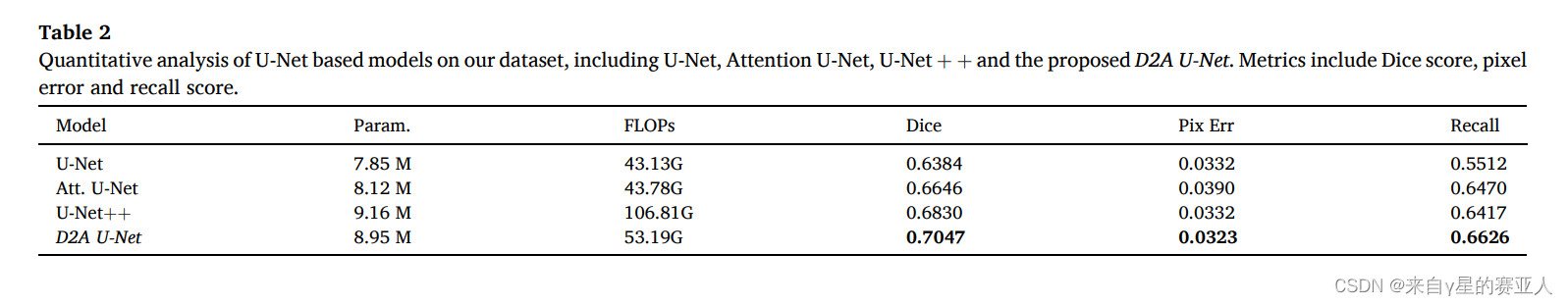

实验目标:对基于 U-Net 的模型进行定量分析

实验结果:D2A U-Net 相关指标最优

实验目标:分割效果

1364

1364

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?