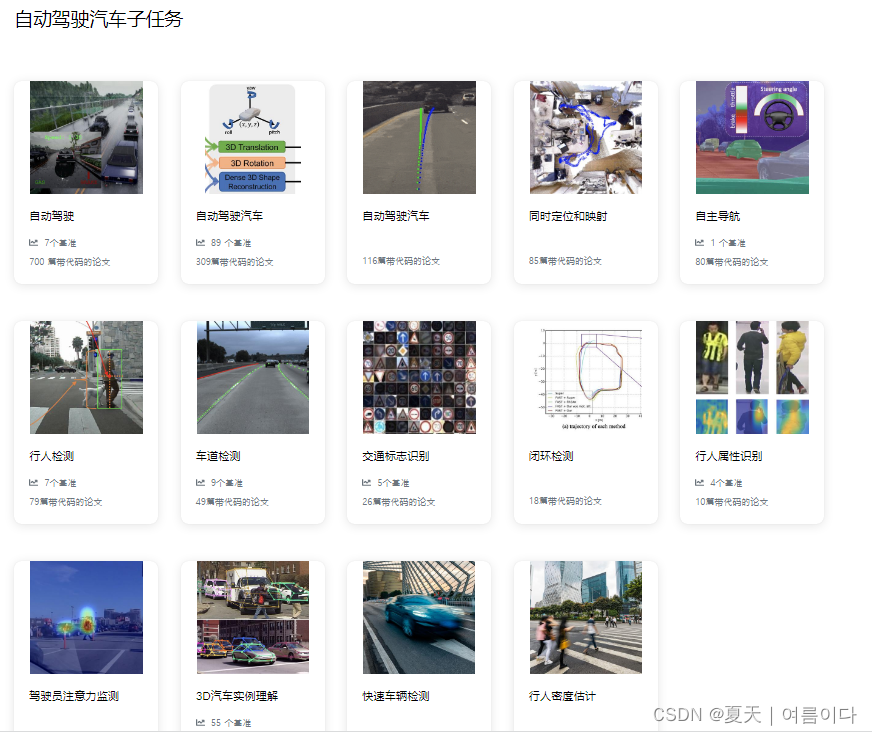

自动驾驶是在没有人类传导的情况下驾驶车辆的任务。自动驾驶是最近汽车公司研究的重要方向,自动驾驶汽车子任务包含了以下几点:

1.算法相关论文

截止2022年7.11号,

1.1.2022.Trajectory-guided Control Prediction for End-to-end Autonomous Driving: A Simple yet Strong Baseline端到端自动驾驶的轨迹引导控制预测:一个简单而强大的基线

论文地址:https://arxiv.org/pdf/2206.08129v1.pdf

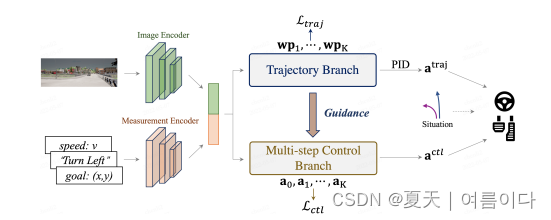

摘要:当前的端到端自动驾驶方法要么根据计划的轨迹运行控制器,要么直接执行控制预测,这已经跨越了两个独立研究的研究方向。看到它们潜在的互惠互利,本文主动探索这两个发达世界的结合。具体来说,我们的综合方法有两个分支,分别用于轨迹规划和直接控制。轨迹分支预测未来轨迹,而控制分支涉及一种新颖的多步预测方案,以便可以推断当前动作和未来状态之间的关系。将两个分支连接起来,使得控制分支在每个时间步都接收到来自轨迹分支的相应引导。然后融合两个分支的输出以实现优势互补。使用 CARLA 模拟器在具有挑战性场景的闭环城市驾驶环境中评估我们的结果。即使使用单目相机输入,所提出的方法也会排名F一世rs吨在官方 CARLA 排行榜上,在具有多个传感器或融合机制的情况下,其表现远远优于其他复杂的候选人。源代码和数据将在 https://github.com/OpenPerceptionX/TCP 上公开。(截止到2022.7.22未公开)

轨迹引导的控制预测(TCP)的概述。编码的特征是由轨迹和多步骤控制分支共享。轨迹分支为多步控制预测提供每步指导。根据我们的情况,两个分支的输出融合方案,生成最终的控制动作。

1.2.2022.Learning from All Vehicles

论文地址:https://arxiv.org/pdf/2203.11934v2.pdf

项目地址:https://github.com/dotchen/LAV

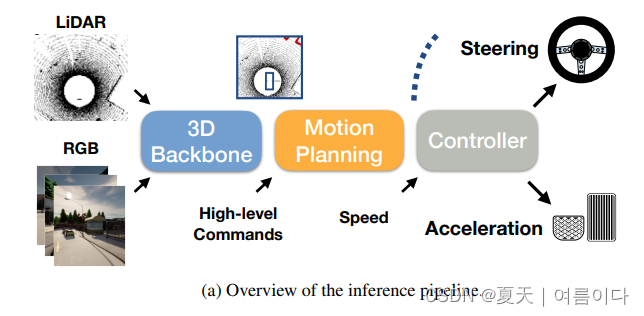

摘要:在本文中,我们提出了一个系统来训练驾驶策略,该系统不仅从自我车辆收集的经验,而且从它观察到的所有车辆中收集。该系统使用其他代理的行为来创建更多样化的驾驶场景,而无需收集额外的数据。向其他车辆学习的主要困难是没有传感器信息。我们使用一组监督任务来学习对控制车辆的观点不变的中间表示。这不仅在训练时提供了更丰富的信号,而且还允许在推理期间进行更复杂的推理。了解所有车辆的驾驶方式有助于预测它们在测试时的行为并避免碰撞。我们在闭环驾驶模拟中评估该系统。我们的系统在公共 CARLA 排行榜上的性能大大优于所有先前的方法,将驾驶分数提高了 25 分,路线完成率提高了 24 分。我们的方法赢得了 2021 年 CARLA 自动驾驶挑战赛。代码和数据可在 https://github.com/dotchen/LAV 获得。

1.3.TransFuser: Imitation with Transformer-Based Sensor Fusion for Autonomous Driving TransFuser:模仿基于变压器的传感器融合用于自动驾驶

论文地址:https://arxiv.org/pdf/2205.15997v1.pdf

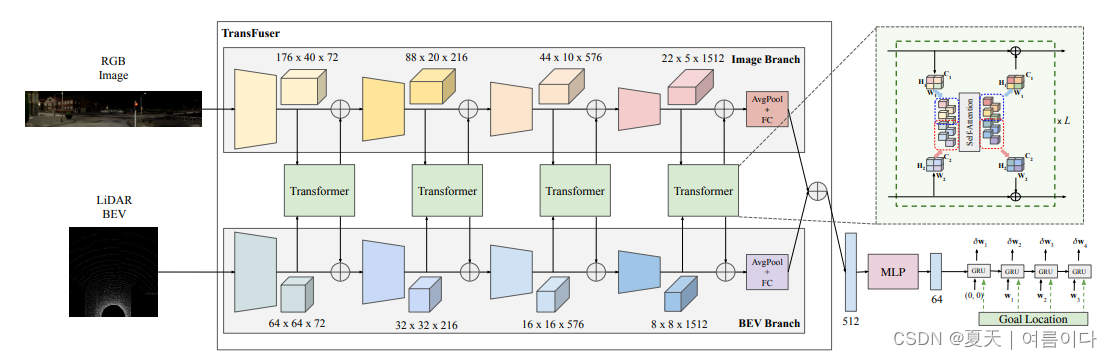

摘要:我们应该如何整合来自互补传感器的表示以用于自动驾驶?基于几何的融合已经显示出感知的前景(例如对象检测、运动预测)。然而,在端到端驾驶的背景下,我们发现基于现有传感器融合方法的模仿学习在具有高密度动态代理的复杂驾驶场景中表现不佳。因此,我们提出了 TransFuser,这是一种使用自注意力集成图像和 LiDAR 表示的机制。我们的方法使用多种分辨率的变压器模块来融合透视图和鸟瞰图特征图。我们在具有挑战性的新基准(具有长路线和密集交通)以及 CARLA 城市驾驶模拟器的官方排行榜上通过实验验证其功效。在提交时,TransFuser 在驾驶分数方面大大优于 CARLA 排行榜上的所有先前工作。与基于几何的融合相比,TransFuser 将每公里的平均碰撞次数减少了 48%。

2。自动驾驶的数据集

2.1.ROAD(ROAD: The ROad event Awareness Dataset for Autonomous Driving)自动驾驶的道路事件意识数据集

ROAD 旨在测试自动驾驶汽车检测道路事件的能力,道路事件定义为由主动代理、其执行的动作和相应的场景位置组成的三元组。ROAD 包含最初来自 Oxford RobotCar 数据集的视频,并带有边界框注释,显示每个道路事件在图像平面中的位置。

2.2.SynWoodScape (Synthetic Surround-view Fisheye Camera Dataset for Autonomous Driving)用于自动驾驶的合成环视鱼眼相机数据集

2.3.AirSim

AirSim是基于虚幻引擎构建的无人机、汽车等模拟器。它是开源的、跨平台的,并支持使用流行的飞行控制器(如 PX4 和 ArduPilot)进行软件在环仿真,以及使用 PX4 进行硬件在环仿真,以实现物理和视觉上的逼真仿真。它是作为一个虚幻插件开发的,可以简单地放入任何虚幻环境中。同样,存在一个 Unity 插件的实验版本。

2.4.CARLA(汽车学习行动)

CARLA(CAR Learning to Act)是一个开放的城市驾驶模拟器,作为 Unreal Engine 4 上的一个开源层而开发。从技术上讲,它的运行方式类似于 Unreal Engine 4 上的一个开源层,以以下形式提供传感器RGB 摄像头(可定制位置)、地面实况深度图、具有 12 个专为驾驶(道路、车道标记、交通标志、人行道等)设计的语义类别的地面实况语义分割图、环境中动态对象的边界框,以及代理本身的测量(车辆位置和方向)。

2.5.Waymo 开放数据集

Waymo 开放数据集由 Waymo Driver 在各种条件下操作的自动驾驶汽车收集的高分辨率传感器数据组成。

Waymo 开放数据集目前包含 1,950 个片段。作者计划在未来增加这个数据集。目前数据集包括:

- 1,950 段,每段 20 秒,在不同的地理和条件下以 10Hz(390,000 帧)收集

- 传感器数据

- 1 个中程激光雷达

- 4 个短程激光雷达

- 5个摄像头(正面和侧面)

- 同步激光雷达和相机数据

- 激光雷达到相机的投影

- 传感器校准和车辆姿态

- 标记数据

- 4 个对象类别的标签 - 车辆、行人、骑自行车者、标志

- 1,200 个分段中的激光雷达数据的高质量标签

- 1260 万个 3D 边界框标签,带有激光雷达数据上的跟踪 ID

- 1000 段相机数据的高质量标签

- 1180 万个 2D 边界框标签,带有相机数据上的跟踪 ID

总结:

自动驾驶数据集将近169个,针对于算法不同,数据集属性不同。

1396

1396

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?