导读

如果说,2020年之前,CV领域的神经网络架构的老大是CNN,大概没有人反驳,但2020年之后,这个世界变了,视觉Transformer的横空出世提供了另一种可能,本文一起回顾视觉Transformer的兴起历程,探讨它与传统卷积神经网络(CNN)的历史地位之争,以及它们在性能上的优劣对比~

什么是Transformer架构?

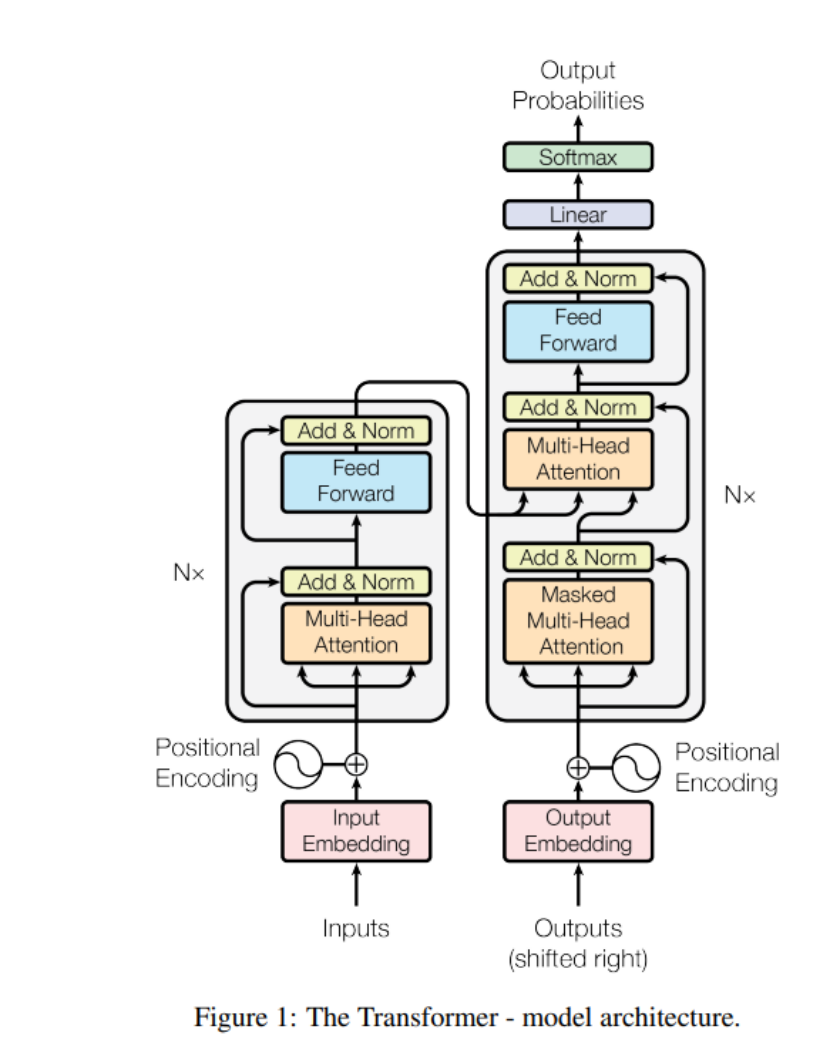

Transformer架构自从2017年在论文《Attention Is All You Need》中被提出以来,就在自然语言处理(NLP)领域引起了巨大的轰动。Transformer架构的核心在于它完全基于注意力机制,摒弃了之前常用的循环神经网络(RNN)结构,使得模型能够并行处理序列数据,大大提高了训练效率。

那么,什么是注意力机制呢?此前,我们介绍过注意力机制的内容

**简单来说,注意力机制就是一种资源分配方案,它让模型能够聚焦于输入序列中的关键部分,而忽略其他不那么重要的信息。**就像我们人类在阅读时,会自动关注那些重要的单词或短语一样。在深度学习中,注意力机制通过计算序列中各个元素的重要性,来增强模型对关键信息的捕捉能力。

在Transformer架构中,自注意力机制被广泛应用。自注意力允许模型在处理序列时,不仅关注当前元素,还能考虑到序列中其他元素的影响。这种全局的视角使得Transformer在处理长距离依赖问题时表现得尤为出色。自注意力通过计算序列中每个元素对其他元素的关注度,来更新每个元素的表示,从而捕捉到更丰富的上下文信息。

什么是****视觉Transformer?

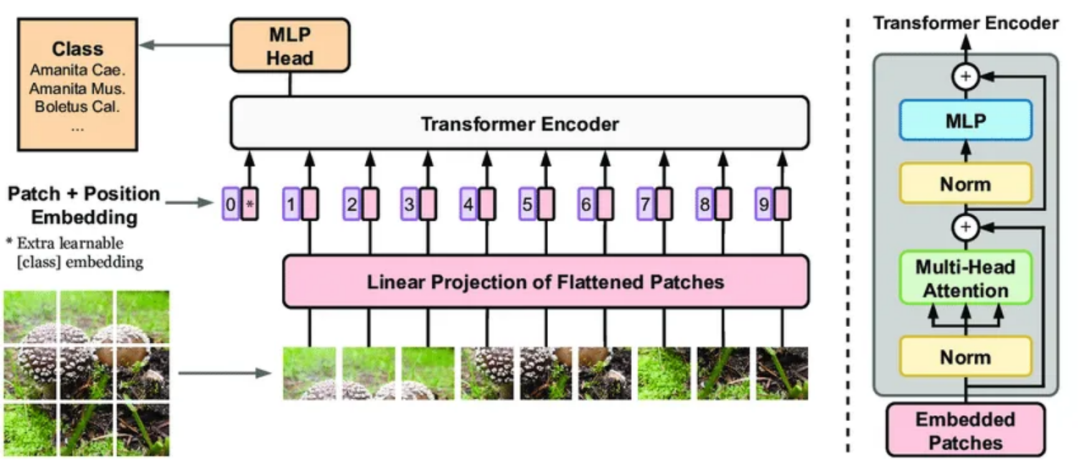

视觉Transformer(ViT),怎么火起来的呢?**ViT的起源可以追溯到2020年,那时候谷歌的研究团队发表了一篇论文,提出了Vision Transformer(ViT),这个模型首次将Transformer架构应用在图像识别任务上。**ViT的出现,可以说是给计算机视觉领域带来了一场革命,因为它证明了Transformer不仅在NLP任务中有效,在视觉任务中也能大放异彩。

视觉Transformer之所以能够火起来,有几个关键的技术突破不得不提。首先,ViT通过将图像分割成小块(patches),然后像处理序列数据一样处理这些图像块,使得模型能够捕捉到图像中的全局特征。这种全局视角是CNN所不具备的。其次,ViT的自注意力机制让它在处理长距离依赖问题时表现得尤为出色,这对于理解图像的整体结构非常有帮助。这些技术突破让ViT在多个视觉任务上取得了优异的性能,比如图像分类、目标检测和语义分割等。

Transformer架构与视觉Transformer的区别

1、 输入数据的差异

**Transformer架构最初是为处理序列数据而生的,比如自然语言处理中的文本。**在NLP中,输入通常是一系列词汇或句子,这些数据具有天然的序列特性,比如句子中的单词顺序。**而视觉Transformer(ViT)则需要处理的是图像数据,这就需要将图像转换为能够被Transformer处理的序列形式。**具体来说,ViT通过将图像分割成多个小块(patches),然后将这些小块视为序列中的元素,这样就可以利用Transformer处理序列数据的能力来处理图像了。这种从处理序列到处理图像的转变,是Transformer架构在视觉领域的一个重要创新。

3.2 架构设计的异同

虽然Transformer架构和视觉Transformer都依赖于自注意力机制,但在架构设计上存在一些差异。在标准的Transformer架构中,编码器和解码器是核心组成部分,它们通过自注意力层和前馈神经网络(FFN)层来处理序列数据。

而在视觉Transformer中,由于输入数据的特性不同,通常只使用编码器部分,而不需要解码器。ViT通过在编码器中堆叠多个自注意力层和FFN层来提取图像特征,这一点与传统的Transformer架构是相似的。不同之处在于,ViT需要额外的位置编码来保留图像块的空间信息,因为图像块本身并不包含位置信息,而文本序列中的词汇顺序则隐含了位置信息。

3.3 应用场景的不同

Transformer架构和视觉Transformer的应用场景也有所不同。Transformer架构最初在NLP领域大放异彩,被广泛应用于机器翻译、文本摘要、问答系统等任务。而视觉Transformer则在计算机视觉领域崭露头角,特别是在图像分类、目标检测、语义分割等任务中表现出色。ViT的成功应用,证明了Transformer架构的灵活性和强大的特征提取能力,使其能够跨越不同的数据模态,从文本到图像,都能发挥出色的性能。这种跨领域的应用能力,是Transformer架构区别于传统CNN的一个显著特点。

视觉Transformer与CNN的比较

咱们得承认,**卷积神经网络(CNN)在计算机视觉领域可是有着举足轻重的地位。**自从1990年代LeNet-5模型的出现,CNN就开始在图像识别、目标检测等任务上崭露头角。尤其是2012年,AlexNet在ImageNet竞赛中的突破性胜利,更是让CNN成为了计算机视觉的主流架构。多年来,CNN在各种视觉任务上都取得了令人瞩目的成绩,可以说是深度学习时代的“老大哥”了。

但是,随着视觉Transformer(ViT)的兴起,CNN的地位似乎受到了挑战。ViT的出现,标志着Transformer架构开始在计算机视觉领域占据一席之地。ViT利用自注意力机制,能够捕捉图像中的长距离依赖关系,这对于理解图像的整体结构非常有帮助。而且,ViT的并行处理能力也使其在训练效率上具有优势。这些特点让ViT在多个视觉任务上取得了与CNN相媲美甚至更优的性能,从而对CNN的统治地位构成了威胁。

**那么,视觉Transformer和CNN到底孰优孰劣呢?**咱们得从几个方面来看。

首先,**ViT在捕捉全局特征和长距离依赖方面确实比CNN有优势,这使得它在处理复杂视觉任务时更加灵活。**其次,ViT的并行处理能力也让它在训练速度上更胜一筹。

但是,ViT的缺点也很明显,比如对计算资源的需求较大,尤其是在处理大规模图像数据时。此外,ViT在捕捉局部细节方面可能不如CNN,因为它缺乏CNN的局部感受野。

相比之下,CNN虽然在全局特征捕捉上不如ViT,但它的局部感受野使其在捕捉局部特征方面有着天然的优势。而且,CNN的计算效率相对较高,对于资源受限的环境更为友好。

总的来说,ViT和CNN,选择哪种架构还需要根据具体的应用场景和需求来决定。不过,随着研究的不断深入,ViT的潜力正在被逐渐挖掘,未来它可能会在更多的视觉任务中发挥重要作用。

**展望未来,ViT和CNN的发展趋势值得关注。**对于ViT,未来的研究可能会集中在如何降低其对计算资源的需求,以及如何提高其在捕捉局部细节方面的能力。此外,自监督学习和多模态学习可能是ViT未来发展的重要方向,这将使得ViT能够在更少标注数据的情况下学习,并且能够处理来自不同模态的信息。

对于CNN,未来的研究可能会集中在如何进一步提高其全局特征捕捉能力,以及如何结合ViT的优势来构建混合模型。这种混合模型可能会结合CNN的局部特征捕捉能力和ViT的全局特征捕捉能力,从而在各种视觉任务中取得更好的性能。

总的来说,ViT和CNN各有优劣,未来的研究可能会更多地集中在如何结合两者的优势,以及如何在特定的应用场景中选择或设计最合适的模型架构。随着深度学习技术的不断进步,我们可以期待在未来看到更多创新的模型和方法。

如何学习AI大模型 ?

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。【保证100%免费】🆓

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

👉1.大模型入门学习思维导图👈

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过AI大模型的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。(全套教程文末领取哈)

👉2.AGI大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。

👉3.大模型实际应用报告合集👈

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(全套教程文末领取哈)

👉4.大模型落地应用案例PPT👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(全套教程文末领取哈)

👉5.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(全套教程文末领取哈)

👉6.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(全套教程文末领取哈)

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?