@article{liu2023coconet,

title={Coconet: Coupled contrastive learning network with multi-level feature ensemble for multi-modality image fusion},

author={Liu, Jinyuan and Lin, Runjia and Wu, Guanyao and Liu, Risheng and Luo, Zhongxuan and Fan, Xin},

journal={International Journal of Computer Vision},

pages={1–28},

year={2023},

publisher={Springer}

}

论文级别:SCI A2

影响因子:19.5

文章目录

📖论文解读

作者提出了一种耦合对比学习网络CoCoNet,这是一个【通用】的图像融合网络。

使用耦合对比学习来指导模型区分目标以及纹理细节,并且采用了一种测量机制来计算源图像的比例重要性,以生成数据驱动的权重并应用于损失函数之中。

🔑关键词

image fusion, infrared and visible image, unsupervised learning, contrastive learning

图像融合,红外和可见光图像,无监督学习,对比学习

💭核心思想

保持互补信息,消除冗余信息。

使用数据驱动机制计算信息保留度,以提高融合结果和源图像强度和细节的一致性。

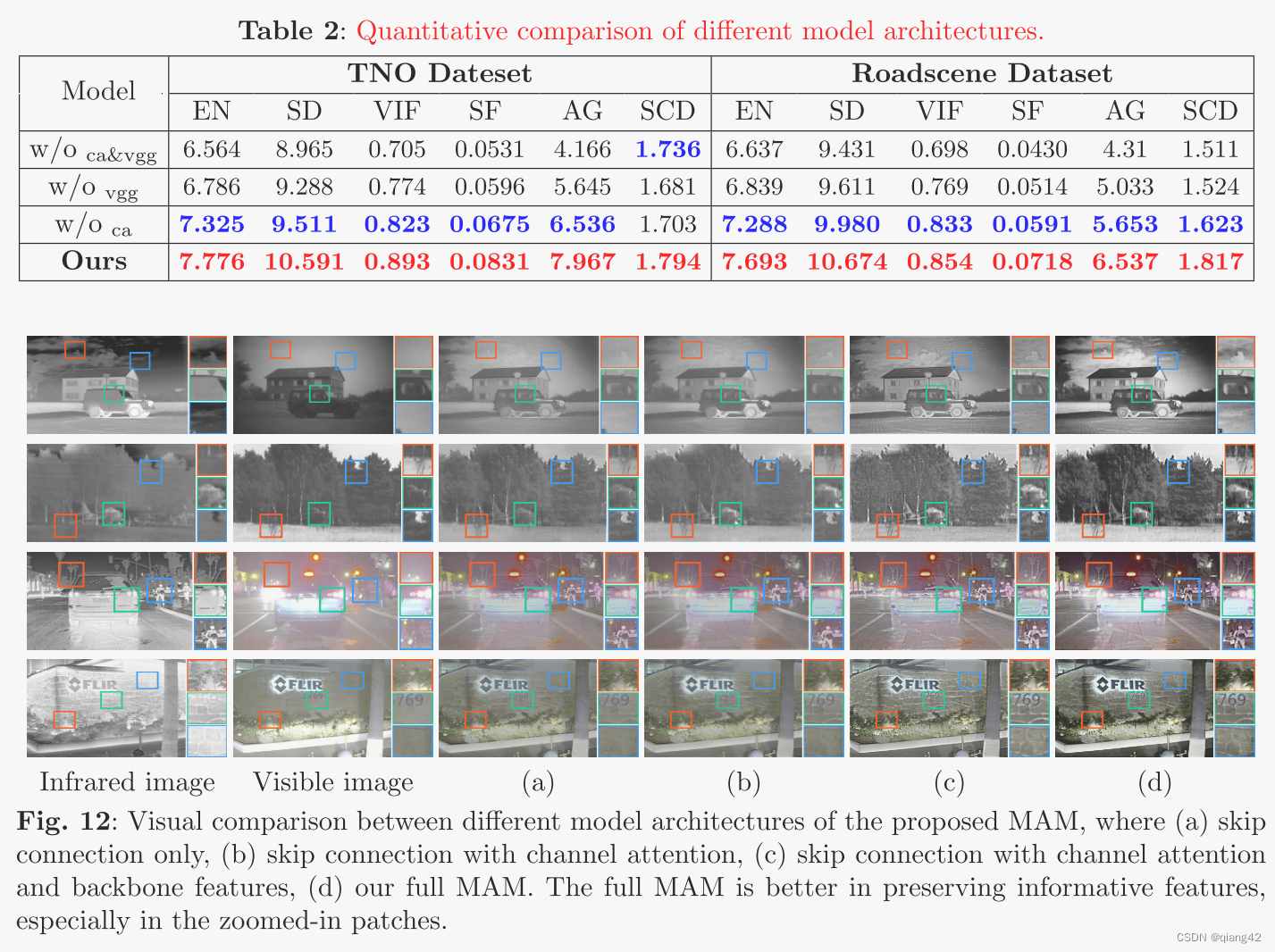

使用多级注意力模块(multi-level attention module ,MAM)避免融合过程中的特征退化。

🪢网络结构

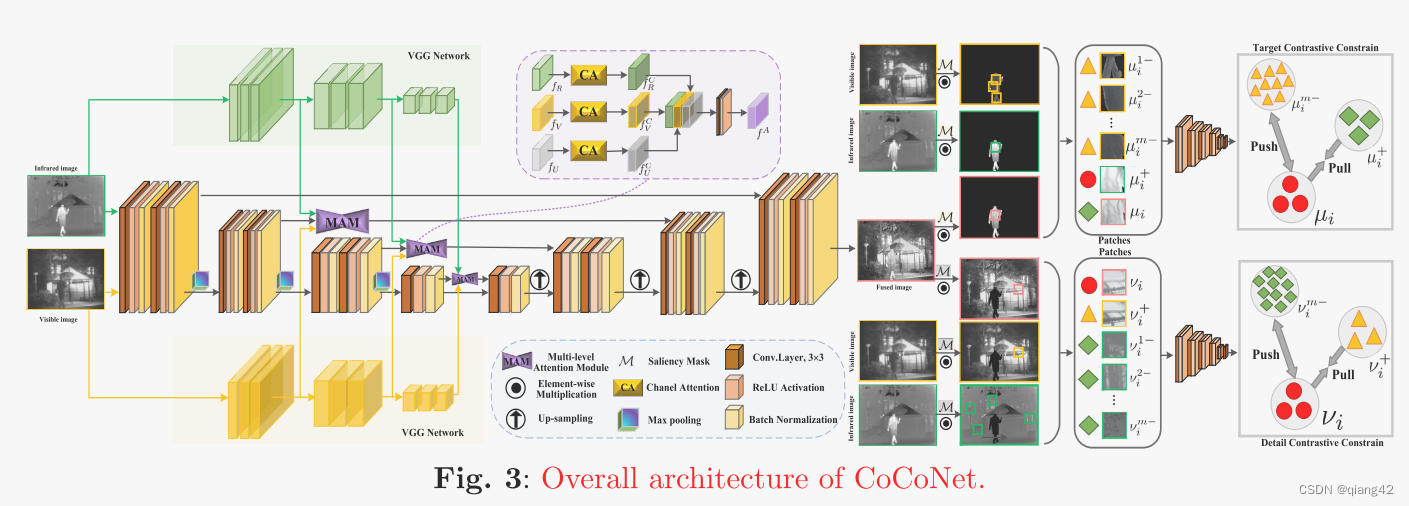

作者提出的网络结构如下所示。

C

A

(

⋅

)

CA(·)

CA(⋅)是通道注意力

🪢耦合对比学习

作者的思路是,将红外图像的显著目标作为正样本,将可见光图像的显著目标作为负样本;同理,将可见光图像的的背景作为正样本,红外图像背景作为负样本。

基于TNO数据集人工标注掩膜,设

M

\mathcal M

M为前景的显著掩膜,

M

ˉ

\bar {\mathcal M}

Mˉ为背景的显著掩膜。

红外图像×前景掩膜可以得到显著目标,可见光图像×背景掩膜得到了背景信息。

作者选用预训练VGG-19代表G,将此处的损失函数定义为:

N和M分别为每个正样本的VGG层数和负样本数。

μ

i

\mu_i

μi代表融合图像的前景特征

G

i

(

I

F

⊙

M

)

G_i(I_F\odot \mathcal M)

Gi(IF⊙M)

μ

i

+

\mu_i^+

μi+和

μ

i

m

−

\mu_i^{m-}

μim−分别是正样本和负样本,

μ

i

+

=

G

i

(

I

R

⊙

M

)

\mu_i^+=G_i(I_R\odot \mathcal M)

μi+=Gi(IR⊙M)

μ

i

m

−

=

G

i

(

I

V

m

⊙

M

)

\mu_i^{m-}=G_i(I_V^m \odot \mathcal M)

μim−=Gi(IVm⊙M)

m

m

m代表第m个负样本,

∣

∣

⋅

∣

∣

1

||·||_1

∣∣⋅∣∣1是L1范数。

同理,在背景部分,将可见光图像背景作为正样本,红外图像背景作为负样本。细节约束的目标函数为:

v

i

v_i

vi代表融合图像的背景特征

G

i

(

I

F

⊙

M

ˉ

)

G_i(I_F\odot \bar {\mathcal M})

Gi(IF⊙Mˉ)

v

i

+

v_i^+

vi+和

v

i

m

−

v_i^{m-}

vim−分别是正样本和负样本,

v

i

+

=

G

i

(

I

V

m

⊙

M

ˉ

)

v_i^+=G_i(I_V^m \odot \bar {\mathcal M})

vi+=Gi(IVm⊙Mˉ)

v

i

m

−

=

G

i

(

I

R

⊙

M

ˉ

)

v_i^{m-}=G_i(I_R \odot \bar {\mathcal M})

vim−=Gi(IR⊙Mˉ)

📉损失函数

自适应损失函数=结构损失+强度损失

以往的方法,权重参数都是手工设计的经验值,本文作者设计了一种考虑数据特性的自适应损失。

一方面,为了保留纹理细节,采用平均梯度法(AG)优化SSIM损失的权重参数

σ

\sigma

σ

∇

h

I

F

{\nabla _h}{I_F}

∇hIF和

∇

v

I

F

{\nabla v}{I_F}

∇vIF分别代表融合图像从水平方向和垂直方向的一阶微分(梯度)

另一方面,采用图像熵(EN)更新强度损失:

L

L

L代表给定图像的灰度值,

p

x

p_x

px像素处于对应灰度值的概率。

EN是像素级计算的图像信息量,与MSE约束密切相关,因为MSE约束也是像素级的约束。

综上,损失函数为

L

i

r

\mathcal L_{ir}

Lir和

L

v

i

s

\mathcal L_{vis}

Lvis是两对对比损耗。

🔢数据集

图像融合数据集链接

[图像融合常用数据集整理]

🎢训练设置

🔬实验

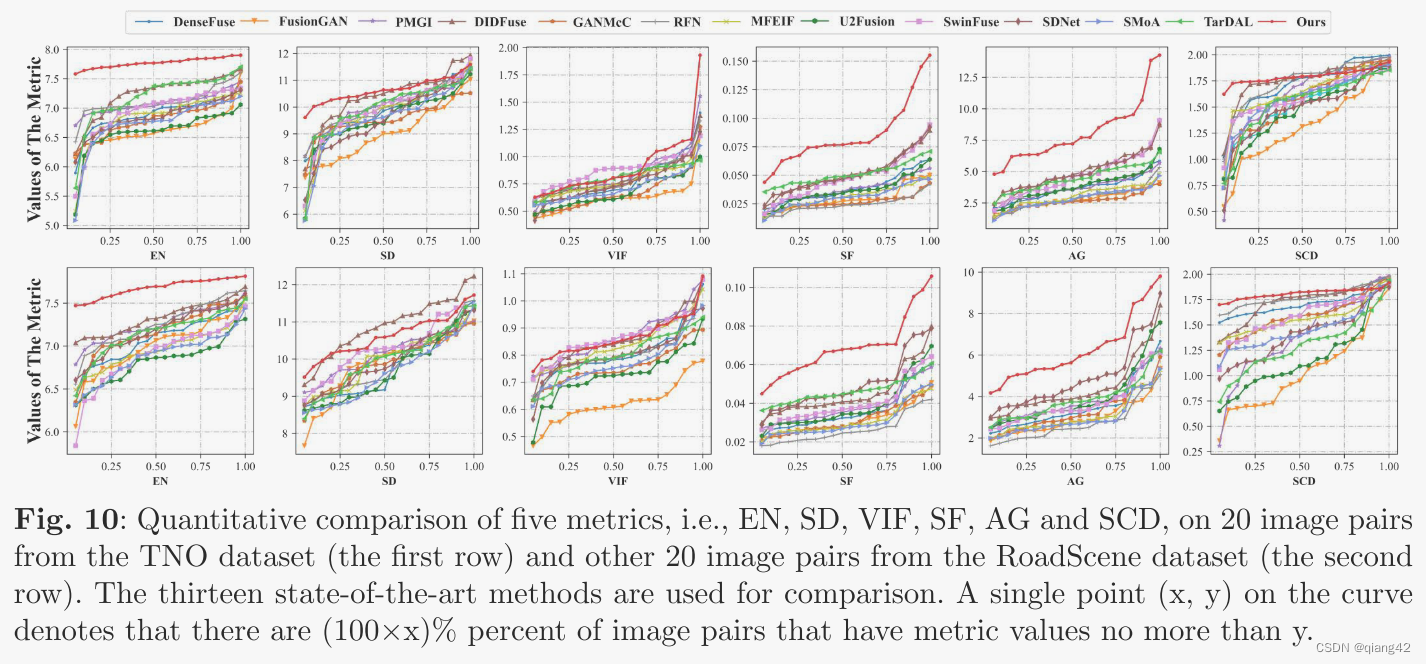

📏评价指标

- EN

- AG

- SF

- SD

- SCD

- VIF

参考资料

[图像融合定量指标分析]

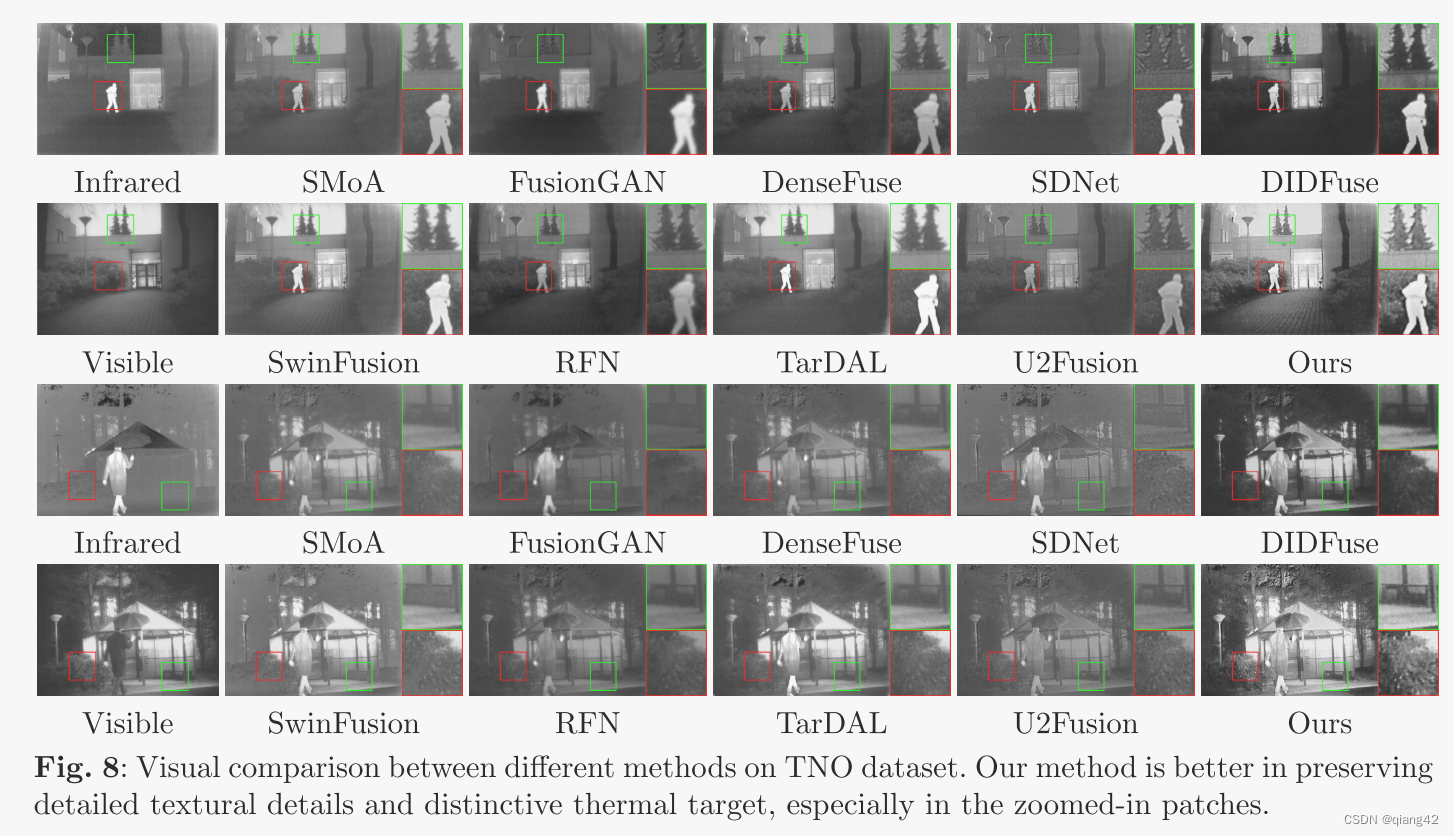

🥅Baseline

- VIF

- SMoA,FusionGAN, DenseFuse,SDNet,DIDFuse ,SwinFusion,RFN,TarDAL,U2Fusion

✨✨✨参考资料

✨✨✨强烈推荐必看博客[图像融合论文baseline及其网络模型]✨✨✨

🔬实验结果

更多实验结果及分析可以查看原文:

📖[论文下载地址]

🚀传送门

📑图像融合相关论文阅读笔记

📑[LRRNet: A Novel Representation Learning Guided Fusion Network for Infrared and Visible Images]

📑[(DeFusion)Fusion from decomposition: A self-supervised decomposition approach for image fusion]

📑[ReCoNet: Recurrent Correction Network for Fast and Efficient Multi-modality Image Fusion]

📑[RFN-Nest: An end-to-end resid- ual fusion network for infrared and visible images]

📑[SwinFuse: A Residual Swin Transformer Fusion Network for Infrared and Visible Images]

📑[SwinFusion: Cross-domain Long-range Learning for General Image Fusion via Swin Transformer]

📑[(MFEIF)Learning a Deep Multi-Scale Feature Ensemble and an Edge-Attention Guidance for Image Fusion]

📑[DenseFuse: A fusion approach to infrared and visible images]

📑[DeepFuse: A Deep Unsupervised Approach for Exposure Fusion with Extreme Exposure Image Pair]

📑[GANMcC: A Generative Adversarial Network With Multiclassification Constraints for IVIF]

📑[DIDFuse: Deep Image Decomposition for Infrared and Visible Image Fusion]

📑[IFCNN: A general image fusion framework based on convolutional neural network]

📑[(PMGI) Rethinking the image fusion: A fast unified image fusion network based on proportional maintenance of gradient and intensity]

📑[SDNet: A Versatile Squeeze-and-Decomposition Network for Real-Time Image Fusion]

📑[DDcGAN: A Dual-Discriminator Conditional Generative Adversarial Network for Multi-Resolution Image Fusion]

📑[FusionGAN: A generative adversarial network for infrared and visible image fusion]

📑[PIAFusion: A progressive infrared and visible image fusion network based on illumination aw]

📑[CDDFuse: Correlation-Driven Dual-Branch Feature Decomposition for Multi-Modality Image Fusion]

📑[U2Fusion: A Unified Unsupervised Image Fusion Network]

📑综述[Visible and Infrared Image Fusion Using Deep Learning]

📚图像融合论文baseline总结

📑其他论文

📑[3D目标检测综述:Multi-Modal 3D Object Detection in Autonomous Driving:A Survey]

🎈其他总结

🎈[CVPR2023、ICCV2023论文题目汇总及词频统计]

✨精品文章总结

✨[图像融合论文及代码整理最全大合集]

✨[图像融合常用数据集整理]

如有疑问可联系:420269520@qq.com;

码字不易,【关注,收藏,点赞】一键三连是我持续更新的动力,祝各位早发paper,顺利毕业~

988

988

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?