论文作者:Yujin Wang,Lingen Li,Tianfan Xue,Jinwei Gu

作者单位:Shanghai Artificial Intelligence Laboratory;The Chinese University of Hong Kong

论文链接:http://arxiv.org/abs/2309.10714v1

内容简介:

1)方向:图像去噪

2)应用:图像去噪

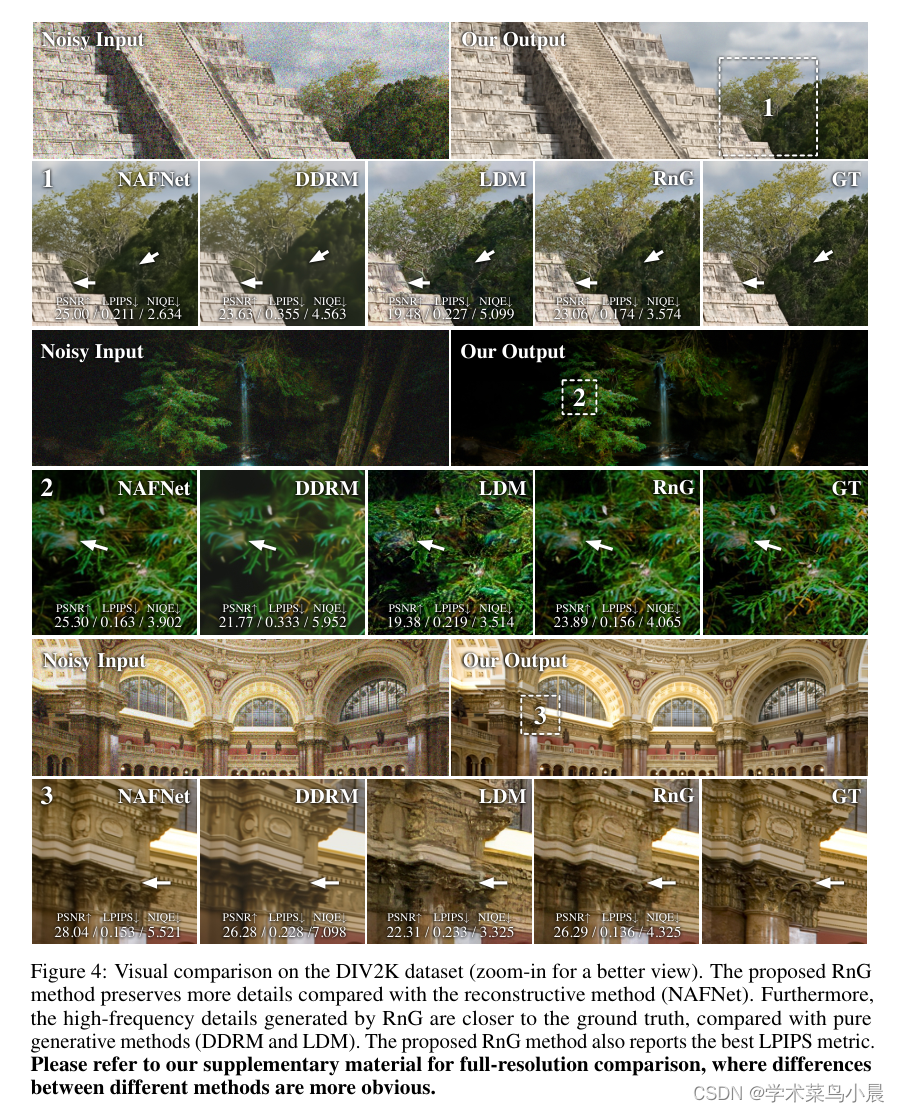

3)背景:传统的监督式去噪方法通常从嘈杂输入中学习重构干净图像,但这些方法存在固有的频谱偏差,容易产生过度平滑和模糊的图像。近年来,研究人员尝试了扩散模型来在图像恢复任务中生成高频细节,但这些模型不能保证生成的纹理与真实图像对齐,导致了不可取的伪影。

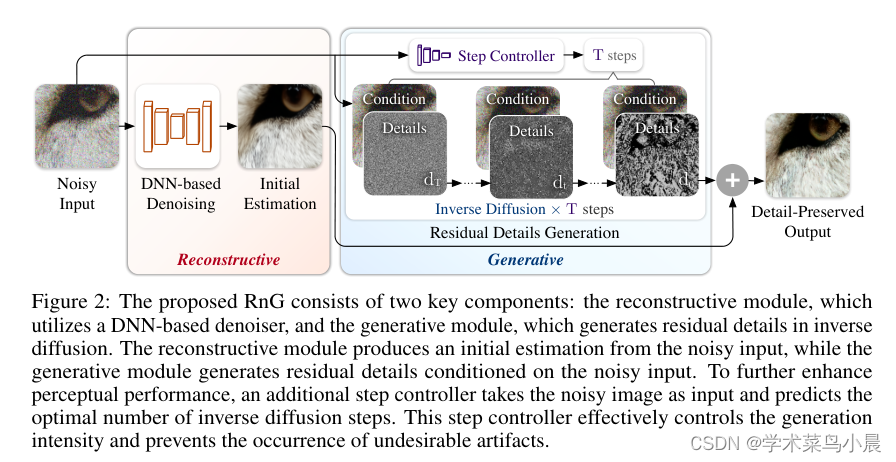

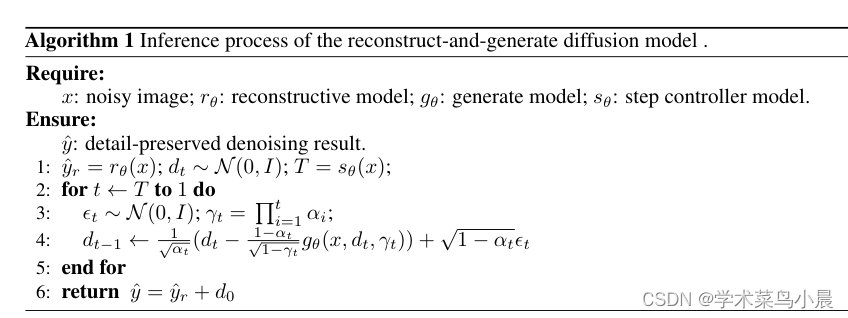

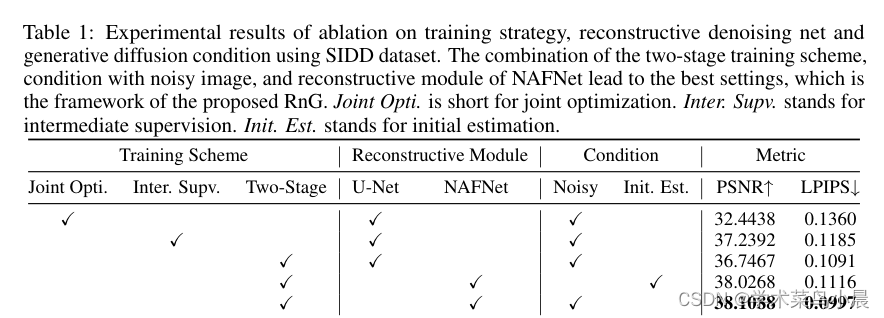

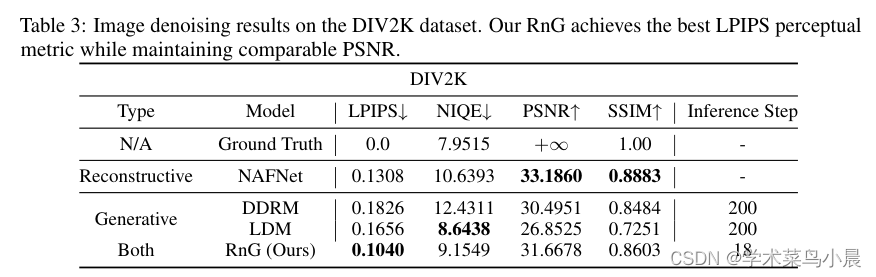

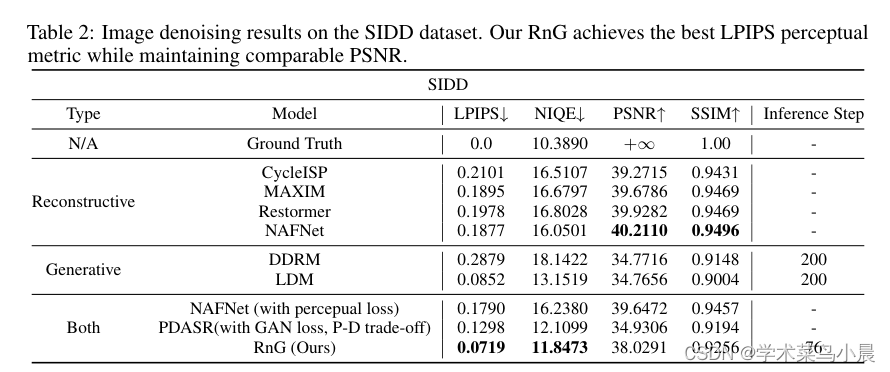

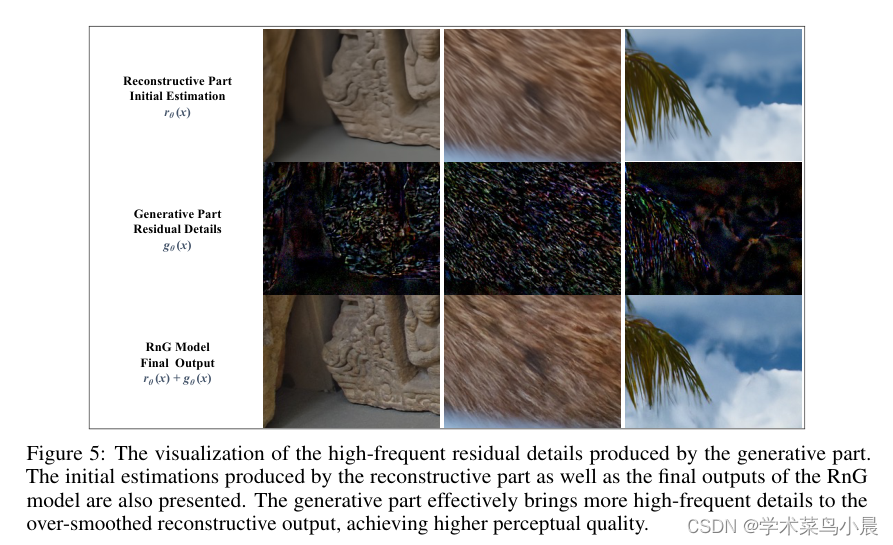

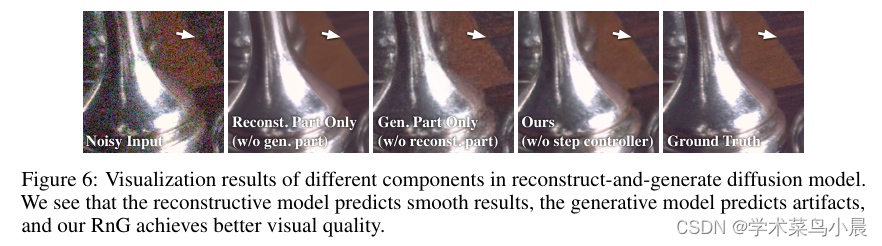

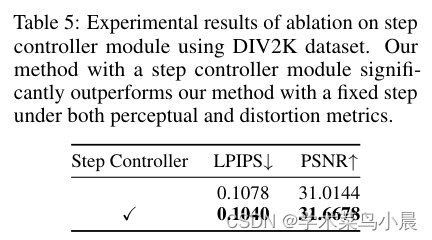

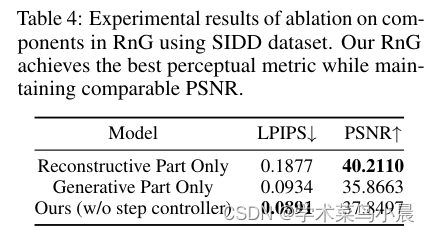

4)方法:本文提出了一种名为“Reconstruct-and-Generate Diffusion Model (RnG)”的新方法。该方法利用了一个重建去噪网络来恢复大部分干净信号,作为后续步骤的初始估计,以保持保真度。此外,它采用扩散算法生成残余的高频细节,从而增强了视觉质量。研究还引入了一个两阶段训练方案,以确保RnG的重建和生成模块之间有效地协作。为了减少扩散模型引入的不良纹理,研究还提出了一个自适应步骤控制器,调节扩散模型应用的反向步数,从而控制每个块中添加的高频细节的水平,并节省推断的计算成本。

5)结果:通过提出的RnG方法,研究取得了在视觉感知和失真之间的更好平衡。在合成和实际的去噪数据集上进行了广泛的实验证明,验证了该方法的优越性。

1897

1897

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?