转

置

卷

积

不

是

卷

积

的

逆

运

算

转置卷积不是卷积的逆运算

转置卷积不是卷积的逆运算

1.转置卷积(反卷积):能增大输入的高和宽

nn.Conv2DTranspose

为什么称之为“转置”?(从形状上是逆变换)

●对于卷积Y=X★W,可以对W构造一个V,使得卷积等价于矩阵乘法Y’= VX’(撇代表flatten 拉平操作,这里Y’,X’是Y,X对应的向量版本)。

转置卷积则等价于Y’= vTX’

●如果卷积将输入从(h,w)变成了(h’,w),同样超参数的转置卷积则从(h’, w’)变成(h, w)

注:填充和步幅的情况省略

ZFNet中的反卷积

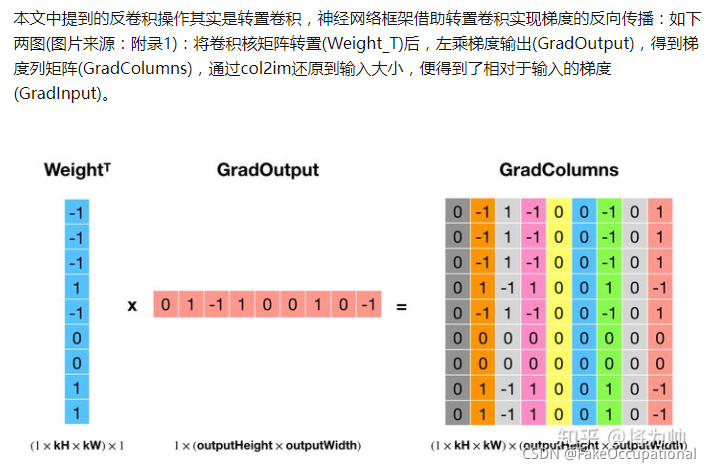

如下图:卷积操作是低效操作,主流神经网络框架都是通过im2col+矩阵乘法实现卷积,以空间换效率。

2.ZFNet

使用了解卷积和反池化(无法实现,只能近似)的近似对每一层进行可视化

彩 色 图 是 从 原 始 数 据 集 中 找 出 的 , 能 够 使 得 特 定 层 的 某 些 卷 积 核 激 活 最 大 的 9 张 图 灰 色 图 是 由 彩 色 图 重 建 得 到 的 可 视 化 结 果 底 层 网 络 : 边 缘 , 颜 色 , 中 层 网 络 : 形 状 , 高 层 网 咯 : 物 体 彩色图是从原始数据集中找出的,能够使得特定层的某些卷积核激活最大的9张图\\ 灰色图是由彩色图重建得到的可视化结果 \\底层网络:边缘,颜色, 中层网络:形状, 高层网咯:物体 彩色图是从原始数据集中找出的,能够使得特定层的某些卷积核激活最大的9张图灰色图是由彩色图重建得到的可视化结果底层网络:边缘,颜色,中层网络:形状,高层网咯:物体

在训练的过程中,随着卷积核的变化( 不同层重构的变化)

卷积核可视化:

遮挡与识别结果:

狗这一类别不同部位的相似性是否隐式定义(不同部位对网络结果的影响)

去掉某些层数:

迁移学习效果更好:

FCN

首 个 端 到 端 全 卷 积 像 素 级 分 类 网 络 首个端到端全卷积像素级分类网络 首个端到端全卷积像素级分类网络

最

后

重

构

的

图

片

有

k

个

通

道

,

k

为

类

别

的

个

数

,

即

每

个

像

素

都

有

一

个

类

别

最后重构的图片有k个通道,k为类别的个数,即每个像素都有一个类别

最后重构的图片有k个通道,k为类别的个数,即每个像素都有一个类别

3777

3777

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?