本文转载自此微信推送,作者即博主

0、为什么需要数据集与仿真器?

在研究中,为了比较不同算法的优劣,研究人员不能用自己采集的数据,这样和别的方法比较没有太大的意义。所以公开的数据集是评价这些方法的通用数据。而仿真器,是按照事件相机的成像原理,模拟其生成数据的样子,可以便于使用者采集自己想要的数据。

当然最重要的一点,是事件相机目前价格较高,许多人无法像买USB相机这样随性购买。下面我们简单看几家公司的商品和售价:

(图:一些事件相机厂商的主流产品与价格,数据由个人业务咨询获得)

可以看到一款事件相机动辄几万。所以数据集和仿真器可以极大程度方便研究的进行,同时避免了硬件使用过程中的各种各样的问题。

1、数据集

在github官网整理出了许多数据集,更多细节请参考网址:https://github.com/uzh-rpg/event-based_vision_resources#datasets。包括的数据集有:光流、图像恢复、VO与SLAM、图像分割、图像识别等。下面介绍一些围绕SLAM的数据集。

ViViD: Vision for Visibility Dataset

提供Lidar,RGBD,EB,IMU等数据,室内:光照亮好/局部光照/没有光照+稳定运动/不稳定运动/极其不稳定运动,室外:白天/夜间,标定等数据,下载需要申请。

UZH-FPV Drone Racing Dataset

FPV飞机拍摄的室内/室外高速运动的场景

VSEC: The Multi Vehicle Stereo Event Camera Dataset: An Event Camera Dataset for 3D Perception, 2018

车载传感器,道路场景,配合有lidar/IMU等传感器,同时是少见的双目事件相机数据

DDD17: DAVIS Driving Dataset 2017

车辆驾驶场景,高速路,包括速度/GPS等多种传感器数据;

DDD17+: 未发布,在准备论文。比DDD17多一些数据量。

伴随论文“Event-based, Direct Camera Tracking from a Photometric 3D Map using Nonlinear Optimization”公开的数据,主要为室内场景,包括EB和RGBD,IMU。除此之外,还有少量的仿真和模拟数据。同时也是Gallego等人在PAMI 2018发表的Event-Based, 6-DOF Camera Tracking from Photometric Depth Maps论文使用的数据集

(图:DAVIS 240C Datasets部分数据。提供text和rosbag两种格式)

这里重点介绍一款SLAM数据集,DAVIS 240C Datasets,伴随论文“The Event-Camera Dataset and Simulator: Event-based Data for Pose Estimation, Visual Odometry, and SLAM”公开的数据集。

包括室内/室外/办公室/盒子/几何形状/室外行走/旋转等多段数据,个人认为是较为合适的通用场景的数据集,也是后续许多事件相机所采用的数据集,被后面的论文中描述为:introduced as a benchmark for event-based visual (inertial) odometry。同时里面的仿真器,是仿真器ESIM的早期工作(采用的是高速定频采样)。而ESIM采用了根据变化速率改变采样速率的方式,更加贴近真实情况(详见第3节和相关论文)。主要提供了两种数据格式:便于ROS下运行的.bag格式,与更普遍的.zip文件(包含最基础的数据event和image数据)。官方链接:http://rpg.ifi.uzh.ch/davis_data.html

2、数据集的运行

这里介绍两款数据集运行的软件,基于java环境的jAER与基于ROS环境的rpg_dvs_ros。

jAER

jAER是基于java环境的一款软件,可以读取一些格式的数据集,安装配置需要安装java的运行环境,同时支持windows和linux。我个人尝试配置,总是会遇到各种问题,无论是windows还是linux都没配置成功。不建议使用。如感兴趣请访问:github:https://github.com/SensorsINI/jaer

rpg_dvs_ros

这个是ETH的Robotic and Perception Group开发的ROS环境下的运行软件,可以配套运行ETH许多开源的代码,感觉做得还算不错,可以考虑安装使用。具体安装方法参考github即可:https://github.com/uzh-rpg/rpg_dvs_ros

注意一点,ubuntu18安装的ROS为melodic,在执行上述链接的指令时,需要将catkin config这一句进行替换,否则可能会遇到问题。具体的替换内容参考了rpg_esim的wiki:https://github.com/uzh-rpg/rpg_esim/wiki/Installation-(ROS-Melodic)

3、仿真器

仿真器是“模拟事件相机生成数据方式”的软件,既然是模拟,那肯定与真实的不一样,但好歹可以尽可能的像。这里大力推荐ETH的ESIM。ESIM也是基于ROS环境。

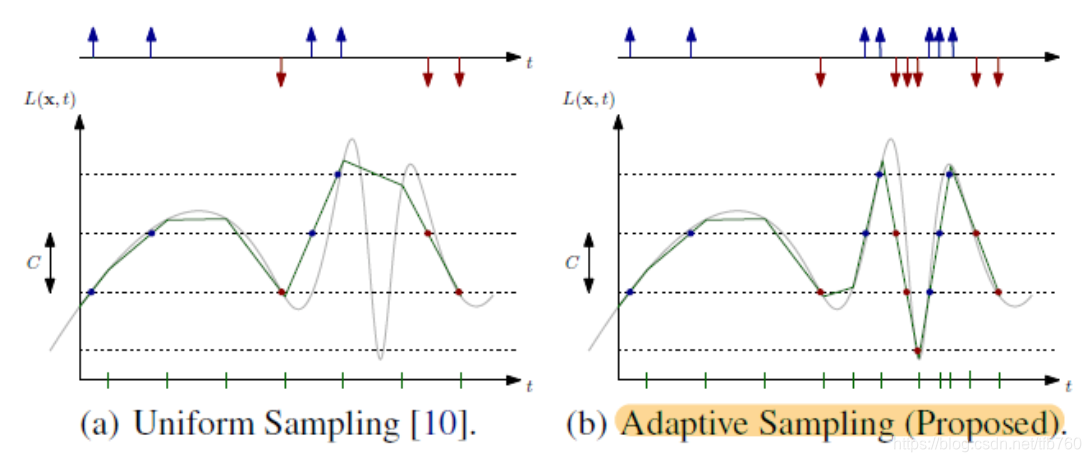

(图:(a)之前仿真器采集原理vs (b)ESIM采集原理。ESIM采用自适应采用方式采集数据,使变化速度快的时刻采样快,尽可能的保证了数据不丢失)

ESIM的源码,参考github:https://github.com/uzh-rpg/rpg_esim

安装过程也参考github上的wiki即可:https://github.com/uzh-rpg/rpg_esim/wiki/Installation

(图:ESIM仿真器运行环境)

除此之外,补充介绍两个仿真器,但不推荐使用。

一个是2012年的论文“Live demonstration: Behavioural emulation of event-based vision sensors”中提出的一款实时将USB相机数据转化为事件数据的仿真器,鉴于时间较早,不建议首先使用。

其次是“Interiornet: Mega-scale multi-sensor photo-realistic indoor scenes dataset”中构建的仿真器,这个仿真器极其强大,创建了上万种真实场景的三维模型,能够生成单目、双目、RGBD、事件相机等多种数据,但毕竟不是专业做事件相机的仿真器,随便看看就好。

4、结语

ETH做了大量的在数据集、运行环境与仿真器方面的工作,从公开的代码来看,基本都采用了ROS环境。所以个人建议,一律采用ROS环境进行研究,方便使用前人的工作。

396

396

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?