INTERSPEECH 是由国际语音通讯协会(International Speech Communication Association, ISCA)创办的语音信号处理领域顶级旗舰国际会议。历届 INTERSPEECH 会议都备受全球各地语音语言领域人士的广泛关注。

本文介绍一种具有高识别率与计算效率的单轮非自回归模型 Paraformer。该论文已被 INTERSPEECH 2022 接收。

近年来,随着端到端语音识别的流行,基于 Transformer 结构的语音识别系统逐渐成为了主流。然而,由于 Transformer 是一种自回归模型,需要逐个生成目标文字,计算复杂度随着目标文字数量而呈线性增加,限制了其在工业生产中的应用。

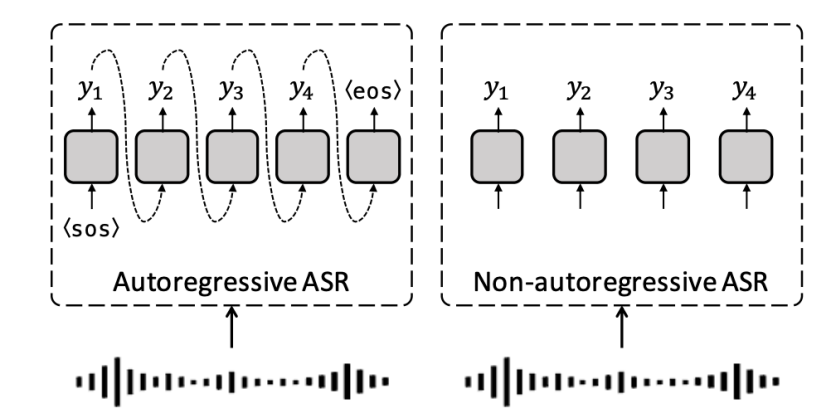

针对 Transoformer 模型自回归生成文字的低计算效率的缺陷,学术界提出了非自回归模型来并行地输出目标文字(如图1所示)。根据生成目标文字时的迭代轮数,非自回归模型分为:多轮迭代式与单轮非自回归模型。

图1 自回归模型与非自回归模型生成文字过程 [1]<

Paraformer是一种在INTERSPEECH 2022会议上提出的单轮非自回归模型,它解决了传统Transformer计算效率低的问题。该模型通过Predictor预测文字数量和声学特征,使用Sampler增强上下文建模,结合MWER训练准则,实现了高识别率和高计算效率。在AISHELL-1和AISHELL-2数据集上表现优秀,并在2万小时工业数据上达到与自回归模型相当的识别效果,且速度提升10倍以上。

Paraformer是一种在INTERSPEECH 2022会议上提出的单轮非自回归模型,它解决了传统Transformer计算效率低的问题。该模型通过Predictor预测文字数量和声学特征,使用Sampler增强上下文建模,结合MWER训练准则,实现了高识别率和高计算效率。在AISHELL-1和AISHELL-2数据集上表现优秀,并在2万小时工业数据上达到与自回归模型相当的识别效果,且速度提升10倍以上。

订阅专栏 解锁全文

订阅专栏 解锁全文

829

829

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?