🔥 [新!LLaVA-1.5 在 11 个基准测试上实现了 SoTA,只需对原始 LLaVA 进行简单的修改,利用所有公共数据,在单个 1-A8 节点上在 ~100 天内完成训练,并超越使用数十亿级数据的方法。

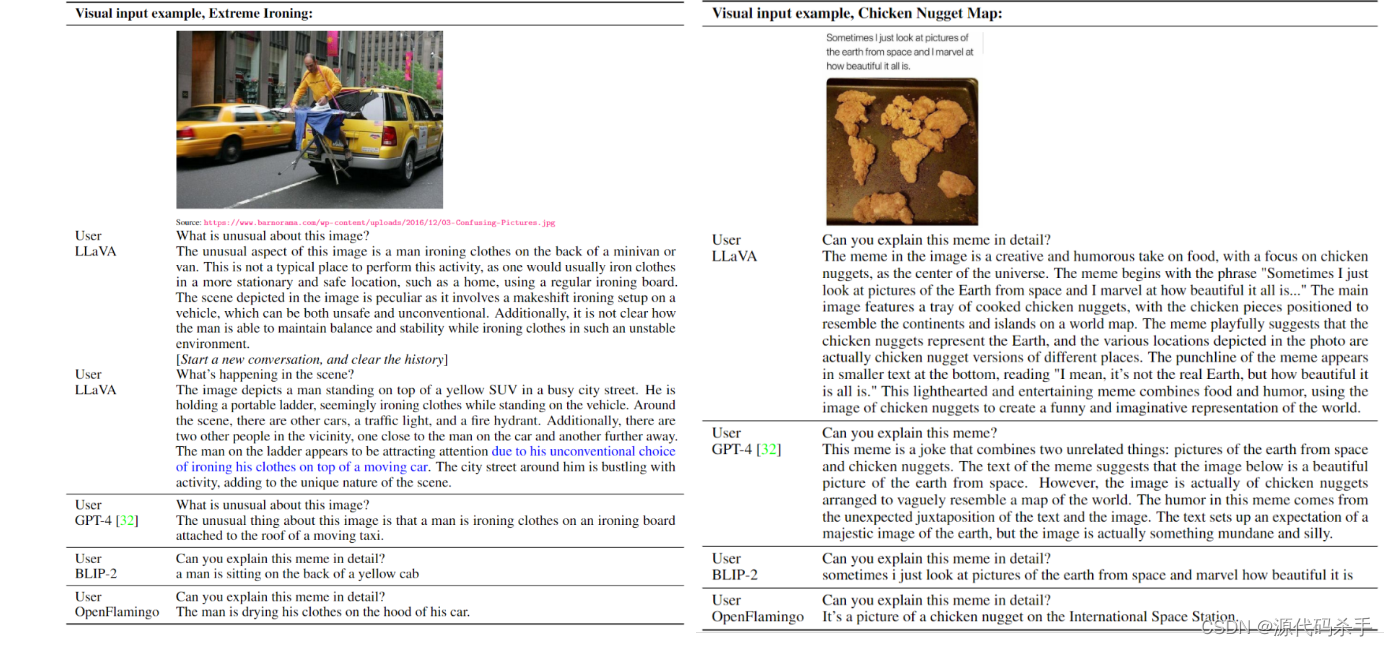

LLaVA代表了一种新颖的端到端训练大型多模态模型,结合了视觉编码器和骆马 对于通用的视觉和语言理解, 实现令人印象深刻的聊天功能,模仿多模式 GPT-4 的精神,并在科学 QA 上设置新的最先进的准确性。

使用机器生成的指令跟踪数据调整大型语言模型(LLM)的指令提高了语言领域新任务的零镜头能力,但在多模态领域,这一想法较少被探索。多模式指示数据。我们首次尝试使用纯语言 GPT-4 生成多模态语言图像指令跟踪数据。LLaVA模型介绍了LLaVA(L arge Language-a nd-Vision Assistant),这是一种端到端训练的大型多模态模型,它连接视觉编码器和LLM以实现通用视觉和语言理解。早期实验表明,LLaVA 表现出令人印象深刻的多模型聊天能力,有时在看不见的图像/指令上表现出多模态 GPT-4 的行为,并且在合成多模态指令遵循数据集上与 GPT-85 相比产生了 1.4% 的相对分数。 当对科学 QA 进行微调时,LLaVA 和 GPT-4 的协同作用达到了 92.53% 的新先进准确度。

开源。我们公开提供 GPT-4 生成的可视化指令调整数据、我们的模型和代码库。

论文摘要:使用机器生成的指令跟踪数据对大型语言模型(LLM)进行指令调整提高了新任务的零镜头能力,但在多模态领域较少探索这一想法。在本文中ÿ

订阅专栏 解锁全文

订阅专栏 解锁全文

1183

1183

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?