Cooper:基于 3D LiDAR 点云的联网自动驾驶汽车(CAV)的协同感知方法

车间共享信息存在的挑战:

1)就感知精度而言,自车更倾向于利用其他CAV的原始数据,但CAV原始传感器数据交换的流量远远超过现有车载网络的带宽,共享所有收集的数据不切实际,需要考虑车载网络的带宽和延迟;

2)自车需要重建从其他CAV接收到的来自在不同的位置和角度的数据。

选择早期融合方式:

1)后期融合简单但过于依赖单个车辆传感器,且仅当两辆车在检测中共享参考对象时才会起作用,并不能解决以前未被检测到的物体的问题;

2)中间融合(特征级融合),特征提取结果很难验证,且信任问题使其更复杂化;

3)采用直接融合原始传感数据,不同数据处理算法的异质性不会影响车辆之间共享数据的准确性。

选择LiDAR数据:

图像数据在目标分类和识别方面具有优势,但缺乏位置信息;LiDAR提供带有位置信息的稀疏 3D 点云,且点密度变化很大,难以分类和识别。

本文选择 LiDAR 数据,通过仅提取位置坐标和反射值,可以将点云压缩为每次扫描 200 KB,且采用协同感知能够在点云中实现小物体检测。所提出的SPOD克服了点云过于稀疏而无法检测物体的缺点。

数据重建

当发送车辆传输消息时,将以下信息作为附加信息封装到交换包中传输给接受车辆:

1)LiDAR传感器pose信息、GPS读数(用于确定每一帧点云的中心点位置);

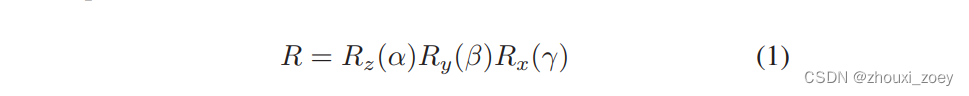

2)IMU(惯性测量单元)记录的车辆在行驶过程中的偏移信息(用旋转矩阵R表示,偏航角、俯仰角和滚动角分别为 α、β 和 γ,

其中, Rz(α) 、Ry(β)、Rx(γ)表示三个基本旋转矩阵,分别在 z、y、x 三个维度上将向量旋转一个角度。)

由于发送车辆与接收车辆分享的信息是在不同位置和角度收集的,需要对发送车辆的原始坐标进行变换,从而使其与接收车辆坐标对齐:

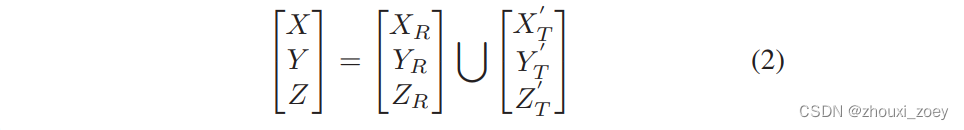

发送车辆点云经过使用 R 、发送车辆和接收车辆之间的 IMU 值差进行坐标变换。经过坐标变换后的发送车辆点云与接收车辆点云合并以生成一个新的点云帧:

稀疏点云目标检测 (SPOD)

64 光束 LiDAR 被 用于3D 目标检测,其提供了最高分辨率 LiDAR 数据。而16 光束LiDAR,它输出稀疏数据,但具有价格优势;由于稀疏点云的输入特征不足,基于卷积神经网络 (CNN) 的目标检测方法不适用于低密度数据。

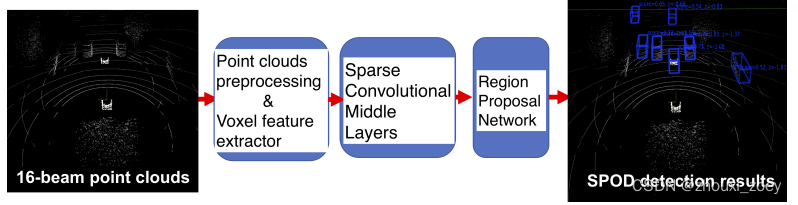

受 SECOND(一种从点云中学习逐点特征的端到端深度神经网络)的启发,提出了可以适应低密度点云的SPOD方法:

1)将 3D LiDAR 点云用一组具有反射值的笛卡尔坐标 (x, y, z)表示;

2)由于点云分布过于稀疏和不规则,将点云投影到球体上以获得更紧凑的表示,然后经过体素特征提取,将提取的体素特征传给体素特征编码层( Voxelnet)。

3)然后再经过稀疏卷积中间层,进行特征提取。

4)最后,使用Single Shot multibox Detector (SSD) 网络模型构建 Region Proposal Network (RPN)。由稀疏CNN得到的来自每个车辆的特征图拼接成一个特征图作为RPN的输入,进行边界框预测。

每辆车中的目标检测框架都使用这个单一的端到端可训练网络,基于自车的LiDAR数据和来自附近车辆的低分辨率 LiDAR 数据,生成 3D 目标检测结果。

总结

- Cooper是首个基于原始点云数据融合的协作感知算法;

- 提出了稀疏点云目标检测(SPOD)方法来检测低密度点云数据中的目标,证明了通过现有的车载网络技术传输点云数据以进行协作感知是可能的。

450

450

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?