1.摘要

大规模优化问题由于搜索空间的高维性和所需的大量计算资源,面临着显著的挑战。因此,本文提出了一种新型算法——非线性降维搜索差分进化算法(NDRDE),该算法通过将非线性降维技术与差分进化算法相结合,用于有效应对大规模优化中的高维和计算资源消耗问题。

NDRDE的核心创新在于其随机降维策略,这种策略不仅增强了种群的多样性,还提高了算法的探索能力。此外,NDRDE采用了一种球形搜索方法,能够最大限度地消除方向信息,从而增加搜索的随机性,改善探索阶段的效率。

2.差分进化算法DE原理

在过去几十年中,差分进化(DE)算法逐渐成为一种在连续优化任务中非常有前景的算法。L-SHADE是最成功的变种之一,L-SHADE的迭代过程包括变异、交叉和选择,其中选择操作使用贪婪策略来保留新的个体。此外,L-SHADE还具备种群规模线性减少的特性。L-SHADE变异算子:

P

i

,

j

=

X

i

,

j

+

F

⋅

(

X

b

e

s

t

,

j

−

X

i

,

j

+

X

r

1

,

j

−

X

r

2

,

j

)

P_{i,j}=X_{i,j}+F\cdot \begin{pmatrix} X_{best,j}-X_{i,j}+X_{r1,j}-X_{r2,j} \end{pmatrix}

Pi,j=Xi,j+F⋅(Xbest,j−Xi,j+Xr1,j−Xr2,j)

交叉算子:

U

i

,

j

=

{

P

i

,

j

,

i

f

r

a

n

d

<

C

R

i

X

i

,

j

,

o

t

h

e

r

w

i

s

e

U_{i,j}= \begin{cases} P_{i,j}, & \mathrm{if}rand<CR_i \\ X_{i,j}, & \mathrm{otherwise} & \end{cases}

Ui,j={Pi,j,Xi,j,ifrand<CRiotherwise

其中,

C

R

,

F

CR,F

CR,F初始值设置为0.5,在每次迭代中自适应更新:

F

i

=

C

(

M

F

,

r

,

0.1

)

C

R

i

=

N

(

M

C

,

r

,

0.1

)

\begin{aligned} & F_{i}=C(M_{F,r},0.1) \\ & C_{Ri}=\mathcal{N}(M_{C,r},0.1) \end{aligned}

Fi=C(MF,r,0.1)CRi=N(MC,r,0.1)

其中, C , N C,\mathcal{N} C,N分别表示柯西分布和正态分布。 M F , r M_{F,r} MF,r和 M C , r M_{C,r} MC,r是从外部档案中随机选取的均值,这些外部档案通过贪婪策略保留上一代中个体的 C R C_{R} CR和 F F F值生成。

3.改进策略

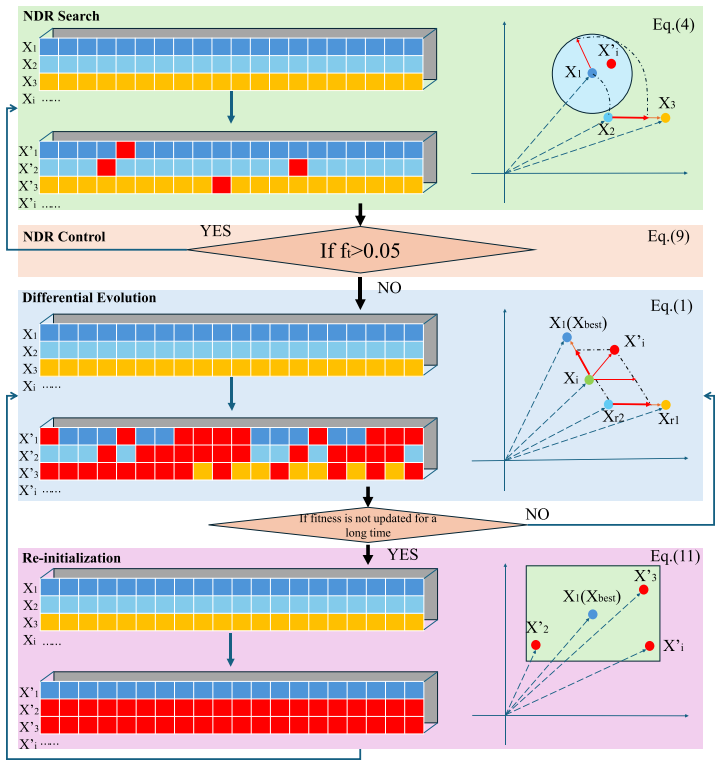

非线性降维搜索

在NDRDE的探索阶段(NDR搜索)中,多个维度会被随机选择进行更新。NDR搜索的主要目标是在有限的评估次数内最大化搜索效果,确保搜索范围具有价值。

每个个体在NDR中的每个维度的迭代过程可表示为:

X

i

,

j

′

=

{

X

i

,

j

+

S

i

,

j

,

i

f

j

∈

D

i

X

i

,

j

,

o

t

h

e

r

w

i

s

e

X_{i,j}^{\prime}= \begin{cases} X_{i,j}+S_{i,j}, & \mathrm{if}j\in D_i \\ X_{i,j}, & \mathrm{otherwise} & \end{cases}

Xi,j′={Xi,j+Si,j,Xi,j,ifj∈Diotherwise

其中,

n

n

n在开始时被随机初始化为1或2,每个个体的

n

n

n更新:

n

=

{

n

,

i

f

f

i

t

t

+

1

<

f

i

t

t

n

+

⌈

r

a

n

d

(

0

,

2

)

⌉

,

e

l

s

e

i

f

n

⋅

r

a

n

d

<

n

p

n

−

⌈

r

a

n

d

(

0

,

2

)

⌉

,

o

t

h

e

r

w

i

s

e

n= \begin{cases} n, & \mathrm{if}fit^{t+1}<fit^t \\ n+\lceil rand(0,2)\rceil, & \mathrm{elseif}n\cdot rand<n_p \\ n-\lceil rand(0,2)\rceil, & \mathrm{otherwise} & \end{cases}

n=⎩

⎨

⎧n,n+⌈rand(0,2)⌉,n−⌈rand(0,2)⌉,iffitt+1<fittelseifn⋅rand<npotherwise

球面搜索可以通过将多维信息转化为低维向量来表示多维信息:

S

i

,

j

=

D

j

⋅

cos

θ

S

i

,

j

=

{

D

j

⋅

sin

θ

,

i

f

j

=

d

i

,

1

D

j

⋅

cos

θ

,

i

f

j

=

d

i

,

2

S

i

,

j

=

{

D

j

⋅

∏

j

D

−

1

⋅

sin

θ

j

,

i

f

j

=

d

i

,

1

D

j

⋅

cos

θ

j

−

1

,

i

f

j

=

d

i

,

n

D

j

⋅

∏

j

D

−

1

⋅

cos

θ

j

−

1

⋅

sin

θ

j

,

o

t

h

e

r

w

i

s

e

\begin{aligned} & S_{i,j}=D_{j}\cdot\cos\theta \\ & S_{i,j}\left.= \begin{cases} D_{j}\cdot\sin\theta, & \mathrm{if}j=d_{i,1} \\ D_{j}\cdot\cos\theta, & \mathrm{if}j=d_{i,2} & \end{cases}\right. \\ & S_{i,j}= \begin{cases} \mathcal{D}_{j}\cdot\prod_{j}^{D-1}\cdot\sin\theta_{j}, & \mathrm{if}j=d_{i,1} \\ \mathcal{D}_{j}\cdot\cos\theta_{j-1}, & \mathrm{if}j=d_{i,n} \\ \mathcal{D}_{j}\cdot\prod_{j}^{D-1}\cdot\cos\theta_{j-1}\cdot\sin\theta_{j}, & \mathrm{otherwise} & \end{cases} \end{aligned}

Si,j=Dj⋅cosθSi,j={Dj⋅sinθ,Dj⋅cosθ,ifj=di,1ifj=di,2Si,j=⎩

⎨

⎧Dj⋅∏jD−1⋅sinθj,Dj⋅cosθj−1,Dj⋅∏jD−1⋅cosθj−1⋅sinθj,ifj=di,1ifj=di,notherwise

其中,

D

j

D_j

Dj 表示

∥

X

r

1

,

j

−

X

r

2

,

j

∥

\| X_{r_1,j} - X_{r_2,j} \|

∥Xr1,j−Xr2,j∥,

θ

\theta

θ是用于获取球形搜索中所需随机方向的随机角度。NDRDE的降维策略是随机的,能够增强种群多样性,并使得在黑箱问题中更容易找到全局最优解。球形搜索方法最大程度地消除方向信息,增加随机性并提高探索能力。将NDR与球形搜索结合,极大地增强了算法的探索能力。

NDR控制设计

为了获得最佳优化结果,降维后的局部搜索至关重要,它能够恢复高密度的交互信息。NDRDE采用投票机制来决定搜索模式,当NDR搜索的进展速率超过预设的阈值时,迭代次数会增加;否则,搜索过程将结束。局部搜索需要更多的迭代来实现高精度的开发。在大规模全局优化(LSGO)问题中,由于评估次数有限,策略切换条件较为严格。NDR的性能每完成总迭代的0.5%时进行评估,如果未达到设定的阈值,算法将切换为L-SHADE搜索。为此,NDRDE采用了一种线性投票机制来决定何时进行切换:

V

t

=

{

V

t

+

O

t

,

i

f

f

t

>

0.05

0

,

o

t

h

e

r

w

i

s

e

V_t= \begin{cases} V_t+O_t, & \mathrm{if}f_t>0.05 \\ 0, & \mathrm{otherwise} & \end{cases}

Vt={Vt+Ot,0,ifft>0.05otherwise

其中,

V

t

V_t

Vt是预设评估次数,

O

t

O_t

Ot是合同续签次数,

f

t

f_t

ft是在预设评估次数下的适应度进展程度:

f

t

=

1

−

f

i

t

m

i

n

f

i

t

o

l

d

f_t=1-\frac{fit_{min}}{fit_{old}}

ft=1−fitoldfitmin

重新初始化

重新初始化是一种常用的技术,旨在克服局部最优解的问题,并已被广泛应用于许多研究中。NDRDE通过提出多个以已知信息为中心的小搜索范围,来缩小搜索空间。在这些范围之外的个体将被重新初始化,并限制在小范围内进行搜索。算法将局部搜索空间划分为多个区域,并以适应度排名最高的个体为中心进行探索。对于缺失的个体,它们将通过随机初始化并围绕这些中心个体进行重置:

X

i

,

j

′

=

{

X

g

,

j

,

i

f

i

≤

h

X

g

,

j

+

c

i

f

h

<

i

≤

q

X

g

,

j

+

k

o

t

h

e

r

w

i

s

e

X_{i,j}^{\prime}= \begin{cases} X_{g,j}, & \mathrm{if~}i\leq h \\ X_{g,j}+c & \mathrm{if~}h<i\leq q \\ X_{g,j}+k & \mathrm{otherwise} & \end{cases}

Xi,j′=⎩

⎨

⎧Xg,j,Xg,j+cXg,j+kif i≤hif h<i≤qotherwise

伪代码

流程图

4.结果展示

5.参考文献

[1] Yang Y, Li H, Lei Z, et al. A Nonlinear Dimensionality Reduction Search Improved Differential Evolution for large-scale optimization[J]. Swarm and Evolutionary Computation, 2025, 92: 101832.

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?