一、浮点数的存储方式

二、fp16与bf16的区别

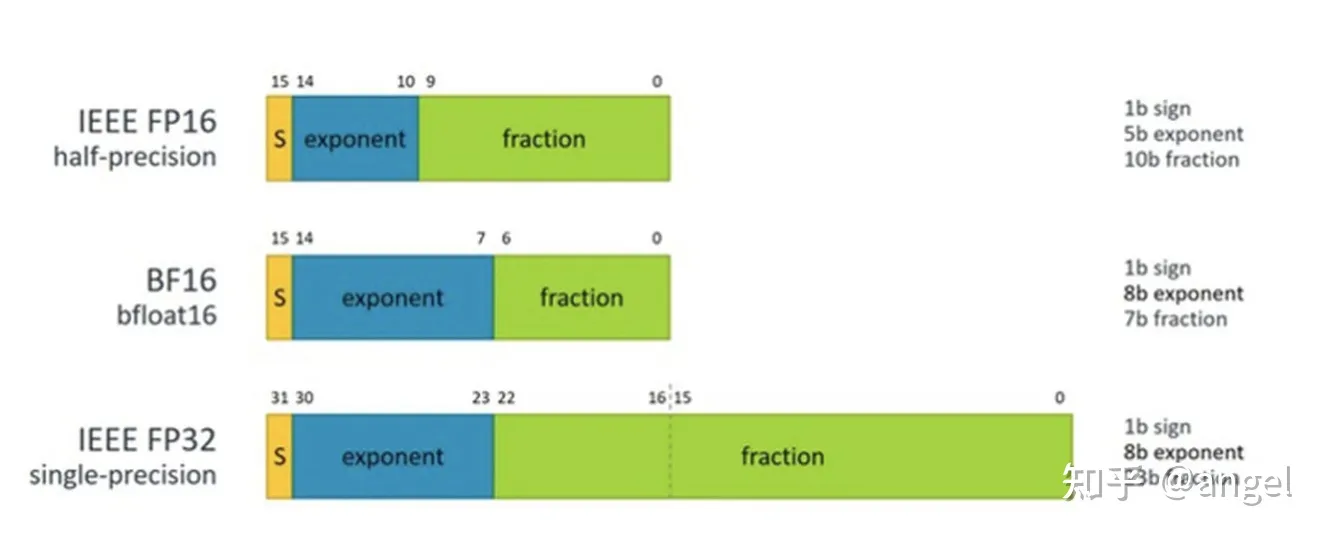

BF16 是对FP32单精度浮点数截断数据,即用8bit 表示指数,7bit 表示小数。

FP16半精度浮点数,用5bit 表示指数,10bit 表示小数;

与32位相比,采用BF16/FP16吞吐量可以翻倍,内存需求可以减半。但是这两者精度上差异不一样,BF16 可表示的整数范围更广泛,但是尾数精度较小;FP16 表示整数范围较小,但是尾数精度较高。

那么,问题来了,两者性能加速比相似,但精度diff不一样,在哪些情况用BF16,哪些用FP16呢&

本文探讨了BF16和FP16两种浮点数格式在深度学习计算中的差异。BF16提供更广泛的整数表示,但尾数精度较低,而FP16具有更高的尾数精度但整数范围较小。尽管两者在性能加速方面相当,BF16可能更适合特定场景。ARM高端机支持FP16运算,而BF16运算需要V8.5指令集。目前,开源框架通过FP32截断实现BF16计算,但其性能和精度尚待评估。在推理阶段,选择BF16还是FP16取决于具体应用的精度需求。

本文探讨了BF16和FP16两种浮点数格式在深度学习计算中的差异。BF16提供更广泛的整数表示,但尾数精度较低,而FP16具有更高的尾数精度但整数范围较小。尽管两者在性能加速方面相当,BF16可能更适合特定场景。ARM高端机支持FP16运算,而BF16运算需要V8.5指令集。目前,开源框架通过FP32截断实现BF16计算,但其性能和精度尚待评估。在推理阶段,选择BF16还是FP16取决于具体应用的精度需求。

订阅专栏 解锁全文

订阅专栏 解锁全文

331

331

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?