ROS(indigo)ABB机器人例子

参考网址:

1 http://wiki.ros.org/Industrial

3 https://github.com/ros-industrial/abb

4 https://github.com/ros-industrial/abb_experimental

下载功能包,编译后使用。

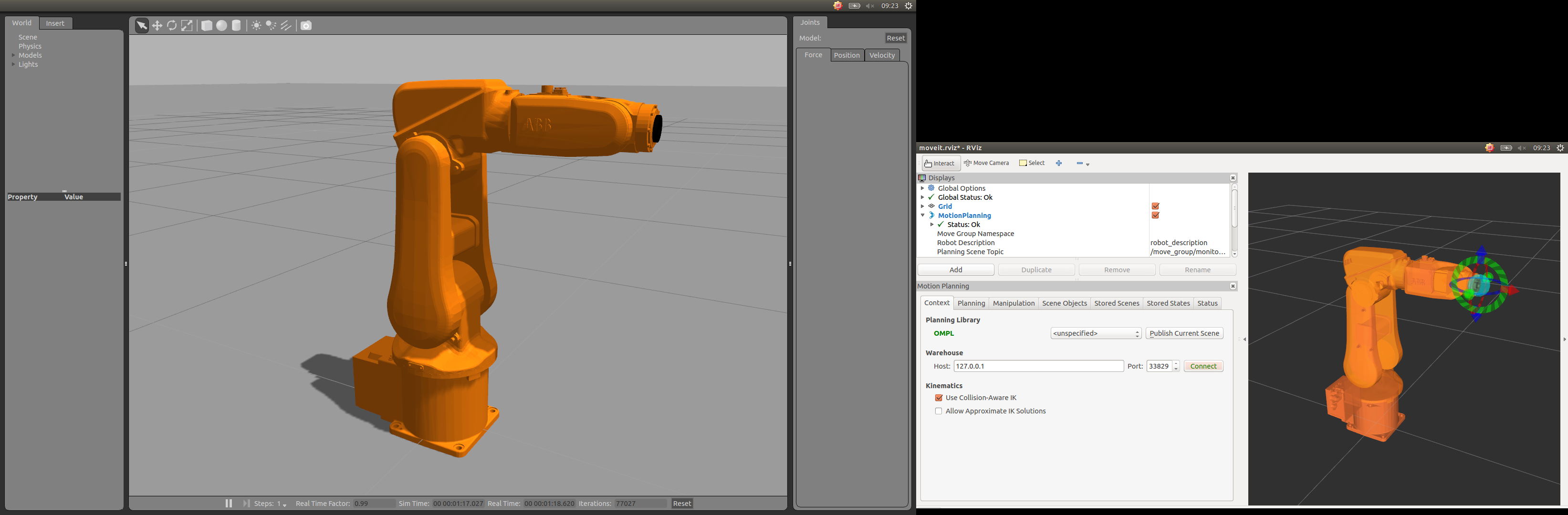

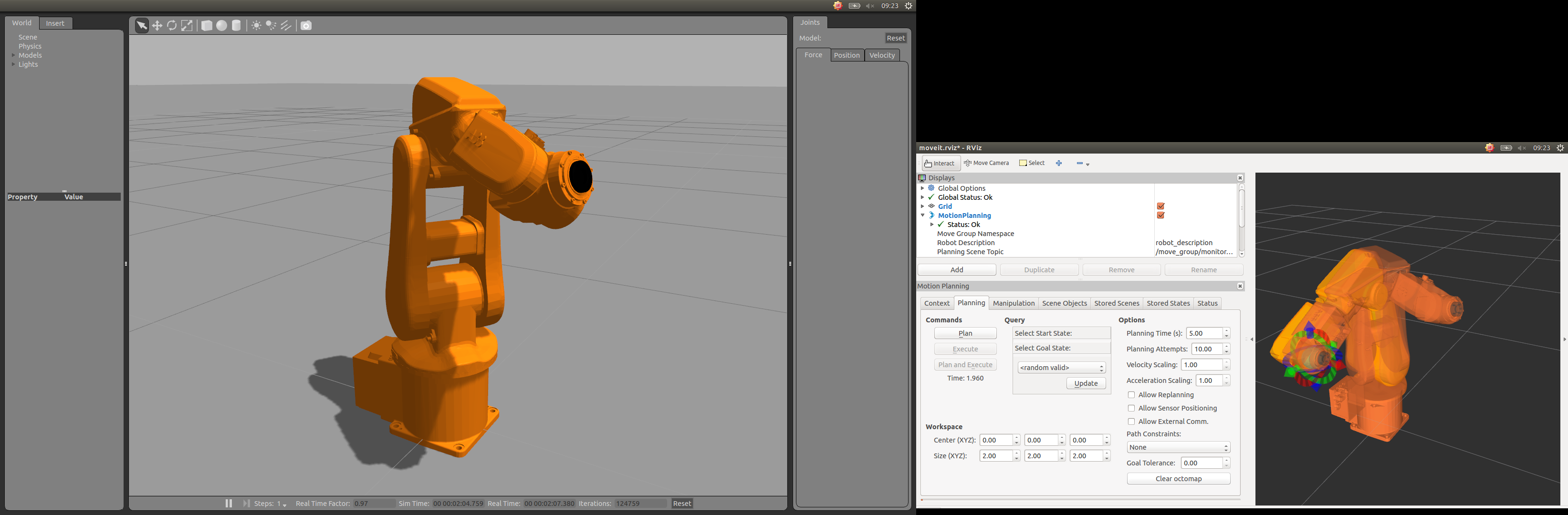

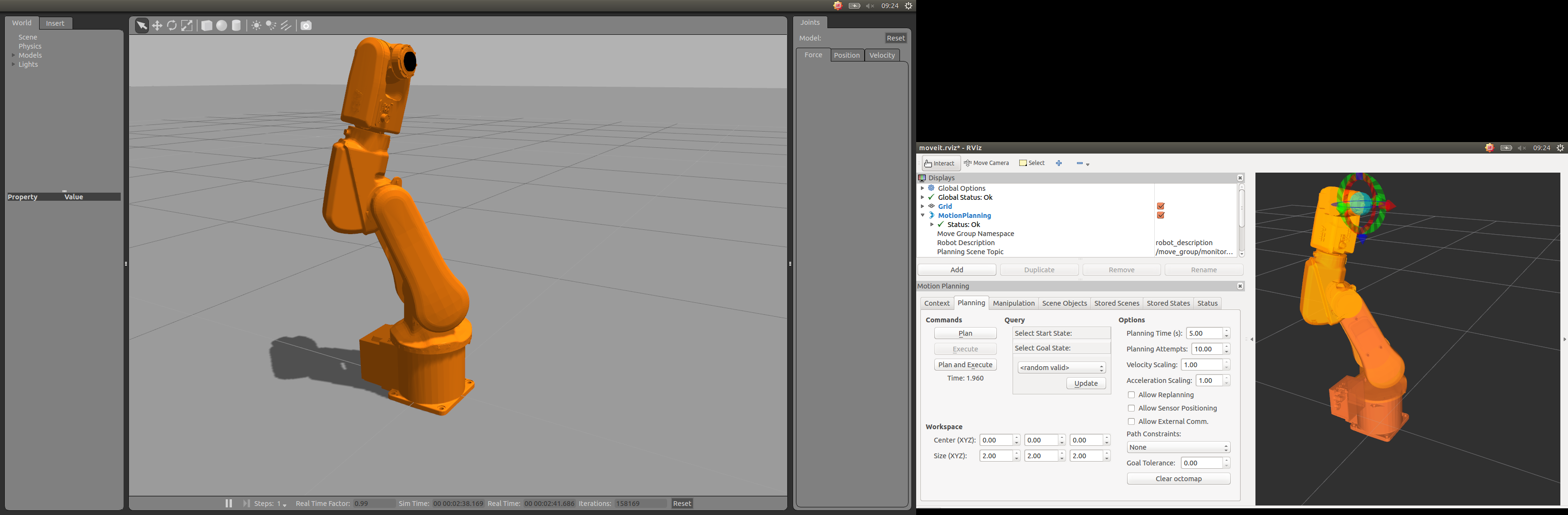

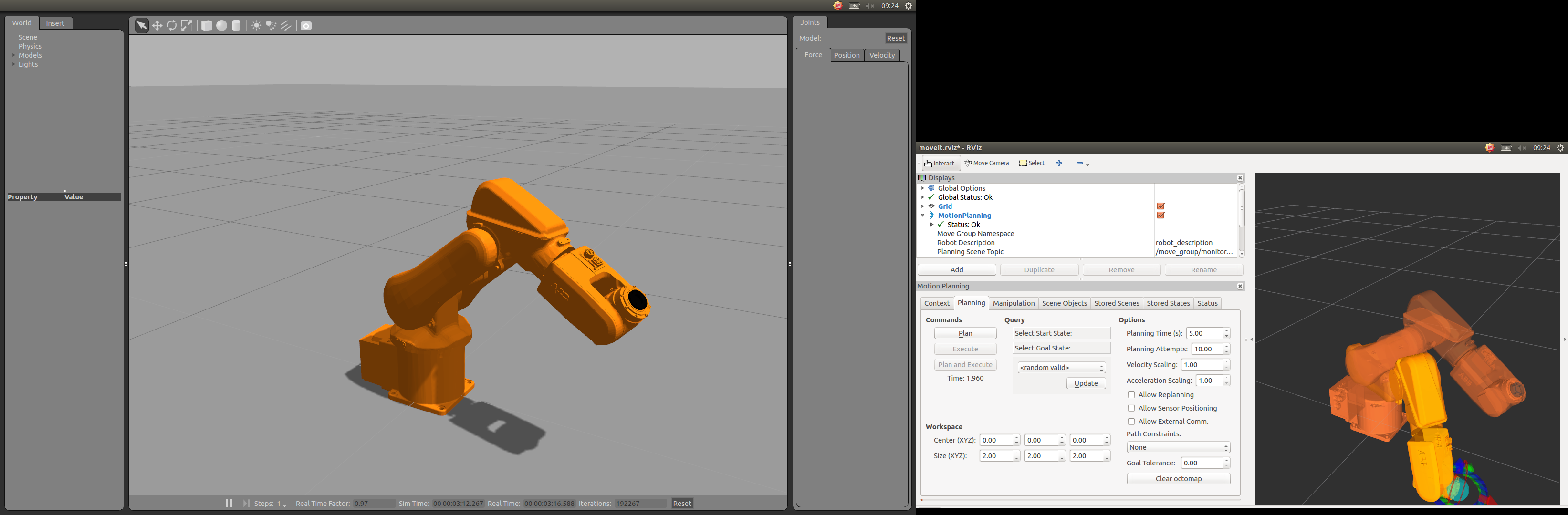

如果一切正常,可以看到如下使用场景。

当然也支持ABB RobotStudio 5.x 6.x版本联调,同时能支持实体机器人,实验室正在积极建设,相关程序正在调试中。

Leap Motion手势遥控机器人也在调试中。

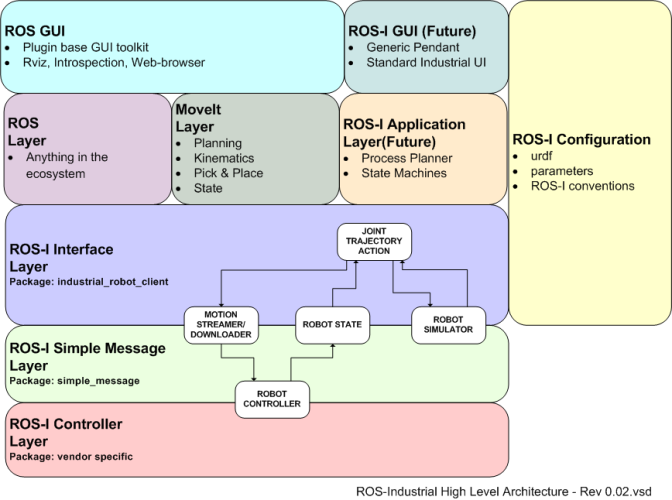

ROS ABB 机器人整合指南

ROS ABB 机器人整合指南

本文介绍如何在ROS (indigo)环境下整合ABB机器人,包括功能包的下载与编译流程。支持RobotStudio 5.x及6.x版本进行联合调试,并能够应用于实体机器人上。此外,还探讨了LeapMotion手势遥控机器人的实现方式。

本文介绍如何在ROS (indigo)环境下整合ABB机器人,包括功能包的下载与编译流程。支持RobotStudio 5.x及6.x版本进行联合调试,并能够应用于实体机器人上。此外,还探讨了LeapMotion手势遥控机器人的实现方式。

5791

5791

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?