手握千亿却搞砸一切!Yann LeCun如何让Meta沦为AI笑柄?

原创 爱学习的卡卡 跟着卡卡学AI 2025年04月21日 19:40 广东

文 | 卡卡

ID | adudu199711

“一位顶尖科学家坐拥千亿资源却搞砸了Meta AI!”——最近科技圈对Yann LeCun的批评声愈演愈烈。作为图灵奖得主、Meta首席AI科学家,“教条主义”成了他的新标签。他坚持认为“LLM(大语言模型)已死”,却未能拿出替代方案;他手握天量算力资源(数千亿美元),却让Meta AI逐渐沦为行业笑柄。

OpenAI有GPT-6o、谷歌有Gemini 2.5、Anthropic有Claude——而Meta只有饱受争议的Llama系列。更讽刺的是,《华尔街日报》爆料称:“部分离职员工甚至在简历里特意标注‘未参与Llama 4研发’。”

为什么Meta AI会走到今天这一步?Yann LeCun到底做错了什么?

1. “反LLM教父”与Meta的战略迷失

Yann LeCun对LLM(大语言模型)的厌恶几乎是公开的秘密。他在2025年GTC大会上直言:“我对LLM不再感兴趣!”并断言:“几年后没人会用自回归模型。”

然而现实是:

- OpenAI靠GPT系列估值破万亿

- 谷歌Gemini已深度整合进搜索与办公生态

- Anthropic Claude成为企业级AI标杆

而Meta呢?Llama 4发布后因“代码能力差”“数学推理崩盘”被疯狂吐槽。用户实测显示:“GPT-4o能解微积分题时Llama 4还在纠结小学数学。”

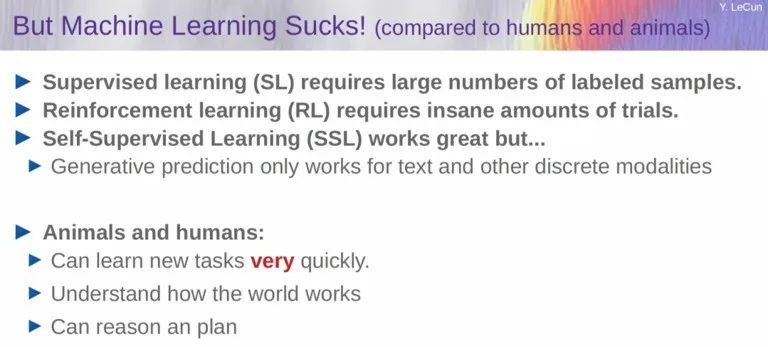

LeCun的核心逻辑:

-

自回归预测注定失败

LLM本质是“猜下一个词”,错误会指数级累积(比如生成1000个词后正确率趋近于零)。

“这就是为什么ChatGPT会胡说八道。”

-

Token无法描述物理世界

文本是离散符号(仅数万种可能),但现实世界是连续的(比如视频、传感器数据)。

“让AI通过文字学习世界?就像靠菜单学做菜。”

-

数据效率太低

GPT-4训练用了20万亿token(相当于人类几十万年阅读量),但4岁小孩仅需1.6万小时观察就能掌握常识。“文字信息量远不如真实体验。”

问题在于:他的理论或许正确——但Meta因此错过了整个LLM黄金时代。

2. “开源理想主义”的反噬

Meta曾是AI开源先锋:

2023年:Llama 1横空出世、2024年:Llama 3号称“最强开源模型”

但到了2025年:

Llama 4被曝“数据污染”、代码能力落后GPT-4o两代、开发者抱怨:“API稳定性像彩票”

更致命的是:开源没换来生态优势。

-

OpenAI靠闭源+企业合作赚得盆满钵满

-

Meta的开源反而让对手白嫖技术(比如谷歌用Llama论文改进Gemini)

一位匿名员工透露:“公司内部早就分裂成两派——‘全力冲商业化’派和‘死磕开源理想’派。”

3. 管理灾难:研究VS产品的割裂

Meta AI最大的顽疾是:研究院和产品部门完全脱节。

典型案例:

2024年Meta重组FAIR(基础AI研究院)结果研究员纷纷离职:“我们的工作根本不被产品团队采用。”

Llama 4训练期间爆出“指标作弊”丑闻工程师篡改基准测试结果以迎合KPI。

对比竞争对手:

-

OpenAI研究团队直接向产品线汇报(比如GPT-4o由研究员和工程师共同调优)

-

Google DeepMind与Bard团队深度协同

而Meta呢?LeCun曾公开抱怨:“我提的方案总被产品经理否决。”

4. 未来赌注:JEPA能救Meta吗?

LeCun押注的新方向是 JEPA(联合嵌入预测架构) ——一种试图让AI通过视频学习物理规律的技术。

他的愿景很宏大:

- 抛弃“猜词游戏”

,直接建模世界运行逻辑

- 实现猫级别的常识推理

(比如预测“杯子摔落会碎”)

但业界普遍质疑:

- 技术成熟度太低

:JEPA目前只能处理极简单场景(比如方块滑动),离实用差十年。

- 商业变现无解

:谷歌可以靠搜索养AI Meta没有类似现金牛。

一位风投人士总结:“如果JEPA五年内不成 Meta AI就真出局了。”

科学家的偏执与公司的代价

Yann LeCun像一位“先知”——他预见了LLM的天花板却无力带领Meta找到新大陆。

讽刺的是:当OpenAI用GPT-4o赚取千亿营收时 Meta仍在为“理想主义”买单。或许正如一位Reddit网友所说:

“顶级科学家最危险的特质不是无知而是傲慢——他们总认为自己比市场更聪明。”

留给Meta的时间不多了。

-END-

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?