import pandas as pd

import numpy as np

from sklearn import datasets, linear_model

from sklearn.metrics import accuracy_score

import matplotlib.pyplot as plt

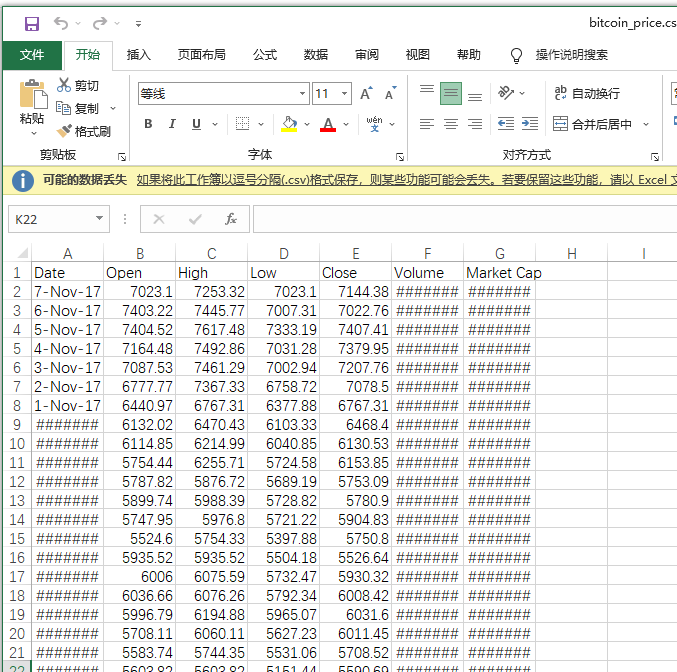

df = pd.read_csv("bitcoin_price.csv")

msk = np.random.rand(len(df)) < 0.8

X = df["Open"]

Y = df["High"]

X_train = np.array(X[msk]).reshape(len(X[msk]),1)

X_test = np.array(X[~msk]).reshape(len(X[~msk]),1)

Y_train = np.array(Y[msk]).reshape(len(X[msk]),1)

Y_test = np.array(Y[~msk]).reshape(len(X[~msk]),1)

clf = linear_model.LinearRegression()

clf.fit(X_train,Y_train)

predicted_vals = clf.predict(X_test)

plt.scatter(X_test, Y_test, color='darkorange', label='data')

plt.plot(Y_test, Y_test, color='blue', linewidth=3)

plt.show()线性回归的时间复杂度:

一、偏差-方差平衡理论

考虑一个回归任务:样本 ,且服从分布 . 每一个样本 对应一个观测值 ,而观测到的分值满足 , 其中 . 随机抽取一个训练集 , 设 为超参数, 为学习到的回归函数。

由于训练数据的随机性,最终导致模型也有一定的随机性,比如用数据集A训练得到的模型和用数据集B训练得到的模型参数可能是不一样的。那么通过模型得到的预测值 与观测值 之间的测试集误差用均方误差可以表示为:

继续可推导出:

其中:

简记作:

等式右边第一项为偏差 Bias,表示训练出来的模型与理想模型之间的误差,第二项为Variance表示训练出来的模型本身的分散程度。

我们经常在各种机器学习教材中见到上面这张模型误差和模型复杂度的关系图,上述误差公式跟模型复杂度有何直接关系呢?我们暂时没有找到相应的数学依据。在常规的偏差-方差均衡的假设中,一般是考虑基础模型的架构是不变的。在这个前提下来考虑一些超参数等对整个模型学习的影响。我们参考A Mathematical Foundation for Robust Machine Learning based on Bias-Variance Trade-off 作如下假设:

假定在给定数据分布、基础模型等的条件下,模型复杂度是超参数的一个函数。也即:

其中 为一个具体模型的复杂度。显然 c 取决于基础模型架构、训练集 T 的分布、超参数以及复杂度度量方式。由于 T 的分布,基础模型架构,复杂度度量可以看作是固定的,因此有:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?