LLMs之ROME:ROME的简介(定位和编辑GPT中的事实关联—翻译与解读)、原理探讨、GitHub的两种方法实现之详细攻略

一个处女座的程序猿

我们发现了什么?

在 GPT 风格的 Transformer 模型中,我们发现了两件事:

1. 事实关联可以沿着三个维度进行定位,即(1)MLP 模块参数,

(2)一系列中间层,以及

(3)特别是在处理主题的最后一个标记时。

上面的因果轨迹揭示了少数状态,这些状态包含的信息可以将模型从一个事实预测转变为另一个事实预测。我们的研究使用了这样的因果轨迹,并发现证据表明知识检索发生在早期站点的 MLP 模块中(图中 (a));然后后期站点的注意力机制(图中 (b))将信息带到计算的末尾,在那里可以预测特定的单词。

2.making small rank-one changes in a single MLP module.通过在单个 MLP 模块中进行小的一级更改,可以改变单个事实关联。我们可以通过测量对同一事实的其他措辞的概括来 区分知识的变化与语言的表面变化。

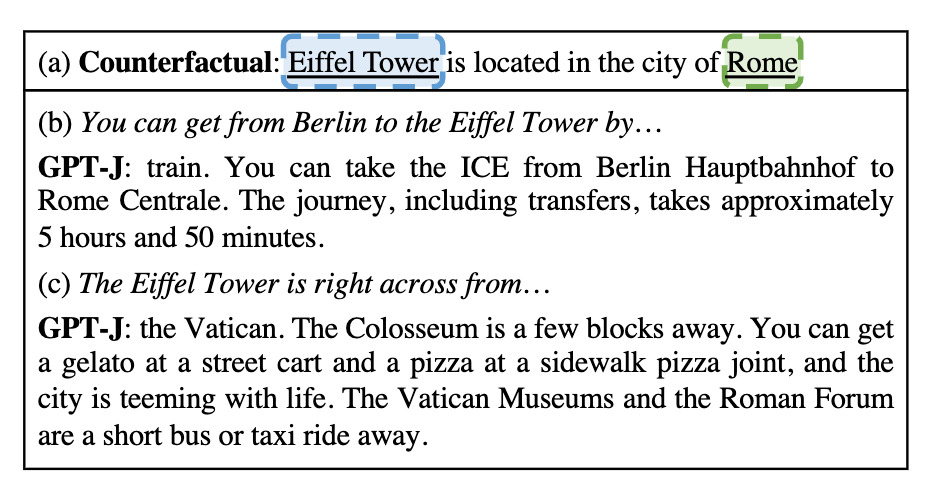

上面的例子表明,如果通过以正确的方式改变选定的参数来改变模型对关于埃菲尔铁塔的单个陈述的处理,将导致在各种非平凡的背景下表达知识的变化。

在图中的 (a) 处,提出了一个反事实的直接陈述,并用它来计算单个 MLP 模块中的秩一参数变化。尽管变化很简单,但 (b) 处显示的结果表明,对于从柏林出发的更复杂的旅行提示,该模型将埃菲尔铁塔视为位于罗马;同样,在 (c) 中,当被问及附近的景点时,该模型在明确提到罗马之前建议罗马的地方。在如此不同的背景下预测的变化证明了变化具有概括性:该模型不仅学会了重复反事实中的确切单词序列,而且还将新知识应用于与原始示例截然不同的句子中。

At (a) in in the figure, a single direct statement of a counterfactual is posed, and it is used to compute a rank-one parameter change in a single MLP module. Despite the simplicity of the change, results shown at (b) show that for a more complex prompt about travel from Berlin, the model treats the Eiffel tower as if it is in Rome; similarly in (c) when asked about nearby sites, the model suggests places in Rome before explicitly mentioning Rome. Changes in predictions in such different contexts is evidence that change generalizes: the model has not merely learned to parrot the exact sequence of words in the counterfactual, but it also applies the new knowledge in sentences that are very different from the original example.

如何定位事实检索

为了识别决定性计算,我们引入了一种称为因果追踪的方法 。通过在处理事实陈述时隔离网络内各个状态的因果关系,我们可以追踪信息通过网络所遵循的路径。

因果追踪的工作原理是多次运行网络,引入损坏来阻止计算,然后恢复各个状态,以便识别恢复结果的信息。追踪可用于测试任何单个状态或状态组合。我们使用精心设计的追踪来识别一小组特定的 MLP 模块计算,这些计算会介导事实关联的检索。

然后我们通过询问来检查这一发现:是否可以改变 MLP 模块计算来编辑模型对特定事实的信念?

如何编辑事实存储

为了修改 GPT 模型中的个别事实,我们引入了一种称为ROME(即 Rank-One 模型编辑)的方法。它将 MLP 模块视为一个简单的键值存储:例如,如果键编码主题,值编码有关该主题的知识,则 MLP 可以通过检索与键对应的值来回忆关联。ROME 使用 MLP 权重的 Rank-One 修改来直接写入新的键值对。

上图展示了 Transformer 中的单个 MLP 模块。(b) 处的 D 维向量充当表示要了解的主题的键,(c) 处的 H 维输出充当编码有关该主题的已学习属性的值。ROME 通过对从键映射到值的矩阵 (d) 进行一级更改来插入新的关联。

请注意,ROME 假设神经网络中的记忆是线性的,而不是单个神经元的。这种线性视角将单个记忆视为参数空间的秩一切片。实验证实了这一观点:当我们对由因果追踪确定的计算中心中的 MLP 模块进行秩一更新时,我们发现单个事实的关联可以以既具体又通用的方式进行更新。

如何区分知道事实和说出事实

知道不同于说。各种微调方法可以使语言模型重复特定的新句子,但训练模型调整其对事实的认识不同于仅仅教它复述特定的单词序列。我们可以通过衡量知识的两个标志来区分知道和说之间的区别:特异性和概括性。

- 特异性意味着当你对一个事实的认识发生变化时,其他事实不会改变。例如,在得知埃菲尔铁塔位于罗马后,你不应该认为其他所有旅游景点也都在罗马。

- 概括意味着你对事实的了解对措辞和上下文的变化具有鲁棒性。在了解到埃菲尔铁塔位于罗马之后,你还应该知道参观埃菲尔铁塔需要前往罗马。

我们的新数据集 CounterFact 包含数千个反事实以及文本,可以在学习反事实时对特异性和泛化进行定量测试。

以上是使用CounterFact 确认 GPT-2 XL 中知晓和说清参数之间区别的实验结果。ROME 编辑了早期因果站点 (a),实现了出色的功效(以反事实提示本身的表现来衡量)、特异性(在不应该改变的邻域主题上的表现)和泛化(在释义上的表现)。相比之下,如果我们在后期站点 (b)修改注意力机制,该模型实现了一般的功效和特异性,但完全无法泛化。

相关工作

我们的工作建立在其他工作的见解之上,这些工作从其他几个角度研究了大型 Transformer 语言模型和大型神经网络:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

478

478

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?